Die von Alibaba Cloud entwickelte KI-Großmodellreihe Qwen hat kürzlich einen wichtigen Fortschritt erzielt: Die Unterstützung für das Nachfolgemodell Qwen3 wurde offiziell in den Code-Repository von vLLM (ein hocheffizientes Inferenzframework für große Sprachmodelle) integriert. Diese Nachricht löste in der Tech-Branche lebhafte Diskussionen aus und signalisiert, dass die Veröffentlichung von Qwen3 unmittelbar bevorsteht.

Qwen3 wird Berichten zufolge mindestens zwei Versionen umfassen: Qwen3-8B und Qwen3-MoE-15B-A2B. Diese repräsentieren unterschiedliche Größen und Architekturansätze und wecken große Erwartungen bei Entwicklern und Unternehmenskunden.

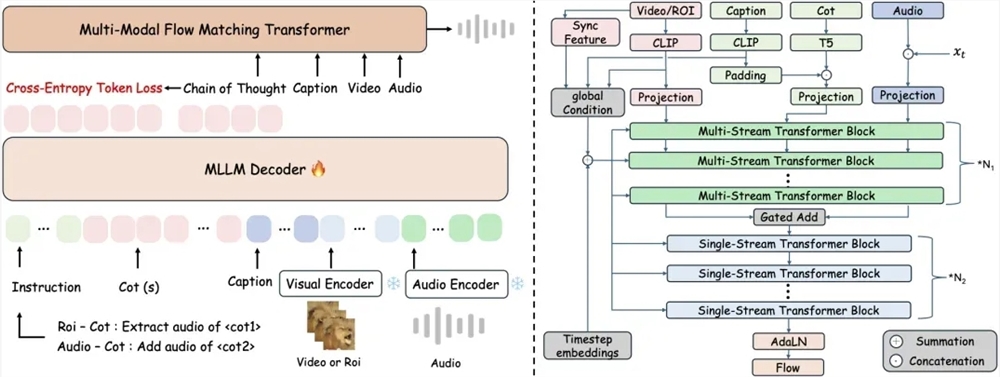

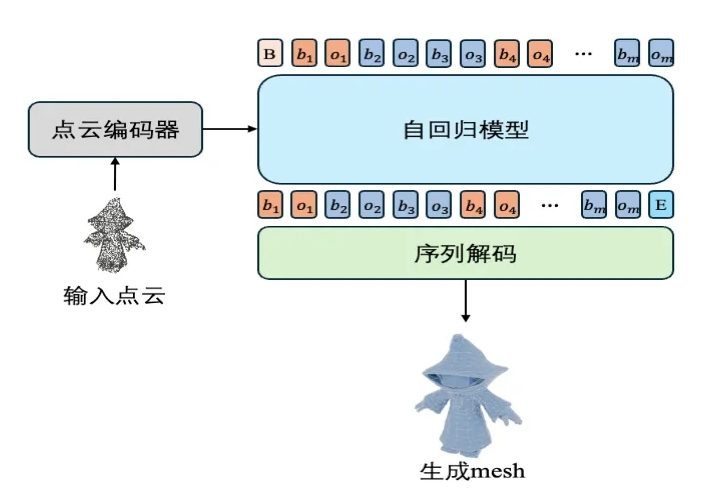

Qwen3-8B, das Basismodell der Reihe, wird voraussichtlich die hervorragende Leistung der Qwen-Familie in Aufgaben der Sprachverarbeitung und -generierung fortsetzen. Branchenexperten spekulieren über einen möglichen Durchbruch in der multimodalen Fähigkeit, d.h. die gleichzeitige Verarbeitung von Text, Bildern und anderen Datentypen, um ein breiteres Anwendungsspektrum abzudecken. Qwen3-MoE-15B-A2B hingegen nutzt eine Mixture-of-Experts (MoE)-Architektur mit 1,5 Milliarden Parametern, von denen etwa 200 Millionen aktiv sind. Dieses Design zielt darauf ab, durch einen effizienten Experten-Routing-Mechanismus eine Leistung zu erzielen, die der größerer Modelle nahekommt, bei gleichzeitig geringeren Rechenkosten.

Die Integration der Qwen3-Unterstützung in vLLM bedeutet, dass Entwickler dieses leistungsstarke Inferenzframework nutzen können, um Qwen3-Modelle einfach bereitzustellen und schnelle und stabile Inferenzaufgaben zu ermöglichen. vLLM ist bekannt für sein effizientes Speichermanagement und seine parallelen Verarbeitungsfähigkeiten, die die Ausführungseffizienz großer Modelle in Produktionssystemen deutlich verbessern. Dieser Fortschritt ebnet nicht nur den Weg für die praktische Anwendung von Qwen3, sondern stärkt auch die Position von Alibaba Cloud im Open-Source-KI-Ökosystem.

Obwohl die genauen Funktionen und Leistungsdetails von Qwen3 noch nicht vollständig veröffentlicht wurden, werden große Erwartungen an das Modell gerichtet. Die Qwen2.5-Serie hat bereits in Bereichen wie Codierung, mathematischem Schlussfolgern und mehrsprachigen Aufgaben überragende Leistungen gezeigt. Von Qwen3 wird erwartet, dass es in diesen Bereichen weitere Fortschritte macht, insbesondere in ressourcenbeschränkten Umgebungen. Die Einführung der MoE-Architektur hat ebenfalls zu Diskussionen geführt: Im Vergleich zu traditionellen dichten Modellen könnte Qwen3-MoE-15B-A2B einen höheren Wirkungsgrad aufweisen und sich daher für den Einsatz auf Edge-Geräten oder kleineren Servern eignen. Es gibt jedoch auch Stimmen, die argumentieren, dass die Größe von 1,5 Milliarden Parametern relativ klein ist und möglicherweise nicht die Anforderungen komplexer Aufgaben vollständig erfüllt. Dies muss durch Tests bestätigt werden.

Die kontinuierlichen Investitionen von Alibaba Cloud in den KI-Bereich haben das Unternehmen zu einer wichtigen Kraft in der weltweiten Entwicklung von Open-Source-Modellen gemacht. Von Qwen1.5 bis Qwen2.5 ging jede Modelliteration mit technischen und ökologischen Fortschritten einher. Die Einführung von Qwen3 ist nicht nur ein Ausdruck der technologischen Weiterentwicklung von Alibaba Cloud, sondern auch ein wichtiger Schritt, um im globalen KI-Wettbewerb eine Vorreiterrolle einzunehmen. Es ist absehbar, dass Qwen3 mit der Veröffentlichung weiterer Details und der offiziellen Veröffentlichung des Modells eine neue Welle in der Entwickler-Community und in Unternehmensanwendungen auslösen und verschiedene Szenarien, von intelligenten Assistenten bis hin zu automatisierten Prozessen, mit neuer Dynamik versorgen wird.