Kürzlich hat das Unternehmen MiniMax die Einführung seines neuen Modells MiniMax-M1 angekündigt. Dieses Modell ist das weltweit erste Open-Source-Großmodell mit einer gemischten Architektur für Inferenz, das in komplexen Produktivitätsszenarien herausragende Leistungen zeigt und zu den herausragenden Open-Source-Modellen zählt. MiniMax-M1 übertrifft nicht nur nationale geschlossene Modelle, sondern nähert sich auch dem Niveau der weltweit führenden Modelle im Ausland, wobei es gleichzeitig die höchste Preis-Leistungs-Relation im Brancheninneren aufweist.

Eine bemerkenswerte Eigenschaft von MiniMax-M1 ist seine Unterstützung für bis zu 1 Million Kontexteingaben, was dem geschlossenen Modell Google Gemini2.5Pro entspricht und achtmal so viel wie DeepSeek R1 ist, und es kann bis zu 80.000 Tokens als Inferenzergebnis ausgeben. Diese Errungenschaft verdankt sich MiniMax' eigenständig entwickelten hybriden Architektur mit Schwerpunkt auf der Blitz-Attention-Mechanismus, die die Effizienz bei der Verarbeitung langer Kontexteingaben und tiefgreifender Inferenzen signifikant erhöht. Zum Beispiel benötigt MiniMax-M1 bei der tiefen Inferenz mit 80.000 Tokens nur etwa 30 % der Rechenleistung von DeepSeek R1, was ihm im Trainings- und Inferenzprozess einen Rechenleistungs-Overhead-Vorteil bietet.

Zudem hat MiniMax einen schnelleren verstärkten Lernalgorithmus namens CISPO vorgestellt, der durch das Trimmen von Wichtungsstichproben die Effizienz des verstärkten Lernens verbessert. In Experimenten des AIME zeigte der CISPO-Algorithmus eine Konvergenzleistung, die doppelt so schnell war wie andere verstärkte Lernalgorithmen, einschließlich des kürzlich vorgeschlagenen DAPO von Byte, und signifikant besser als den früher von DeepSeek verwendeten GRPO-Algorithmus. Diese technologischen Innovationen machten den verstärkten Trainingsprozess von MiniMax-M1 außerordentlich effizient und erforderten lediglich drei Wochen mit 512 H800-Platinen, wobei die Mietkosten deutlich gesenkt wurden und um eine Größenordnung niedriger waren als erwartet.

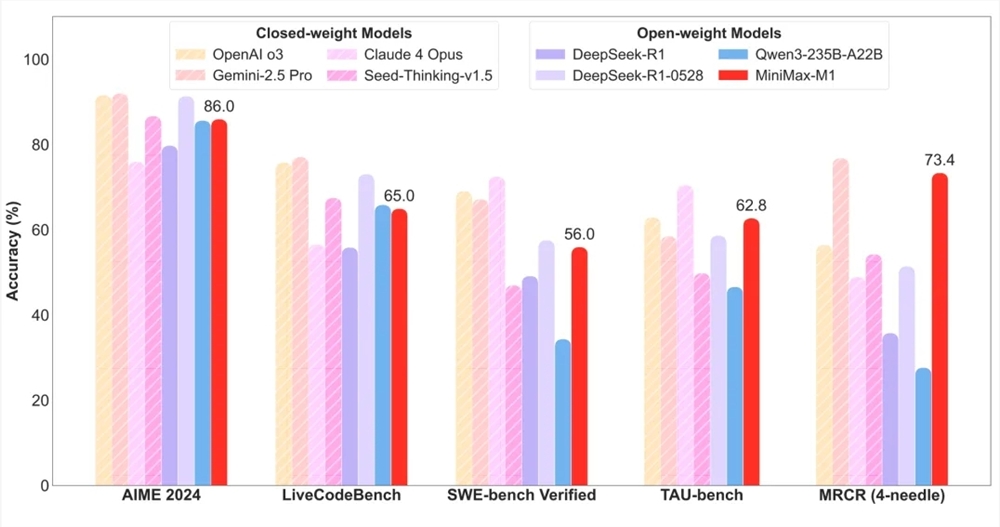

In Bezug auf die Bewertung erzielte MiniMax-M1 hervorragende Ergebnisse in den branchenüblichen 17 Evaluationsdatensätzen. Besonders in komplexen Produktivitätsszenarien wie Software-Engineering, langen Kontexten und Werkzeugnutzung zeigte MiniMax-M1 herausragende Vorteile. Zum Beispiel erreichte MiniMax-M1-40k und MiniMax-M1-80k bei der SWE-bench-Validierungsbenchmarks jeweils 55,6 % und 56,0 %, was zwar etwas unter dem 57,6 % von DeepSeek-R1-0528 liegt, aber deutlich über anderen Open-Source-Gewichtungsmodellen liegt. Gleichzeitig zeigt MiniMax-M1 dank seiner millionenfachen Kontextfenstergröße herausragende Leistungen in langen Kontextverständnisaufgaben und übertrifft alle Open-Source-Gewichtungsmodelle, wobei es in manchen Aspekten sogar OpenAI o3 und Claude4Opus übertreffen konnte und weltweit auf Platz zwei steht.

Bemerkenswert ist auch, dass MiniMax-M1 in Szenarien mit Proxy-Werkzeugen (TAU-bench) alle anderen Open-Source-Gewichtungsmodelle übertreffen und selbst Gemini-2.5Pro besiegt hat. Außerdem übertraf MiniMax-M1-80k in den meisten Benchmarks stets MiniMax-M1-40k, was die Effektivität der Bereitstellung von Rechenressourcen bei der Erweiterung bestätigt.

In Bezug auf den Preis hält MiniMax-M1 die niedrigsten Kosten innerhalb der Branche. Nutzer können das Modell unlimitiert kostenlos über die MiniMax-APP und -Web verwenden und über die offizielle Website mit äußerst konkurrenzfähigen Preisen API-Dienste kaufen. Diese Maßnahme wird zweifellos zur weiteren Popularisierung und Anwendung von MiniMax-M1 im Markt beitragen.