Eine neue Studie von Nataliya Kosmyna und ihrem Team am MIT Media Lab untersucht die kognitive Kosten, die durch den Gebrauch von großen Sprachmodellen (LLMs), wie OpenAI's ChatGPT, bei der Abfassung von Wissenschaftsartikeln entstehen können. Das Forscherteam fand heraus, dass obwohl LLMs menschlichen Nutzern und Unternehmen viele Vorteile bieten, deren breite Anwendung das Gehirn langfristig mit einer „kognitiven Verschuldung“ belasten könnte, was zu einer Schwächung der Lernfähigkeiten führen kann.

Die Studie beteiligte 54 Teilnehmer, die in drei Gruppen unterteilt wurden: eine LLM-Gruppe (nur ChatGPT), eine Suchmaschine-Gruppe (traditionelle Suchmaschinen, ohne LLMs) und eine rein manuelle Gruppe (ohne Tools). Es gab vier Sitzungen, wobei die Teilnehmer der LLM-Gruppe in der vierten Sitzung aufgefordert wurden, keine Tools zu verwenden ("LLM-zu-manuell"), während die rein manuellen Teilnehmer begannen, LLMs zu nutzen ("manuell-zu-LLM"). Das Team nahm Gehirnaktivität über ein EEG auf, um kognitive Anstrengung und Belastung zu messen und die neuronalen Aktivierungsmodelle während der schriftlichen Arbeiten zu analysieren. Zusätzlich wurden NLP-Analysen durchgeführt und nach jeder Sitzung Interviews durchgeführt, wobei auch menschliche Lehrkräfte und AI-Richter die Artikel bewerteten.

Hauptergebnisse: Reduzierte Hirnkonnektivität, Gedächtnis- und Eigentumsprobleme

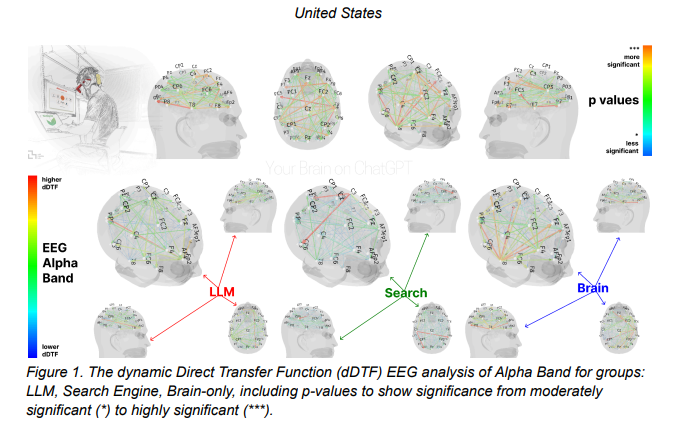

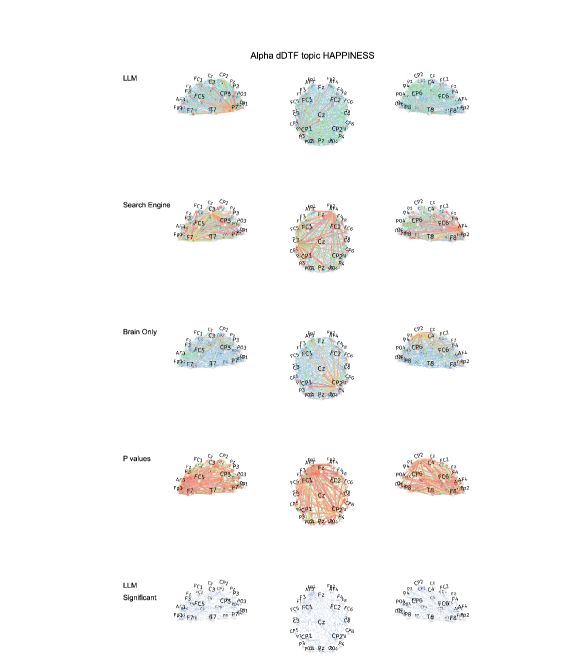

Die Ergebnisse zeigen eindeutig, dass es zwischen den neuronalen Netzwerkmustern der LLM-, Suchmaschine- und rein manuellen Gruppen signifikante Unterschiede gibt, die unterschiedliche kognitive Strategien widerspiegeln. Die Hirnkonnektivität nimmt systematisch ab, je stärker externe Unterstützung vorhanden ist: Die rein manuelle Gruppe zeigte die stärksten und weitest gefächerten Verbindungsnetze, die Suchmaschine-Gruppe lag in der Mitte, während die LLM-Hilfe die schwächste Gesamtverbindung verursachte.

Besonders bemerkenswert war, dass Teilnehmer der "LLM-zu-manuell"-Gruppe im vierten Sitzungsrund ihre neuronale Konnektivität schwächer zeigten und eine unzureichende Beteiligung der Alpha- und Beta-Bänder aufwiesen. Alpha-Bänder sind üblicherweise mit innerer Aufmerksamkeit, semantischer Verarbeitung und kreativer Konstruktion verbunden. Beta-Bänder hingegen stehen mit aktiver kognitiver Verarbeitung, konzentrierter Aufmerksamkeit und sensorimotorischer Integration in Verbindung. Diese Ergebnisse deuten darauf hin, dass Teilnehmer, die sich anfangs stark auf LLMs verlassen haben, nach deren Entzug ihre neuronalen Aktivitäten im Bereich Inhaltsplanung und Erstellung verringern, was mit dem Bericht über „Kognitive Auslagerung“ übereinstimmt, dass die Abhängigkeit von AI-Systemen passives Vorgehen und die Verminderung kritischer Denkfähigkeiten fördern kann.

In Bezug auf das Gedächtnis zeigten Teilnehmer der LLM-Gruppe erhebliche Schwierigkeiten beim Zitieren ihrer gerade verfassten Artikel und konnten dies oft nicht korrekt tun. Dies spiegelt sich direkt in der geringeren Tieffrequenz-Konnektivität wider, insbesondere in den Theta- und Alpha-Bändern, die eng mit der Konsolidierung von situationalem Gedächtnis und semantischem Codierung verbunden sind. Dadurch könnte es bei LLM-Nutzern vorkommen, dass tiefergehende Gedächtnis-Codierungsvorgänge ausgelassen werden und generierte Inhalte passiv integriert werden, ohne in das Gedächtnisnetzwerk eingebettet zu werden.

Zudem zeigten Teilnehmer der LLM-Gruppe in Bezug auf das Eigentumsgefühl für ihre Artikel einen geringeren Grad, während die Suchmaschine-Gruppe stärkere Eigenständigkeit empfand, aber immer noch unter dem rein manuellen Vorbild lag. Diese Verhaltensunterschiede korrelieren mit den Veränderungen der neuronalen Konnektivitätsmuster und unterstreichen mögliche Auswirkungen der LLM-Nutzung auf kognitive Selbstbestimmtheit.

Kumulierung von kognitiver Verschuldung: Effizienz versus Tiefenschule

Die Studie weist darauf hin, dass LLMs im Anfangsstadium erhebliche Effizienzvorteile bieten und kurzfristige kognitive Belastungen reduzieren, jedoch mit der Zeit dieser Vorteil auf Kosten tiefgreifender Lernergebnisse geht. Der Bericht legt den Begriff „kognitive Verschuldung“ nahe: wiederholte Abhängigkeit von externen Systemen (wie LLMs) ersetzte kognitive Prozesse, die für eigenständiges Denken erforderlich sind. Kurzfristig verzögern sie kognitive Investitionen, aber langfristig führen sie zu einer Abnahme der kritischen Nachforschungsfähigkeiten, einer höheren Anfälligkeit für Manipulationen sowie einem Rückgang der Kreativität.

Teilnehmer der rein manuellen Gruppe zeigten trotz höherer kognitiver Belastung bessere Erinnerungskapazitäten, höhere semantische Genauigkeit und stärkeres Eigentumsgefühl gegenüber ihren Werken. Die „rein manuell-zu-LLM“-Gruppe zeigte bei der ersten Nutzung von AI-Unterstützung bei der Neuschreibung ihrer Artikel signifikant erhöhte neuronalen Konnektivität, was auf eine kognitive Integrationsanforderung bei der Zusammenführung von AI-Vorschlägen mit bestehendem Wissen hindeutet. Dies impliziert, dass die Einführung von AI-Tools zu bestimmten Zeitpunkten positive Auswirkungen auf die neuronale Integration haben könnte.

Tiefe Auswirkungen auf Bildungsumgebungen und zukünftige Perspektiven

Das Forscherteam sieht diese Erkenntnisse als tiefgreifend für den Bildungsbereich an. Überschüssige Abhängigkeit von AI-Werkzeugen könnte unbeabsichtigt tiefergehende kognitive Prozesse, Wissenstransfer und echte Einbindung in schriftliche Arbeiten blockieren. Nutzer könnten oberflächliche Flüssigkeit erreichen, ohne Wissen zu internalisieren oder ein Eigentumsgefühl zu entwickeln.

Die Studie empfiehlt Bildungsinterventionen, die die Kombination von AI-Toolunterstützung mit „toolfreiem“ Lernen optimieren, um effizienten Skilltransfer und langfristige neuronale Entwicklung zu erreichen. In den frühen Lernphasen ist eine umfassende neuronale Beteiligung entscheidend für die Entwicklung robuster Schreibnetzwerke; in späteren Übungsphasen kann selektive AI-Unterstützung unnötige kognitive Lasten reduzieren, ohne die etablierten Netzwerke zu beschädigen.

Forschungsleiter betonen, dass mit der zunehmenden Präsenz von AI-Generatoren in Datensätzen und der verschwommener werdenden Grenzen zwischen menschlichem Denken und generativem AI, künftige Studien Priorität bei der Sammlung schreibender Stichproben ohne LLM-Hilfe geben sollten, um „Fingerabdrücke“ zur Identifikation individueller Stile zu entwickeln.

Letztlich ruft die Studie dazu auf, bei der Integration von LLMs in Bildungsszenarien und Informationskontexten vorsichtig mit Blick auf potenzielle Auswirkungen auf kognitive Entwicklung, kritisches Denken und intellektuelle Unabhängigkeit vorzugehen. Obwohl LLMs Frictions beim Beantworten von Fragen reduzieren, ist diese Effizienz mit einem kognitiven Preis verbunden, der die Bereitschaft der Benutzer beeinträchtigt, kritisch auf die von LLMs generierten Inhalte einzugehen. Dies deutet darauf hin, dass sich „Echo-Raum-Effekte“ weiterentwickeln, indem Algorithmen die Art und Weise beeinflussen, wie Benutzer Informationen erhalten.

(Der Titel der Forschungsarbeit lautet „Your Brain on ChatGPT: Accumulation of Cognitive Debt when Using an AI Assistant for Essay Writing Task“, Hauptautorin: Nataliya Kosmyna vom MIT Media Lab.)