Hunyuan-A13B ist ein kürzlich von Tencent neu geöffnetes großes Sprachmodell. Mit einem innovativen Entwurfsansatz erreicht es eine starke Leistungsfähigkeit bei relativ kleiner aktiver Parametergröße und ist besonders für Umgebungen mit begrenzten Ressourcen geeignet.

Dieses Modell verwendet eine feinkörnige MoE-(Mixture-of-Experts)-Architektur, verfügt über 13 Milliarden aktive Parameter, hat jedoch insgesamt bis zu 800 Milliarden Parameter. Diese Architektur ermöglicht es dem Modell, gleichzeitig effizient und skalierbar zu sein und führende Schlussfolgerungsfähigkeiten sowie allgemeine Anwendungsunterstützung zu bieten.

Die Kernfunktionen von Hunyuan-A13B umfassen:

Hybride Schlussfolgerungsmodus mit schnellem und langsamem Denken: Dieses einzigartige Schlussfolgerungsmechanismus ermöglicht es dem Modell, den Denkprozess je nach Aufgabenanforderung flexibel anzupassen und die Effizienz beim Lösen komplexer Probleme zu verbessern.

Originale Fähigkeit zur Verarbeitung sehr langer Kontexte (256K): Dies bedeutet, dass das Modell extrem lange Texteingaben verarbeiten kann und sich in Aufgaben, die viel Hintergrundinformation erfordern, hervorragend zeigt.

Exzellente Leistung bei Agentenaufgaben: Hunyuan-A13B zeigt starke Fähigkeiten bei der Ausführung verschiedener Agenten-(Agent)-bezogener Aufgaben.

Um eine effiziente Schlussfolgerung zu ermöglichen, verwendet Hunyuan-A13B die Grouped Query Attention (GQA)-Technologie und unterstützt verschiedene Quantisierungsformate. Derzeit sind die Modelle für vortrainiert, Befehlsfinetuning, FP8 und INT4-Quantisierung öffentlich zugänglich, was Entwicklern hilft.

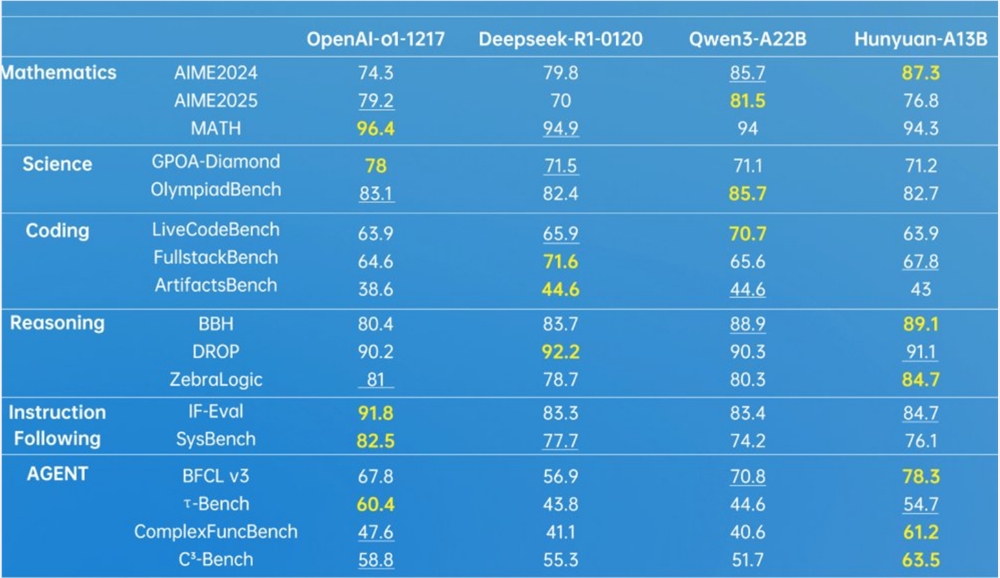

In verschiedenen Benchmark-Tests hat Hunyuan-A13B eine starke Wettbewerbsfähigkeit gezeigt, insbesondere in den Bereichen Mathematik, Wissenschaft, Codierung, Schlussfolgerung und Agenten.

Tencent bietet Entwicklern umfassende Unterstützung, einschließlich detaillierter Anleitungen zur Interaktion und Modelltrainierung mit Hugging Face Transformers. Darüber hinaus unterstützt Hunyuan-A13B bei der Modellbereitstellung auch TensorRT-LLM, vLLM und SGLang und stellt vorab gebaute Docker-Images und Quantisierungsmodell-Bereitstellungspläne bereit, was den Bereitstellungsprozess stark vereinfacht.

Die Öffnung von Hunyuan-A13B eröffnet zweifellos neue Möglichkeiten für die Anwendung großer Modelle in Umgebungen mit begrenzten Ressourcen und bringt auch neuen Innovationsdruck für die AI-Gemeinschaft.

Öffnungsadresse: https://huggingface.co/tencent/Hunyuan-A13B-Instruct

github: https://github.com/Tencent-Hunyuan/Hunyuan-A13B?tab=readme-ov-file