In der KI-Branche gibt es erneut eine große Nachricht. Heute Morgen kündigten das bekannte Großmodell-Training-Plattform Together.ai und Agentica gemeinsam den Open-Source-AI-Agent-Framework DeepSWE an. Dieses innovative System basiert auf dem neuesten offenen Qwen3-32B-Modell von Alibaba und wurde vollständig durch Verstärkendes Lernen trainiert.

Die Open-Source-Informationen zu DeepSWE sind auf Hugging Face verfügbar. Neben den Modellgewichten werden auch alle weiteren Inhalte wie Trainingsmethoden, Protokolle und Datensätze öffentlich gemacht, um Entwicklern zu helfen, dieses Agentensystem tiefer zu verstehen und zu verbessern.

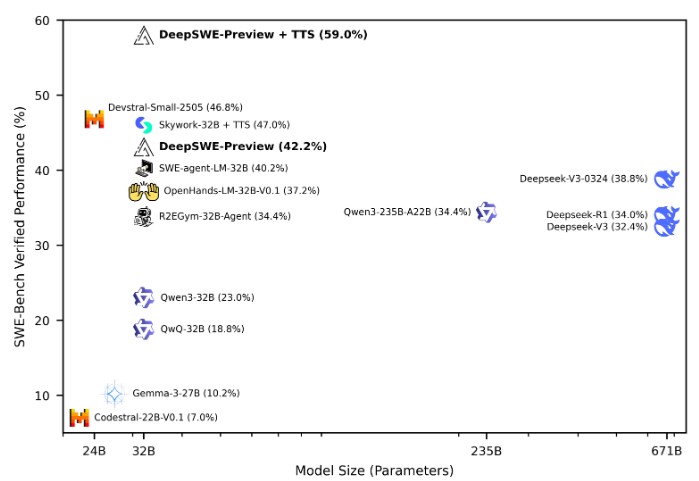

Laut den Ergebnissen des SWE-Bench-Verified-Tests wurde DeepSWE mit einer maximalen Kontextlänge von 64k und maximal 100 Umwelt-Schritten bewertet. Bei 16 Durchläufen erreichte die Pass@1-Genauigkeit 42,2 %. Nach gemischtem Test verbesserte sich die Leistung sogar auf 59 %, wodurch DeepSWE den ersten Platz unter allen Open-Source-Agenten einnimmt.

Die Ausbildung von DeepSWE erfolgte mit dem rLLM-Framework, einem System, das speziell für die spätere Ausbildung von Sprachagenten entwickelt wurde. Es wurde über sechs Tage lang auf 64 H100-GPUs trainiert, wobei 4500 echte Software-Ingenieur-Aufgaben aus dem R2E-Gym-Trainingsumfeld verwendet wurden. Diese Aufgaben umfassten das Lösen von GitHub-Problemen, das Implementieren neuer Code-Funktionen und das Debuggen, was die Vielfalt der realen Softwareentwicklung zeigt.

Während des Trainings lernte DeepSWE, im weiten Code-Repository zu navigieren, gezielt Code zu bearbeiten, Shell-Befehle zum Ausführen von Build- und Testprozessen auszuführen und Lösungen zu optimieren, während es mit tatsächlichen Pull-Requests umging. Beim Datenmanagement wurden 4500 Probleme aus dem Unterabschnitt von R2E-Gym verwendet, um die Reinheit und Relevanz der Trainingsdaten sicherzustellen.

Das Trainingsumfeld wurde um R2E-Gym herum aufgebaut und unterstützt ein skalierbares, hochwertiges ausführbares Software-Ingenieur-Umfeld. Die Belohnungsmechanik nutzt ein selteneres Ergebnis-Belohnungsmodell, bei dem nur dann positive Belohnung vergeben wird, wenn der generierte Patch alle Tests besteht, was effizienteres Lernen fördert.

Die Ausbildung von DeepSWE verwendete auch eine verbesserte GRPO++-Algorithmusversion, die durch Integration mehrerer Innovationen einen stabileren und effizienteren Trainingsprozess ermöglichte. Darüber hinaus stellten die Forscher fest, dass die Erhöhung der Anzahl der Ausgabetoken bei Software-Ingenieuraufgaben kaum Auswirkungen hatte, während die Erweiterung der Rollenzahl die Modellleistung deutlich verbesserte.

Diese Reihe von Bemühungen machte DeepSWE zu einem äußerst vielversprechenden AI-Agentensystem und förderte den Fortschritt des Verstärkenden Lernens in praktischen Anwendungen.

Open-Source-Adresse: https://huggingface.co/agentica-org/DeepSWE-Preview

Schlusspunkte:

🌟 DeepSWE basiert auf dem Qwen3-32B-Modell und wurde vollständig durch Verstärkendes Lernen trainiert. Die Open-Source-Informationen wurden vollständig veröffentlicht.

🏆 Bei dem SWE-Bench-Verified-Test zeigte DeepSWE herausragende Leistungen, wobei die Pass@1-Genauigkeit 59 % erreichte und es somit zur führenden Open-Source-Agenten-Plattform wurde.

💡 Durch die Nutzung des rLLM-Frameworks und des verbesserten GRPO++-Algorithmus zeigte DeepSWE seine starke Lernfähigkeit und Anwendungspotenzial bei realen Software-Ingenieuraufgaben.