Im Juli 2025 gab Bilibili (B站) bekannt, dass sein Open-Source-Anime-Video-Generationsmodell AniSora eine wichtige Aktualisierung erfahren hat und offiziell die Version AniSora V3 veröffentlicht wurde. Als Teil des Index-AniSora-Projekts optimiert die V3-Version die Generierungsqualität, die Bewegungsflüssigkeit und die Stilvielfalt weiterhin auf der Grundlage der bestehenden Technologie und bietet Kreatoren von Anime, Manga und VTuber-Inhalten leistungsstärkere Werkzeuge. AIbase analysiert tiefgehend die technischen Fortschritte, Anwendungsbereiche und branchenweiten Einfluss von AniSora V3.

Technische Verbesserungen: Höhere Qualität und präzise Kontrolle

AniSora V3 basiert auf den zuvor von Bilibili geöffneten Modellen CogVideoX-5B und Wan2.1-14B und kombiniert das Verstärkende Lernen mit menschlicher Rückmeldung (RLHF), um die visuelle Qualität und die Bewegungskohärenz der generierten Videos erheblich zu verbessern. Es unterstützt die einheitliche Erzeugung verschiedener Stilarten von Anime-Videoclips, wie z.B. Episoden aus Serien, chinesische Originalanimationen, Videoverfilmungen von Mangas und VTuber-Inhalte.

Kernverbesserungen beinhalten:

- Optimierte räumlich-zeitliche Maskenmodule (Spatiotemporal Mask Module): Die V3-Version verbessert ihre Fähigkeit zur räumlich-zeitlichen Steuerung und unterstützt komplexere Animationstätigkeiten wie detaillierte Gesichtsausdrucksteuerung, dynamische Kamerabewegungen und lokale Bildleitungen. Zum Beispiel kann ein Prompt wie „Fünf Mädchen tanzen, während die Kamera vergrößert wird, heben sie ihre linken Hände bis zum Kopf und lassen sie dann bis zu ihren Knien herunter“ zu einem flüssigen Tanzvideo führen, bei dem die Kamera und die Bewegung der Figuren synchron und natürlich sind.

- Erweiterung des Datensatzes: Die V3 nutzt weiterhin über 10 Millionen hochwertige Anime-Videosegmente (aus 1 Million ursprünglichen Videos extrahiert) für das Training und fügt eine neue Datenreinigungs- und -verarbeitungs-Straße hinzu, um die Stilkonstanz und die Detailreichtum der generierten Inhalte sicherzustellen.

- Hardware-Optimierung: Die V3 unterstützt nun native Huawei Ascend910B NPU, was bedeutet, dass sie vollständig auf inländischen Chips trainiert wird. Die Verarbeitungsgeschwindigkeit erhöht sich um etwa 20 %, und die Erstellung eines 4-Sekunden-HD-Videos dauert nur 2–3 Minuten.

- Mehraufgaben-Lernen: Die V3 stärkt ihre Fähigkeit zur Mehraufgabenbearbeitung und unterstützt Funktionen wie die Erzeugung von Videos aus einem einzelnen Bild, Schlüsselbildinterpolation und Lippenbewegungssynchronisation, besonders geeignet für Mangaverfilmbearbeitung und VTuber-Inhalte.

In den neuesten Benchmark-Tests erreichte AniSora V3 in VBench und doppelten subjektiven Tests sowohl die Rollenkonsistenz als auch die Bewegungsflüssigkeit auf einem führenden Niveau der Branche (SOTA). Besonders hervorragend ist es bei komplexen Bewegungen (wie überschwänglichen animierten Bewegungen, die gegen physikalische Regeln verstoßen).

Open-Source-Ökosystem: Gemeinschaftsgetrieben und transparente Entwicklung

Die vollständigen Trainings- und Inferenzcodes von AniSora V3 wurden am 2. Juli 2025 auf GitHub aktualisiert. Entwickler können über Hugging Face auf die Modellgewichte und ein Bewertungsdatensatz mit 948 Animationen zugreifen. Bilibili betont, dass AniSora ein „offenes Geschenk an die Anime-Welt“ sei und fordert die Zusammenarbeit der Community zur Optimierung des Modells auf. Benutzer müssen eine Antragformular ausfüllen und an eine bestimmte E-Mail-Adresse senden (z.B. yangsiqian@bilibili.com), um Zugriff auf die Gewichte der Version 2.0 und das vollständige Datensatzes zu erhalten.

V3 hat außerdem einen ersten RLHF-Framework für die Erzeugung von Anime-Videoclips eingeführt, mit Tools wie AnimeReward und GAPO, um das Modell anzupassen, sodass die Ausgabe besser den menschlichen Ästhetik- und Anime-Stilanforderungen entspricht. Community-Entwickler haben bereits begonnen, maßgeschneiderte Plug-ins auf Basis von V3 zu entwickeln, z.B. um die Generierungseffekte bestimmter Anime-Stile (wie der Studio Ghibli-Stil) zu verstärken.

Anwendungsfälle: Von Kreativität bis zur Kommerzialisierung

AniSora V3 unterstützt verschiedene Anime-Stilarten, einschließlich japanischer Anime, chinesischer Originalanimationen, Mangaverfilmbearbeitung, VTuber-Inhalte und Parodien („Guichu“-Videos), und deckt 90 % der Anwendungsbereiche von Anime-Videoclip ab. Konkrete Anwendungen beinhalten:

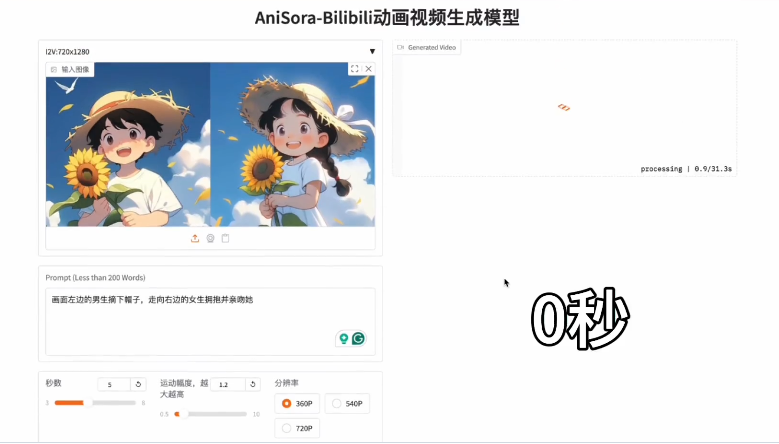

- Bild zu Video: Der Nutzer lädt ein hochwertiges Anime-Bild hoch und ergänzt Texthinweise (z.B. „Das Charakter winkt im vorwärts fahrenden Auto, seine Haare bewegen sich mit dem Wind“), um ein dynamisches Video zu erzeugen, wobei die Charakterdetails und der Stil konsistent bleiben.

- Mangaverfilmung: Erzeugung von Animationen mit Lippenbewegungssynchronisation und Bewegungen aus Manga-Frames, ideal für schnelle Erstellung von Trailern oder Kurzfilmen.

- VTuber und Spiele: Unterstützung der Echtzeitgenerierung von Charakteranimationen, um unabhängige Kreative und Spielentwickler dabei zu unterstützen, schnell Charakterbewegungen zu testen.

- Hochauflösende Ausgabe: Die generierten Videos unterstützen bis zu 1080p, um professionelle Darstellung auf sozialen Medien und Streaming-Plattformen sicherzustellen.

Laut Testergebnissen von AIbase reduziert V3 bei der Generierung komplexer Szenarien (z.B. mehrere Interaktionen zwischen Charakteren, dynamische Hintergründe) etwa 15 % der Artefakte im Vergleich zu V2 und verkürzt die Generierungszeit auf durchschnittlich 2,5 Minuten (für 4 Sekunden Video).

Die Veröffentlichung von AniSora V3 senkt den Barrierepegel der Anime-Erstellung weiter, sodass unabhängige Kreative und kleine Teams kostengünstig hochwertige Animationen produzieren können. Im Vergleich zu allgemeinen Video-Generationsmodellen wie Sora von OpenAI oder Kling ist AniSora V3 spezialisiert auf den Anime-Bereich und füllt eine Marktlücke. Im Vergleich zu EX-4D von ByteDance konzentriert sich AniSora V3 stärker auf 2D-/2,5D-Anime-Stile statt auf 4D-Mehrsichtgenerierung und zeigt damit eine unterschiedliche technische Richtung.

Projekt: https://t.co/I3HPKPvsBV