In der Domäne des tiefen Lernens haben rekurrente neuronale Netzwerke (RNN) und Transformer-Modelle jeweils ihre Vorzüge. Kürzliche Forschungen haben gezeigt, dass lineare rekurrente Modelle (wie Mamba) aufgrund ihrer überlegenen Fähigkeit zur Verarbeitung von Sequenzen zunehmend die Position des Transformers herausfordern. Insbesondere bei der Bearbeitung von extrem langen Sequenzen zeigen diese rekurrenten Modelle ein großes Potenzial und übertreffen deutlich die Grenzen traditioneller Transformer-Modelle.

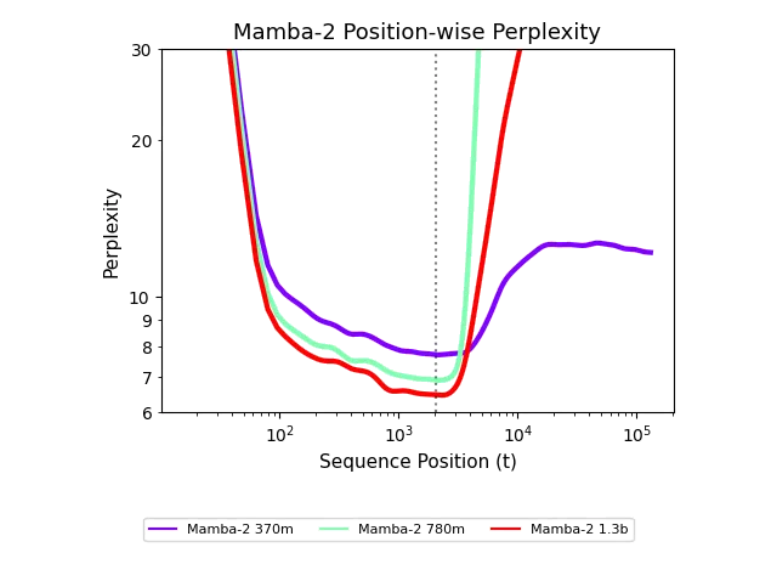

Transformer-Modelle sind bei der Bearbeitung langer Kontexte oft durch einen festen Kontextfenster begrenzt, und ihre Berechnungskomplexität steigt rasch mit der Länge der Sequenz, was zu einer Leistungsminderung führt. Lineare rekurrente Modelle können dagegen längerer Sequenzen flexibler verarbeiten, was eine ihrer Stärken ist. Allerdings zeigten frühere rekurrente Modelle in Bezug auf kurze Sequenzen oft nicht so gute Ergebnisse wie Transformer, was ihre Anwendung in der Praxis einschränkte.

Kürzlich haben Forscher von der Carnegie Mellon University und Cartesia AI eine innovative Methode vorgestellt, um die Generalisierungsfähigkeit rekurrenter Modelle bei langen Sequenzen zu verbessern. Sie stellten fest, dass bereits eine einfache Trainingsintervention von 500 Schritten ausreicht, damit rekurrente Modelle Sequenzen von bis zu 256.000 Zeichen verarbeiten können, was eine erstaunliche Generalisierungsfähigkeit zeigt. Diese Studie zeigt, dass rekurrente Modelle keine grundlegenden Defizite haben, sondern vielmehr ihr Potenzial noch nicht vollständig ausgeschöpft wurde.

Das Forschungsteam stellte ein neues Erklärungsrahmenwerk vor, das als „Hypothese der unerforschten Zustände“ bezeichnet wird. Diese Hypothese besagt, dass rekurrente Modelle während des Trainings nur auf eine begrenzte Zustandsverteilung zugreifen, was zu schlechten Ergebnissen bei längeren Sequenzen führt. Um eine Längengeneralisierung zu erreichen, schlagen die Forscher eine Reihe von Trainingsinterventionen vor, darunter die Nutzung von zufälligen Rauschen, die Anpassung an Rauschen und den Zustandstransfer. Diese Maßnahmen ermöglichen es dem Modell, effektiv zu generalisieren, während es auf langen Sequenzen trainiert wird, wodurch sich die Leistung deutlich verbessert.

Unter anderem sind diese Interventionen nicht nur in der Lage, die Leistung des Modells zu verbessern, sondern auch die Stabilität des Zustands zu erhalten, sodass rekurrente Modelle bei Aufgaben mit langem Kontext gut abschneiden. Die Forscher haben durch eine Reihe von Experimenten bewiesen, dass diese Methoden in der Praxis effektiv sind und neue Wege für die Entwicklung rekurrenter Modelle eröffnen.