Microsoft hat heute Morgen die neueste Version der Phi-4-Familie – Phi-4-mini-flash-reasoning – auf seiner Website als Open Source veröffentlicht. Diese neue Version baut auf den Vorteilen der Phi-4-Serie auf, bei der die Parameter klein und die Leistung stark sind, und ist speziell für Szenarien mit eingeschränkter Rechenleistung, Speicher und Latenz konzipiert. Sie kann auf einem einzelnen GPU laufen und ist daher ideal für Edge-Geräte wie Laptops und Tablets.

Die Einführung von Phi-4-mini-flash-reasoning markiert eine erhebliche Verbesserung der Inferenzeffizienz. Im Vergleich zur vorherigen Version stieg die Inferenzgeschwindigkeit um das Zehnfache, und die durchschnittliche Latenz verringerte sich um das Zweifache bis Dreifache. Diese deutliche Leistungssteigerung macht sich besonders bei anspruchsvollen mathematischen Schlussfolgerungen bemerkbar und ist daher ideal für Anwendungen im Bildungs- und Forschungsbereich.

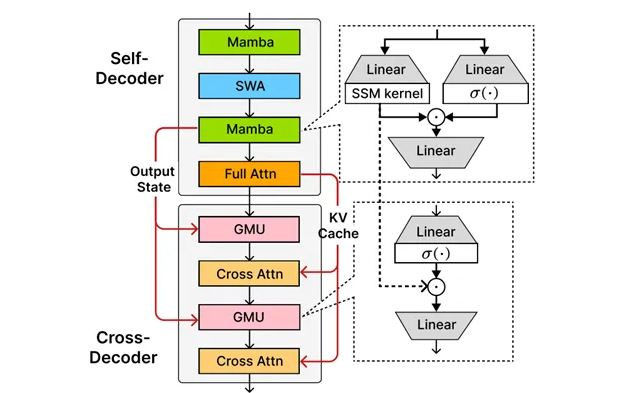

Der Kern dieser Version ist die selbstentwickelte SambaY-Architektur von Microsoft. SambaY ist ein innovativer Decoder-Mischarchitektur, der gemeinsam mit der Stanford University entwickelt wurde. Durch die Einführung von Gate-Speichereinheiten ermöglicht SambaY eine effiziente Gedächtnisfreigabe über Schichten hinweg, wodurch die Dekodierleistung gesteigert wird, während gleichzeitig die lineare Vorbelegungszeitkomplexität beibehalten wird. Dies verbessert die Leistung bei langen Kontexten und benötigt keine expliziten Positionscode.

Bei der Erstellung langer Texte zeigte SambaY eine signifikante Effizienzsteigerung. Bei der Verarbeitung von Prompt-Texten mit 2K-Länge und Generierungsaufgaben mit 32K-Länge erhöhte sich die Dekodierdurchsatzrate um das Zehnfache gegenüber dem traditionellen Phi-4-mini-Reasoning-Modell. Darüber hinaus zeigte SambaY in Tests zu mathematischen Schlussfolgerungen eine deutliche Verbesserung, insbesondere bei komplexen mathematischen Problemen, wo es klare und logisch zusammenhängende Lösungsschritte generieren kann.

Microsoft hat auch die Leistung von SambaY bei der langen Kontextrecherche anhand von Benchmark-Tests wie Phonebook und RULER bewertet. In einem Kontext mit 32K-Länge erreichte SambaY bei der Phonebook-Aufgabe eine Genauigkeit von 78,13 %, was weit über anderen Modellen liegt. Dies beweist die Stärken von SambaY bei der Verständnis- und Erzeugungsfähigkeit bei langen Kontexten.

Um die Skalierbarkeit von SambaY zu validieren, führte Microsoft umfangreiche Vortrainingsversuche durch, indem ein Phi-4-mini-Flash-Modell mit 3,8B Parametern verwendet und auf einem Datensatz von 5T Tokens trainiert wurde. Obwohl einige Herausforderungen während des Trainings auftauchten, gelang es durch die Einführung von Label-Smoothing und Attention Dropout, das Modell letztendlich zu konvergieren und in aufgabenintensiven Wissensbereichen eine deutliche Leistungssteigerung zu erzielen.

Open Source-Adresse: https://huggingface.co/microsoft/Phi-4-mini-flash-reasoning

NVIDIA-API: https://build.nvidia.com/microsoft

Zusammenfassung:

🌟 Microsoft hat Phi-4-mini-flash-reasoning vorgestellt, wobei die Inferenzgeschwindigkeit um das Zehnfache gestiegen ist und es für Laptops geeignet ist.

🔍 Die innovative SambaY-Architektur steigert die Dekodierleistung durch effiziente Gedächtnisfreigabe und ist ideal für die Erstellung langer Texte und mathematische Schlussfolgerungen.

📈 In Benchmark-Tests zeigte SambaY eine hervorragende Leistung, wobei die Genauigkeit bei der Phonebook-Aufgabe 78,13 % betrug und somit die Fähigkeit zur Verständnis und Erzeugung bei langen Kontexten unter Beweis stellte.