En août 2024, iFLYTEK a officiellement lancé la technologie d'interaction ultra-réaliste "Xinghuo Fast", qui réalise trois avancées majeures : vitesse de réponse, résonance émotionnelle et expression vocale contrôlable, grâce au modélage vocal en bout à bout et à l'entraînement décomposé en plusieurs dimensions émotionnelles. Cette technologie peut identifier avec précision les fluctuations émotionnelles dans le discours des utilisateurs, répondre en temps réel avec un ton adapté, et permettre l'ajustement dynamique de la vitesse de parole, du timbre vocal et du personnage de l'IA. Cela marque une évolution majeure de l'interaction vocale, passant de « l'accomplissement fonctionnel » à « la connexion émotionnelle ».

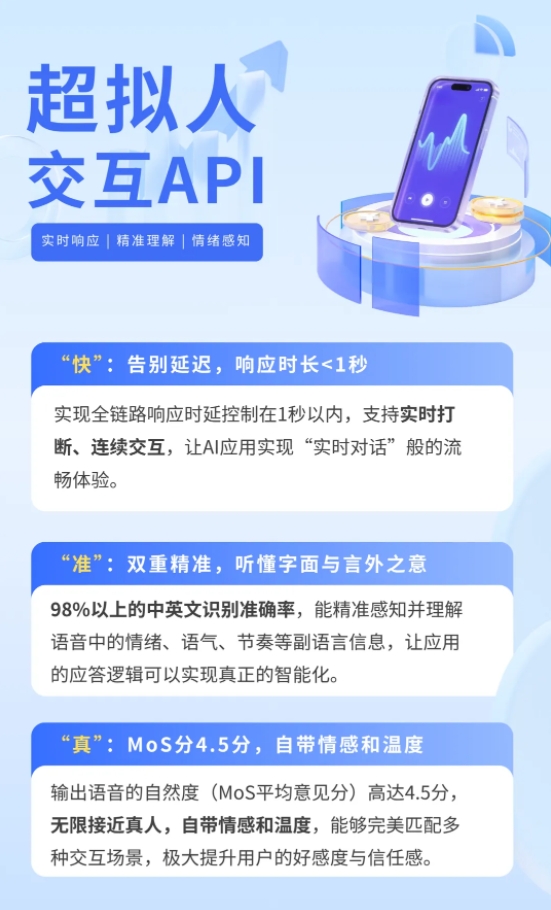

Actuellement, l'API d'interaction ultra-réaliste est désormais disponible sur la plateforme ouverte iFLYTEK, permettant aux développeurs d'utiliser les capacités techniques à moindre coût. Dans le domaine des jeux, les PNJ peuvent adapter stratégiquement leurs dialogues selon l'humeur du joueur ; dans les scénarios éducatifs, l'entraînement oral par IA peut simuler les réactions d'un professeur étranger ; dans le secteur du tourisme et des loisirs, sont apparus des « guides numériques », interagissant profondément avec les touristes via le rôle de personnages. Un test dans un parc montre que le guide IA équipé de cette technologie a augmenté de 40 % le temps passé par les visiteurs, et de 25 % le taux de consommation secondaire.

Les systèmes traditionnels d'interaction vocale, qui reposent sur une architecture en cascade « reconnaissance vocale - traitement par modèle de grande taille - synthèse vocale », entraînent généralement une durée moyenne de réponse supérieure à 3 secondes, et la transmission émotionnelle dépend du contenu textuel, ce qui rend difficile la capture des informations non verbales telles que le ton ou le rythme. La technologie d'interaction ultra-réaliste Xinghuo Fast utilise un cadre neuronal unifié pour réaliser un modélage vocal direct : après extraction des caractéristiques par un encodeur audio, le signal vocal est aligné avec la représentation sémantique du texte, puis prédit par un grand modèle multimodal, avant d'être transformé en parole synthétique naturelle et précise grâce à un décodeur audio. Cette innovation réduit le délai d'interaction à moins de 0,5 seconde, et améliore le mode de réponse de « vous me posez une question, je vous réponds » à « conversation en temps réel ».

Pour réaliser une véritable résonance émotionnelle, l'équipe technique a construit un système de représentation décomposée des propriétés vocales multidimensionnelles, séparant les éléments tels que le contenu, l'émotion, la langue, le timbre et le rythme. Grâce au apprentissage contrastif et à la prédiction de masque, le système peut identifier précisément les émotions telles que la joie, la colère ou l'anxiété dans la parole, et ajuster automatiquement la stratégie de réponse. Par exemple, lorsqu'un utilisateur demande rapidement un itinéraire avec impatience, l'IA adopte un ton calme pour planifier le trajet rapidement ; lorsqu'un utilisateur partage une histoire amusante, l'IA prolonge le sujet avec un ton léger. De plus, les développeurs peuvent personnaliser le personnage de l'IA via l'API, lui conférant des valeurs spécifiques, un style de langage, voire même un timbre vocal de célébrité pour interagir.