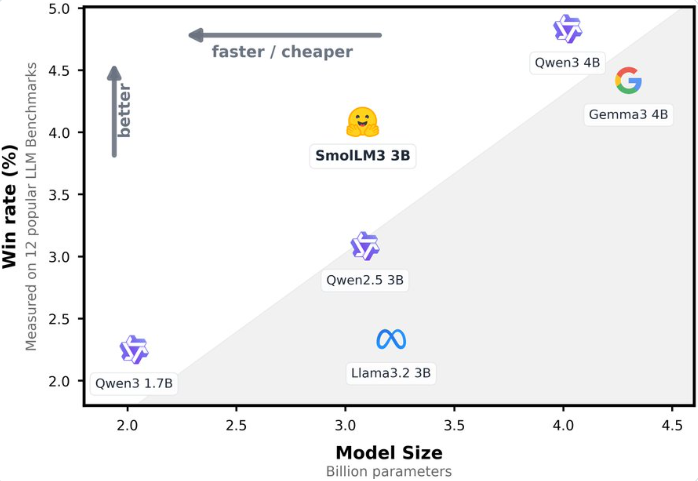

Récemment, Hugging Face a officiellement lancé un tout nouveau modèle linguistique open source : SmolLM3, un modèle de langage à grande échelle (LLM) léger avec 3 milliards de paramètres, qui attire l'attention de l'industrie grâce à ses performances exceptionnelles et à sa conception efficace. SmolLM3 dépasse non seulement des modèles du même niveau comme Llama-3.2-3B et Qwen2.5-3B dans plusieurs tests de référence, mais il est même comparable aux modèles à 4 milliards de paramètres tels que Gemma3.

Adresse : https://huggingface.co/blog/smollm3

3 milliards de paramètres, performance proche de celle d'un modèle à 4 milliards de paramètres

SmolLM3 est un modèle Transformer dédié aux décodages avec 3 milliards de paramètres, optimisé par la technologie de requête en groupe (GQA) et NoPE, offrant à la fois une efficacité de raisonnement et une capacité à traiter des contextes longs. Le modèle a été entraîné sur un ensemble de données diversifié de 11,2 billions de tokens, comprenant des pages web, du code, des mathématiques et des données de raisonnement, garantissant ainsi une forte performance dans les domaines de la connaissance, du raisonnement, des mathématiques et du codage. Selon les informations officielles, SmolLM3 se classe parmi les meilleurs dans des tests de référence tels que HellaSwag, ARC et BoolQ, rivalisant même avec des modèles à 4 milliards de paramètres comme Qwen3-4B et Gemma3-4B, montrant le grand potentiel des petits modèles.

Raisonnement en deux modes, adapté à diverses tâches

SmolLM3 intègre une fonctionnalité unique de raisonnement en deux modes, supportant les modes « réfléchir » (think) et « sans réflexion » (no-think). Lorsque le mode de réflexion est activé, le modèle montre une amélioration significative dans des tâches complexes comme AIME2025 (36,7 % vs 9,3 %), LiveCodeBench (30,0 % vs 15,2 %) et GPQA Diamond (41,7 % vs 35,7 %). Cette flexibilité permet au modèle de s'adapter dynamiquement selon les besoins des tâches, combinant vitesse et profondeur de raisonnement, répondant ainsi à divers scénarios allant des questions rapides aux résolutions de problèmes complexes.

Contexte de 128K, passage fluide entre six langues

SmolLM3 se distingue par ses capacités de traitement des contextes longs, soutenant un contexte de 64K pendant l'entraînement, et pouvant être étendu jusqu'à 128K tokens grâce à la technologie YaRN, démontrant ainsi une forte capacité de traitement des séquences longues dans les tests Ruler64k. De plus, le modèle prend nativement en charge six langues (anglais, français, espagnol, allemand, italien, portugais), et a reçu un entraînement limité en arabe, chinois et russe, présentant ainsi une excellente performance dans les tâches multilingues. Dans les tests Global MMLU et Flores-200, les compétences multilingues de SmolLM3 se classent parmi les meilleurs modèles de son niveau, offrant un soutien fiable pour les applications mondiales.

Complètement open source, soutien à l'écosystème des développeurs

Hugging Face prône constamment l'esprit open source. SmolLM3 ne rend pas seulement les poids du modèle disponibles, mais ouvre également complètement les données d'entraînement, les configurations d'entraînement et le code, permettant aux développeurs d'accéder aux informations détaillées via le référentiel smollm de Hugging Face. Ce « plan d'entraînement » transparent réduit considérablement les barrières pour la recherche académique et les applications commerciales, permettant aux développeurs de reproduire ou d'optimiser le modèle sur la base des jeux de données et des cadres publics. AIbase estime que cette initiative renforcera davantage la vitalité de l'écosystème open source d'IA, offrant davantage de possibilités pour le déploiement sur appareils de bord et les applications personnalisées.

Conception efficace, nouvelle option pour les appareils de bord

SmolLM3 est conçu pour un raisonnement efficace, utilisant mécanisme de requête en groupe (GQA) pour réduire significativement l'utilisation de cache KV lors du raisonnement, combiné au support WebGPU, ce qui le rend particulièrement adapté à l'exécution dans les navigateurs ou les appareils de bord. Comparé aux modèles de plus grande taille, SmolLM3 trouve un point d'équilibre « optimal de Pareto » entre performance et coût de calcul, offrant ainsi une solution rentable pour des scénarios tels que l'éducation, le codage et le support client.

Impact industriel et perspective future

Le lancement de SmolLM3 marque un grand progrès dans les performances et l'efficacité des modèles linguistiques à petite échelle. Sa nature open source, sa prise en charge des contextes longs et sa capacité multilingue en font un choix idéal pour les recherches académiques, les startups et les petites et moyennes entreprises. AIbase prévoit que SmolLM3 connaîtra une forte adoption dans les domaines de l'éducation, du service client et du déploiement local, tout en incitant davantage de développeurs à participer à l'optimisation et à l'innovation des modèles d'IA grâce à son processus d'entraînement entièrement open source.

SmolLM3, avec 3 milliards de paramètres, atteint des performances comparables à celles d'un modèle à 4 milliards de paramètres, illustrant ainsi le potentiel illimité des petits modèles dans le domaine de l'IA efficace. Hugging Face, en rendant publics les détails et les données d'entraînement, établit un exemple de transparence et de collaboration pour l'industrie. Nous attendons impatiemment les performances de SmolLM3 dans davantage de scénarios pratiques et continuerons à suivre ses mises à jour futures.

Conclusion