Sakana AI एक ऐसा आर्टिफिशियल इंटेलिजेंस अनुसंधान प्रयोगशाला है जो प्राकृतिक प्रेरित एल्गोरिदम पर केंद्रित है। हाल ही में, इसने एक नवोन्मेषी अनुकूलनशील भाषा मॉडल का नाम Transformer² (Transformer-squared) पेश किया है। यह मॉडल महंगे फाइन-ट्यूनिंग की आवश्यकता के बिना, निष्पादन के दौरान नए कार्यों के लिए गतिशील रूप से सीखने और अनुकूलन करने में सक्षम है, जो बड़े भाषा मॉडल (LLM) प्रौद्योगिकी के विकास में एक महत्वपूर्ण कदम का प्रतीक है।

Transformer² की मुख्य नवाचार इसकी अनूठी दो-चरणीय गतिशील वजन समायोजन तंत्र में निहित है। पहले, यह आने वाले उपयोगकर्ता अनुरोध का विश्लेषण करता है, कार्य की आवश्यकताओं को समझता है; फिर, गणितीय तकनीकों का उपयोग करते हुए, यह सिंगुलर वैल्यू डिकंपोजिशन (SVD) के माध्यम से मॉडल के वजन को कार्य की आवश्यकताओं के साथ संरेखित करता है। Transformer² महत्वपूर्ण घटकों के वजन को चयनात्मक रूप से समायोजित करके, वास्तविक समय में प्रदर्शन को अनुकूलित करने में सक्षम है, बिना समय लेने वाले पुनः प्रशिक्षण की आवश्यकता के। यह पारंपरिक फाइन-ट्यूनिंग विधियों से स्पष्ट रूप से भिन्न है, जिन्हें प्रशिक्षण के बाद स्थिर पैरामीटर बनाए रखने की आवश्यकता होती है, या लो-रैंक अनुकूलन (LoRA) जैसी विधियों का उपयोग करते हुए केवल एक छोटे हिस्से के पैरामीटर को संशोधित किया जाता है।

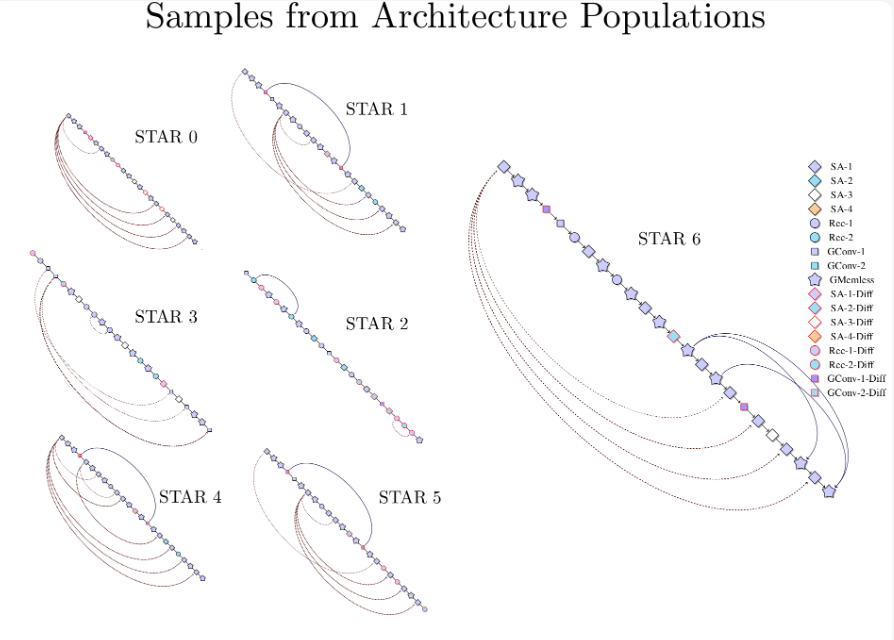

Transformer स्क्वायर प्रशिक्षण और निष्पादन (स्रोत:arXiv)

गतिशील समायोजन को प्राप्त करने के लिए, शोधकर्ताओं ने सिंगुलर वैल्यू फाइन-ट्यूनिंग (SVF) विधि का उपयोग किया। प्रशिक्षण के दौरान, SVF मॉडल के SVD घटकों से एक सेट सीखा जाता है जिसे z वेक्टर के रूप में जाना जाता है। निष्पादन के दौरान, Transformer² आवश्यक कौशल निर्धारित करने के लिए संकेतों का विश्लेषण करता है, और फिर संबंधित z वेक्टर को कॉन्फ़िगर करता है, जिससे प्रत्येक संकेत के लिए अनुकूलित प्रतिक्रिया प्राप्त होती है।

परीक्षण परिणामों से पता चलता है कि Transformer² गणित, कोडिंग, तर्क और दृश्य प्रश्न-उत्तर जैसे विभिन्न कार्यों में LoRA मॉडल से बेहतर प्रदर्शन करता है, और इसके पास कम पैरामीटर हैं। और भी महत्वपूर्ण बात यह है कि इस मॉडल में ज्ञान स्थानांतरण की क्षमता है, अर्थात् एक मॉडल से सीखे गए z वेक्टर को दूसरे मॉडल पर लागू किया जा सकता है, जो व्यापक अनुप्रयोग की संभावनाओं को दर्शाता है।

Transformer-squared (तालिका में SVF) की तुलना मूल मॉडल और LoRA से (स्रोत:arXiv)

Sakana AI ने अपने GitHub पृष्ठ पर Transformer² घटकों के प्रशिक्षण कोड को प्रकाशित किया है, जिससे अन्य शोधकर्ताओं और डेवलपर्स के लिए दरवाजे खोल दिए गए हैं।

जैसे-जैसे व्यवसाय LLM के अनुप्रयोगों का अन्वेषण करते हैं, निष्पादन के समय अनुकूलन तकनीक धीरे-धीरे मुख्यधारा का रुख बन रही है। Transformer² Google के Titans जैसी अन्य तकनीकों के साथ मिलकर LLM के अनुप्रयोगों के तरीके को बदल रहा है, जिससे उपयोगकर्ताओं को अपने विशिष्ट आवश्यकताओं के अनुसार मॉडल को गतिशील रूप से समायोजित करने की अनुमति मिलती है, बिना पुनः प्रशिक्षण की आवश्यकता के। इस तकनीकी प्रगति से LLM को अधिक व्यापक क्षेत्रों में उपयोगी और व्यावहारिक बनाया जाएगा।

Sakana AI के शोधकर्ताओं का कहना है कि Transformer² स्थिर आर्टिफिशियल इंटेलिजेंस और जीवन्त बुद्धिमत्ता के बीच एक पुल का प्रतिनिधित्व करता है, जो कुशल, व्यक्तिगत और पूरी तरह से एकीकृत आर्टिफिशियल इंटेलिजेंस उपकरणों की नींव रखता है।