Ficou até tarde trabalhando na revisão de literatura? Arrancando os cabelos escrevendo um artigo científico? Não se preocupe! Os grandes pesquisadores da AI2 estão aqui para te salvar com sua mais nova criação, o OpenScholar! Esta ferramenta de eficiência para pesquisa científica fará com que a revisão de literatura seja tão fácil e agradável quanto um passeio no parque!

A maior arma secreta do OpenScholar é o OpenScholar-Datastore (OSDS), contendo 450 milhões de artigos científicos de acesso aberto e 237 milhões de parágrafos de artigos incorporados. Com esse vasto conhecimento, o OpenScholar consegue lidar com facilidade com os desafios da pesquisa científica.

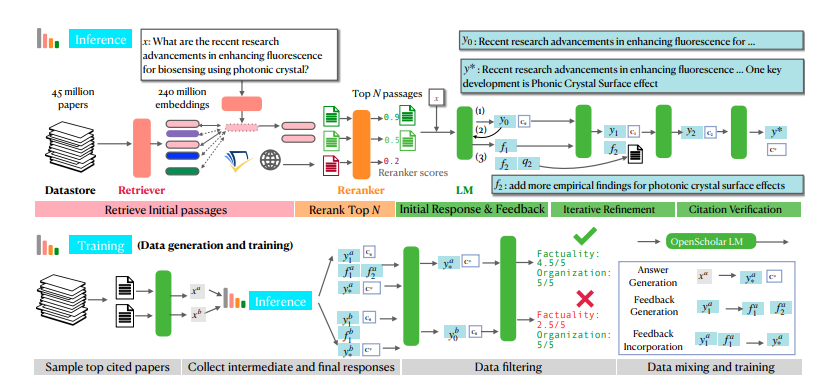

Quando você encontra um problema de pesquisa, o OpenScholar envia seus principais aliados – o mecanismo de busca e o reordenador – para filtrar rapidamente os parágrafos de artigos relevantes no OSDS. Em seguida, um modelo de linguagem (LM) fornece uma resposta completa, incluindo referências. E o melhor: o OpenScholar aprimora a resposta continuamente com base em seu feedback em linguagem natural, preenchendo informações faltantes até você ficar satisfeito.

O OpenScholar não apenas é poderoso por si só, mas também ajuda a treinar modelos menores e mais eficientes. Os pesquisadores, usando o processo do OpenScholar, geraram uma grande quantidade de dados de treinamento de alta qualidade e os usaram para treinar um modelo de linguagem de 8 bilhões de parâmetros chamado OpenScholar-8B, além de outros modelos de busca.

Para testar completamente a capacidade do OpenScholar, os pesquisadores criaram um novo banco de testes chamado SCHOLARQABENCH. Este banco de testes apresenta várias tarefas de revisão de literatura científica, incluindo classificação fechada, escolha múltipla e geração de textos longos, abrangendo campos como ciência da computação, biomedicina, física e neurociência. Para garantir a justiça e a imparcialidade da competição, o SCHOLARQABENCH utiliza métodos de avaliação multifacetados, incluindo revisão por especialistas, métricas automáticas e testes de experiência do usuário.

Após várias rodadas de competição acirrada, o OpenScholar se destacou! Os resultados experimentais mostram que ele se saiu excepcionalmente bem em todas as tarefas, superando até mesmo especialistas humanos! Essa conquista inovadora certamente revolucionará o campo da pesquisa científica, permitindo que os cientistas deixem para trás as dificuldades da revisão de literatura e se concentrem na exploração dos mistérios da ciência!

A poderosa funcionalidade do OpenScholar é principalmente devido ao seu mecanismo exclusivo de raciocínio aprimorado por recuperação com feedback automático. Em termos simples, ele primeiro se faz perguntas e, em seguida, aprimora suas respostas com base em suas próprias respostas, apresentando a você a resposta mais perfeita. Não é incrível?

Especificamente, o processo de raciocínio com feedback automático do OpenScholar é dividido em três etapas: geração de resposta inicial, geração de feedback e integração de feedback. Primeiro, o modelo de linguagem gera uma resposta inicial com base nos parágrafos de artigos recuperados. Em seguida, como um examinador rigoroso, ele autocritica sua resposta, identifica deficiências e gera feedback em linguagem natural, como "A resposta contém apenas os resultados experimentais da tarefa de perguntas e respostas; por favor, adicione os resultados de outros tipos de tarefas". Finalmente, o modelo de linguagem recupera novamente a literatura relevante com base nesse feedback e integra todas as informações para gerar uma resposta mais completa.

Para treinar modelos menores, mas com desempenho igualmente poderoso, os pesquisadores também usaram o processo de raciocínio com feedback automático do OpenScholar para gerar uma grande quantidade de dados de treinamento de alta qualidade. Eles selecionaram artigos com maior número de citações no banco de dados, geraram perguntas de consulta de informações com base nos resumos desses artigos e, finalmente, usaram o processo de raciocínio do OpenScholar para gerar respostas de alta qualidade. Essas respostas e as informações de feedback geradas intermediariamente constituem dados de treinamento valiosos. Os pesquisadores misturaram esses dados com dados de ajuste fino de instruções de domínio geral e dados de ajuste fino de instruções de domínio científico existentes para treinar um modelo de linguagem de 8 bilhões de parâmetros chamado OpenScholar-8B.

Para avaliar de forma mais abrangente o desempenho do OpenScholar e de outros modelos semelhantes, os pesquisadores também criaram um novo benchmark chamado SCHOLARQABENCH. Este benchmark contém 2967 perguntas de revisão de literatura escritas por especialistas, cobrindo quatro campos: ciência da computação, física, biomedicina e neurociência. Cada pergunta tem uma resposta longa escrita por especialistas; em média, cada resposta leva cerca de uma hora para ser concluída por um especialista. O SCHOLARQABENCH também usa um método de avaliação multifacetado, combinando métricas automáticas e avaliação humana, para medir de forma mais abrangente a qualidade das respostas geradas pelo modelo.

Os resultados experimentais mostram que o OpenScholar superou em muito outros modelos no SCHOLARQABENCH, e até mesmo superou especialistas humanos em alguns aspectos! Por exemplo, na área de ciência da computação, a taxa de precisão do OpenScholar-8B é 5% maior que a do GPT-4o e 7% maior que a do PaperQA2. Além disso, a precisão das citações nas respostas geradas pelo OpenScholar é comparável à dos especialistas humanos, enquanto o GPT-4o tem uma taxa de fabricação de 78-90%.

O surgimento do OpenScholar é, sem dúvida, uma grande bênção para o campo da pesquisa científica! Ele não apenas ajuda os pesquisadores a economizar tempo e esforço, mas também melhora a qualidade e a eficiência da revisão de literatura. Acreditamos que, em um futuro próximo, o OpenScholar se tornará um assistente indispensável para os pesquisadores!

Endereço do artigo: https://arxiv.org/pdf/2411.14199

Endereço do projeto: https://github.com/AkariAsai/OpenScholar