No campo da inteligência artificial, mais uma notícia importante chega. Esta madrugada, a plataforma de treinamento de grandes modelos conhecida como Together.ai e a Agentica lançaram conjuntamente o framework de agente de IA de código aberto DeepSWE. Este sistema inovador é baseado no modelo Qwen3-32B mais recente da Alibaba, treinado totalmente por meio de aprendizado por reforço.

As informações sobre o código aberto do DeepSWE podem ser encontradas no Hugging Face. Além dos pesos do modelo, todos os conteúdos relacionados, como métodos de treinamento, logs e conjuntos de dados, também estão disponíveis publicamente, com o objetivo de ajudar os desenvolvedores a compreender e melhorar este sistema de agentes de forma mais aprofundada.

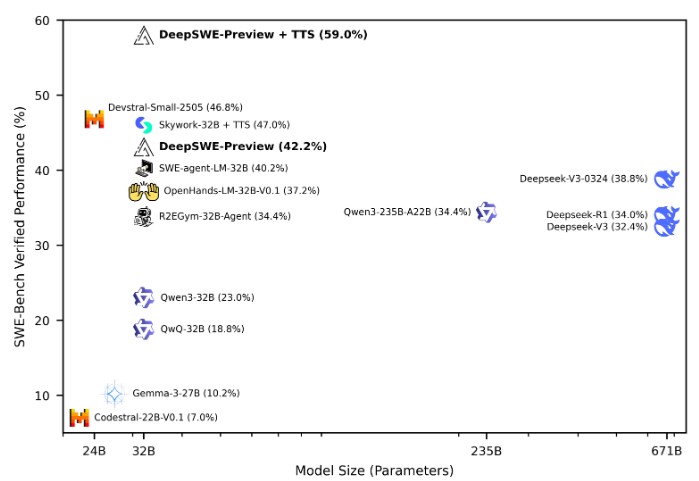

De acordo com os resultados do teste SWE-Bench-Verified, o DeepSWE foi avaliado com um comprimento máximo de contexto de 64k e 100 etapas máximas no ambiente, e alcançou uma taxa de pass@1 de 42,2% após 16 execuções. Após testes mistos, seu desempenho subiu para 59%, colocando-o em primeiro lugar entre todos os frameworks de agentes de código aberto.

O treinamento do DeepSWE utilizou o framework rLLM, um sistema especialmente desenvolvido para o treinamento posterior de agentes de linguagem. Ele foi treinado durante seis dias em 64 GPUs H100, usando 4500 tarefas reais de engenharia de software provenientes do ambiente de treinamento R2E-Gym. Essas tarefas incluem resolver problemas no GitHub, implementar novas funcionalidades de código e depurar, demonstrando a diversidade da engenharia de software no mundo real.

Durante o processo de treinamento, o DeepSWE aprendeu a navegar em grandes bibliotecas de código, editar código de forma direcionada, executar comandos shell para construir e testar, e otimizar soluções ao lidar com solicitações de pull reais. Em termos de gestão de conjunto de dados, foram usadas 4500 questões do subconjunto R2E-Gym, garantindo a pureza e a relevância dos dados de treinamento.

O ambiente de treinamento foi construído em torno do R2E-Gym, oferecendo um ambiente de engenharia de software escalável e de alta qualidade. A mecânica de recompensa utilizou um modelo de recompensa baseado em resultados raros, fornecendo recompensas positivas apenas quando o patch gerado passa por todos os testes, promovendo um aprendizado mais eficaz.

O treinamento do DeepSWE também utilizou o algoritmo GRPO++ modificado, que, ao integrar várias inovações, alcançou um processo de treinamento mais estável e eficiente. Além disso, os pesquisadores descobriram que aumentar o número de tokens de saída teve pouco efeito nas tarefas de engenharia de software, enquanto estender o número de rodadas teve um impacto significativo no desempenho do modelo.

Esses esforços fizeram do DeepSWE um sistema de agente de IA com grande potencial, impulsionando avanços na aplicação prática do aprendizado por reforço.

Endereço do código aberto: https://huggingface.co/agentica-org/DeepSWE-Preview

Destaque:

🌟 O DeepSWE é baseado no modelo Qwen3-32B e foi totalmente treinado por meio de aprendizado por reforço; as informações de código aberto já foram totalmente divulgadas.

🏆 No teste SWE-Bench-Verified, o DeepSWE se destacou, atingindo uma taxa de pass@1 de 59%, tornando-se o melhor entre todos os frameworks de agentes de código aberto.

💡 Utilizando o framework rLLM e o algoritmo GRPO++ aprimorado, o DeepSWE demonstrou sua forte capacidade de aprendizado e potencial de aplicação nas tarefas de engenharia de software.