Recentemente, a equipe Seed da ByteDance colaborou com a Universidade de Hong Kong e a Universidade Fudan para lançar um novo método inovador de treinamento de aprendizado por reforço chamado POLARIS. Esse método, por meio de uma estratégia de escalonamento de aprendizado por reforço bem planejada, conseguiu melhorar significativamente a capacidade de raciocínio matemático dos modelos pequenos, alcançando níveis comparáveis aos de modelos muito maiores, oferecendo assim uma nova abordagem para a otimização de modelos pequenos na área de inteligência artificial.

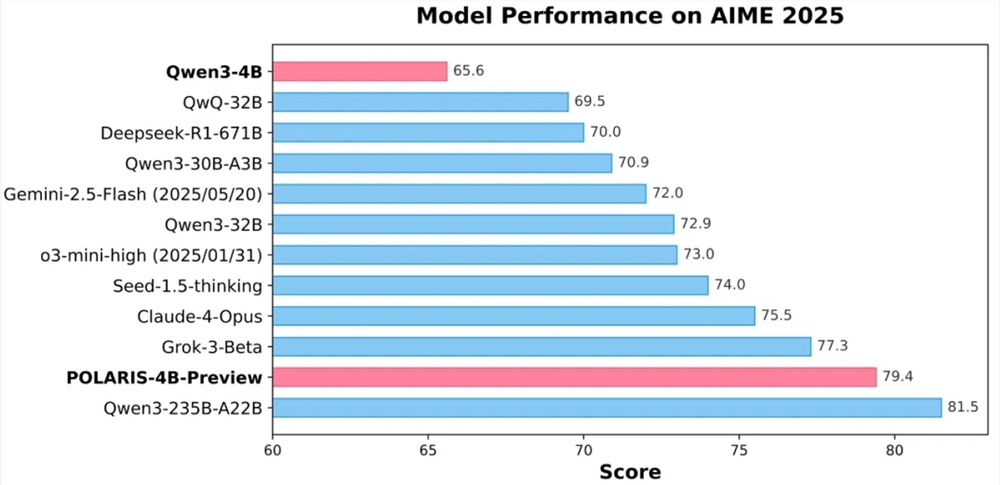

Os resultados experimentais mostraram que o modelo de código aberto Qwen3-4B com 4 bilhões de parâmetros treinado pelo POLARIS obteve altas taxas de precisão de 79,4% e 81,2% nos testes matemáticos AIME25 e AIME24, superando alguns modelos fechados maiores. Destaca-se especialmente o design leve do modelo POLARIS-4B, que permite sua implantação facilmente em placas de vídeo de uso comum, reduzindo significativamente as barreiras de aplicação.

A inovação central do POLARIS está na sua estratégia de treinamento. A equipe de pesquisa descobriu que ao personalizar os dados de treinamento e os parâmetros de superajuste para o modelo em treinamento, é possível melhorar significativamente a capacidade de raciocínio matemático dos modelos pequenos. Na prática, a equipe ajustou dinamicamente a distribuição da dificuldade dos dados de treinamento, criando um conjunto de dados ligeiramente inclinado para problemas difíceis, evitando assim que a dificuldade dos exemplos fosse muito concentrada. Além disso, introduziu uma estratégia de atualização dinâmica dos dados, removendo dinamicamente os exemplos muito fáceis com base no desempenho do modelo durante o treinamento, garantindo assim a eficácia do treinamento.

No controle da amostragem, o POLARIS equilibra o desempenho do modelo e a diversidade das trajetórias de geração ajustando cuidadosamente a temperatura da amostragem. A pesquisa revelou que a temperatura da amostragem tem um impacto significativo no desempenho do modelo e na diversidade das trajetórias. Temperaturas muito altas ou baixas prejudicam o treinamento do modelo. Portanto, a equipe propôs um método de inicialização da temperatura que controla a área de exploração e ajustou dinamicamente a temperatura da amostragem durante o treinamento, mantendo assim a diversidade do conteúdo gerado.

Diante dos desafios do treinamento com longos contextos, o POLARIS introduziu uma tecnologia de extrapolação de comprimento, ajustando os códigos de posição (RoPE) para permitir que o modelo processe sequências ainda mais longas do que as vistas durante o treinamento. Essa estratégia inovadora compensa efetivamente as deficiências no treinamento com textos longos, melhorando o desempenho do modelo nas tarefas de geração de texto longo.

Além disso, o POLARIS também adota um método de treinamento RL em várias etapas. Em etapas iniciais, o modelo é treinado com janelas de contexto curtas, e depois, quando o desempenho do modelo converge, gradualmente aumenta-se o comprimento da janela de contexto. Essa estratégia ajuda o modelo a se adaptar gradualmente a tarefas de raciocínio mais complexas, melhorando a estabilidade e a eficácia do treinamento.

Atualmente, os detalhes sobre o método de treinamento, os dados de treinamento, o código de treinamento e os modelos experimentais do POLARIS estão todos disponíveis como código aberto. A equipe de pesquisa validou a eficácia do POLARIS em vários conjuntos de avaliação de raciocínio principais. Os resultados mostraram que modelos de diferentes tamanhos e famílias de modelos obtiveram melhorias significativas após aplicarem o método de treinamento do POLARIS.

Página inicial do GitHub:

https://github.com/ChenxinAn-fdu/POLARIS

Página inicial do Hugging Face:

https://huggingface.co/POLARIS-Project