Recientemente, ByteDance ha anunciado oficialmente su último proyecto de IA, "DreamActor-M1", un avance innovador diseñado para revolucionar la tecnología de generación de video. Este modelo, combinando una foto estática y un video de referencia de movimientos, puede reemplazar sin problemas a la persona de la foto en una escena de video, generando imágenes dinámicas con expresiones delicadas, movimientos naturales y alta calidad de imagen. Este lanzamiento no solo marca otro gran avance de ByteDance en el campo de la IA generativa, sino que también se considera un poderoso desafío a las herramientas de generación de animación existentes (como Act-One de Runway).

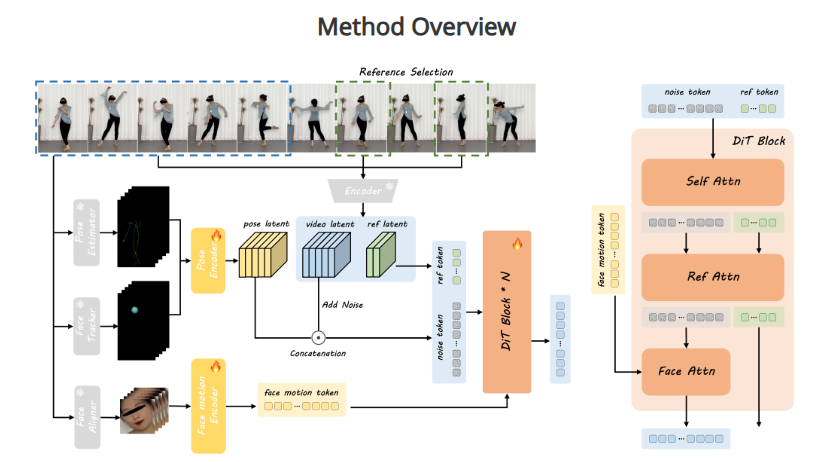

La innovación central de DreamActor-M1 radica en su preciso control de los detalles y su consistencia. Los métodos tradicionales de generación de video a partir de imágenes a menudo enfrentan numerosos desafíos, como la falta de expresividad en las expresiones faciales, transiciones de movimiento poco naturales y discrepancias o "errores" de detalle en videos largos. DreamActor-M1, mediante un diseño de algoritmo avanzado, ha superado con éxito estos obstáculos tecnológicos. Desde la curvatura de la comisura de los labios al sonreír, el ritmo natural del parpadeo, hasta los sutiles cambios en el temblor de los labios, el modelo puede representarlos con un realismo sorprendente. Simultáneamente, puede controlar los movimientos corporales, como girar la cabeza, levantar la mano o incluso bailar, asegurando la coordinación y fluidez general de la imagen.

Según el análisis técnico, este logro podría deberse a la sólida experiencia de ByteDance en aprendizaje profundo y procesamiento de video. DreamActor-M1 no solo puede capturar los patrones de movimiento del video de referencia, sino que también puede fusionarlos perfectamente con las características de la persona en la foto estática. El resultado conserva la singularidad de la identidad original, evitando los fenómenos comunes de "distorsión" o "movimiento errático". Esta salida de alta fidelidad alcanza un estándar de alta definición en calidad de imagen, ofreciendo a los usuarios una experiencia visual cercana a una grabación real.

Expertos del sector señalan que el lanzamiento de DreamActor-M1 llena un vacío importante en el campo de la generación de video con IA. En comparación con las tecnologías existentes como Act-One de Runway, este modelo destaca por su control de grano fino (como la reproducción de microexpresiones) y la sincronización de movimientos multidimensionales (como la coordinación entre la cara y las extremidades). Esta característica le otorga un amplio potencial en diversas aplicaciones. Por ejemplo, en la producción cinematográfica, los directores pueden usar una sola foto para generar rápidamente la actuación dinámica de un personaje; en las redes sociales, los usuarios pueden convertir sus fotos en videos animados divertidos; en la educación o la realidad virtual, esta tecnología también puede apoyar la creación de contenido inmersivo.

Sin embargo, el lanzamiento de DreamActor-M1 también ha suscitado una reflexión profunda sobre las aplicaciones de la tecnología. Su capacidad de generación de alta fidelidad podría revolucionar la creación de contenido digital, pero también podría exacerbar el debate sobre las falsificaciones profundas ("deepfakes") y la protección de la privacidad. ByteDance aún no ha revelado el origen de los datos de entrenamiento específicos del modelo o sus planes de comercialización, pero el público espera que en el futuro proporcione más detalles para equilibrar la innovación tecnológica con las normas éticas.

Como empresa matriz de TikTok, ByteDance ha intensificado su presencia en el campo de la IA en los últimos años. Desde la generación de imágenes hasta la animación de video, su investigación y desarrollo tecnológico avanza constantemente hacia una dirección multimodal más compleja. El lanzamiento de DreamActor-M1 no solo es una prueba más de su propia fortaleza tecnológica, sino también un paso firme en la competencia global de IA. Es previsible que, a medida que este modelo se perfeccione y se difunda, podría redefinir la forma de crear contenido de video, aportando más sorpresas y posibilidades a los usuarios y al sector.

Dirección del proyecto: https://grisoon.github.io/DreamActor-M1/