Recientemente, la empresa MiniMax anunció el lanzamiento de su nuevo modelo MiniMax-M1, que se convierte en el primer modelo de inferencia masivo con arquitectura híbrida abierta en todo el mundo. Este modelo ha demostrado un rendimiento sobresaliente en escenarios productivos complejos y se ha convertido en un líder entre los modelos open source. MiniMax-M1 no solo supera a los modelos cerrados domésticos, sino que también está cerca del nivel de los modelos más avanzados del extranjero, manteniendo al mismo tiempo el mejor costo-beneficio en la industria.

Un aspecto destacado de MiniMax-M1 es su capacidad para aceptar hasta 1 millón de tokens de entrada de contexto, lo que lo equipara con el modelo cerrado Google Gemini2.5Pro y es 8 veces mayor que DeepSeek R1. Además, puede generar resultados de inferencia de hasta 80 mil tokens. Este logro se debe a la arquitectura híbrida innovadora de MiniMax, centrada en el mecanismo de atención en forma de rayo, lo que mejora significativamente la eficiencia al procesar entradas de contexto largas y realizar inferencias profundas. Por ejemplo, durante la inferencia profunda con 80 mil tokens, MiniMax-M1 solo necesita aproximadamente el 30% de la potencia de cálculo que requiere DeepSeek R1, lo que le da una ventaja en términos de eficiencia de potencia de cómputo tanto en entrenamiento como en inferencia.

Además, MiniMax propuso un algoritmo de refuerzo rápido llamado CISPO, que mejora la eficiencia del aprendizaje por refuerzo recortando los pesos de muestreo de importancia. En las pruebas de AIME, el rendimiento de convergencia del algoritmo CISPO fue el doble que otros algoritmos de aprendizaje por refuerzo, incluida la versión reciente de DAPO de ByteDance, y significativamente superior al algoritmo GRPO utilizado previamente por DeepSeek. Estas innovaciones tecnológicas hicieron que el proceso de entrenamiento por refuerzo de MiniMax-M1 fuera extremadamente eficiente, usando solo 512 bloques H800 durante tres semanas, reduciendo drásticamente los costos de alquiler y disminuyendo en una magnitud un número esperado.

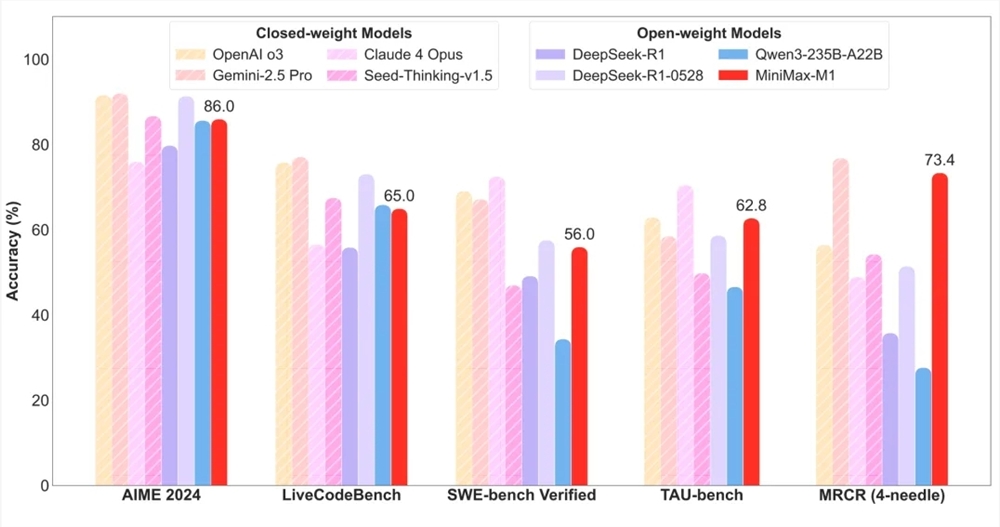

En términos de evaluación, MiniMax-M1 obtuvo excelentes resultados en 17 conjuntos de pruebas principales de la industria. En particular, en escenarios productivos complejos como ingeniería de software, contextos largos y uso de herramientas, MiniMax-M1 mostró una ventaja significativa. Por ejemplo, en el conjunto de pruebas SWE-bench, MiniMax-M1-40k y MiniMax-M1-80k obtuvieron puntuaciones del 55.6% y 56.0%, respectivamente, ligeramente por debajo del 57.6% de DeepSeek-R1-0528, pero claramente superaron a otros modelos de pesos abiertos. Al mismo tiempo, gracias a su ventana de contexto de un millón de tokens, MiniMax-M1 destacó excepcionalmente en tareas de comprensión de contextos largos, superando todos los modelos de pesos abiertos y, en algunos aspectos, incluso superando a OpenAI o3 y Claude4Opus, ocupando el segundo lugar mundial.

Es importante señalar que MiniMax-M1 también lidera a todos los modelos de pesos abiertos en escenarios de uso de herramientas (TAU-bench) y superó a Gemini-2.5Pro. Además, MiniMax-M1-80k siempre superó a MiniMax-M1-40k en la mayoría de las pruebas de referencia, lo que confirma plenamente la efectividad del aumento de los recursos de cálculo.

En términos de precio, MiniMax-M1 mantiene el costo más bajo en la industria. Los usuarios pueden usar este modelo sin límite de cantidad de forma gratuita en la aplicación MiniMax y en la web, y pueden comprar servicios de API a precios muy competitivos a través del sitio oficial. Esta medida sin duda promoverá aún más la popularización y aplicación de MiniMax-M1 en el mercado.