El 17 de junio, la unicornio de IA en Shanghái, MiniMax, lanzó su nuevo modelo M1 desarrollado recientemente, que se describe como el primer modelo de inferencia masivo de arquitectura híbrida de código abierto en el mundo. Este innovador modelo ha logrado avances significativos tanto en la capacidad de procesamiento del contexto como en el control de costos.

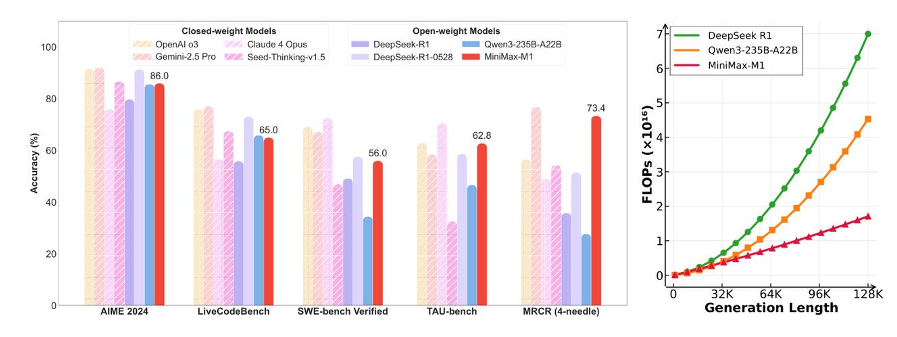

El mayor punto destacado del modelo MiniMax-M1 es que soporta de forma nativa hasta 1 millón de tokens en la ventana de contexto, e incluso admite la salida más larga de 80 mil tokens en la inferencia. Este avance tecnológico está a la par con Gemini2.5Pro de Google y, además, en la escena de uso de herramientas (TAU-bench), la versión MiniMax-M1-40k superó a Gemini-2.5Pro, demostrando así su gran potencial. Además, MiniMax mencionó que el costo de entrenamiento reforzado del modelo M1 fue solo de 535.000 dólares, lo que redujo un orden de magnitud en comparación con versiones anteriores.

En términos de estrategia de precios, MiniMax adoptó un modelo de tarificación escalonada, donde el costo aumenta en función del crecimiento de la longitud del texto de entrada. Concretamente, para una entrada entre 0-32k tokens, el costo es de 0,8 yuanes por millón de tokens, mientras que la salida cuesta 8 yuanes por millón de tokens; para el rango de 32k-128k tokens, los costos son de 1,2 y 16 yuanes respectivamente; y para el rango de 128k-1M tokens, los costos de entrada y salida son de 2,4 y 24 yuanes respectivamente. Esta configuración de precios hace que MiniMax-M1 sea aún más competitivo en el mercado, especialmente en las dos primeras categorías de precios, que están por debajo de productos similares como DeepSeek-R1.

Es importante destacar que MiniMax también lanzó el algoritmo CISPO en esta ocasión, cuya velocidad de convergencia es el doble de rápida que el algoritmo DAPO recientemente presentado por ByteDance, y la demanda de potencia informática durante la etapa de aprendizaje por refuerzo es solo el 30% de la necesaria para DeepSeek R1. Esto hace que el modelo MiniMax-M1 sea más eficiente en términos de entrenamiento, usando recursos computacionales significativamente menores, lo que reduce aún más los costos operativos.

Ante los "seis pequeños tigres" de la industria de la IA, este lanzamiento marca el deseo de MiniMax de continuar avanzando en la competencia de modelos grandes. Con la próxima llegada de DeepSeek R2, el panorama del mercado será aún más complejo. MiniMax también sigue actualizando su tecnología de código abierto y se espera que en los próximos días haya más tecnología y productos nuevos.