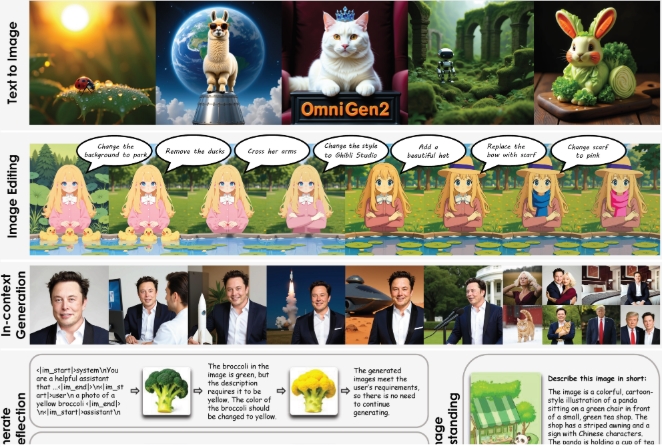

Hace poco, el Instituto de Inteligencia Artificial de Beijing lanzó un nuevo sistema de código abierto: OmniGen2. Este sistema se centra en la generación de imágenes a partir de texto, la edición de imágenes y la creación de imágenes en contexto.

En comparación con la primera generación OmniGen, lanzada en 2024, OmniGen2 utiliza dos caminos de descodificación independientes: uno para la generación de texto y otro para la generación de imágenes, cada uno con sus propios parámetros y un codificador de imágenes desacoplado. Este diseño permite que el modelo mantenga su capacidad de generación de texto mientras mejora eficazmente el rendimiento del modelo de lenguaje multimodal.

El núcleo de OmniGen2 es un gran modelo de lenguaje multimodal (MLLM) basado en el transformador Qwen2.5-VL-3B. En cuanto a la generación de imágenes, este sistema utiliza un transformador de difusión personalizado con aproximadamente 4 mil millones de parámetros. El modelo cambia automáticamente al modo de generación de imágenes cuando encuentra la etiqueta especial "<|img|>". Destaca que OmniGen2 puede manejar diversos tipos de indicaciones y estilos artísticos, pero las imágenes generadas con alta fidelidad aún tienen margen de mejora en términos de claridad.

Para entrenar OmniGen2, el equipo de investigación utilizó aproximadamente 140 millones de imágenes provenientes de conjuntos de datos de código abierto y colecciones privadas. Además, desarrollaron nuevas tecnologías para extraer cuadros similares de videos (por ejemplo, rostros sonrientes y no sonrientes), y utilizar modelos de lenguaje para generar instrucciones de edición correspondientes.

Otra característica destacada de OmniGen2 es su mecanismo de reflexión, que permite al modelo evaluarse a sí mismo y mejorar la imagen generada en varios ciclos. Este sistema puede detectar defectos en las imágenes generadas y proponer sugerencias específicas de corrección.

Para evaluar el rendimiento de este sistema, el equipo de investigación introdujo el conjunto de pruebas OmniContext, que incluye tres categorías principales: personajes, objetos y escenas, cada una con ocho sub-tareas y cinco ejemplos cada uno. La evaluación se realizó mediante GPT-4.1, con criterios principales como la precisión de las indicaciones y la coherencia temática. El puntaje total de OmniGen2 fue de 7,18, superando a todos los demás modelos de código abierto, mientras que el puntaje de GPT-4o fue de 8,8.

Aunque OmniGen2 mostró un excelente rendimiento en varios conjuntos de pruebas, aún tiene algunas deficiencias: los efectos de las indicaciones en inglés son mejores que los de las indicaciones en chino, los cambios en la forma corporal son bastante complejos y la calidad de salida también depende de la imagen de entrada. Para indicaciones multimagen borrosas, el sistema necesita instrucciones claras sobre la colocación de objetos.

El equipo de investigación planea publicar el modelo, los datos de entrenamiento y el pipeline de construcción en la plataforma Hugging Face.

Resumen:

🌟 OmniGen2 es un sistema de generación de texto e imágenes de código abierto que utiliza caminos de descodificación independientes para texto e imágenes.

🎨 Puede manejar la generación de imágenes con diversos estilos artísticos y tiene funciones de reflexión y mejora propia.

📈 OmniGen2 demostró un excelente rendimiento en varios conjuntos de pruebas, especialmente estableciendo un nuevo récord en la edición de imágenes en modelos de código abierto.