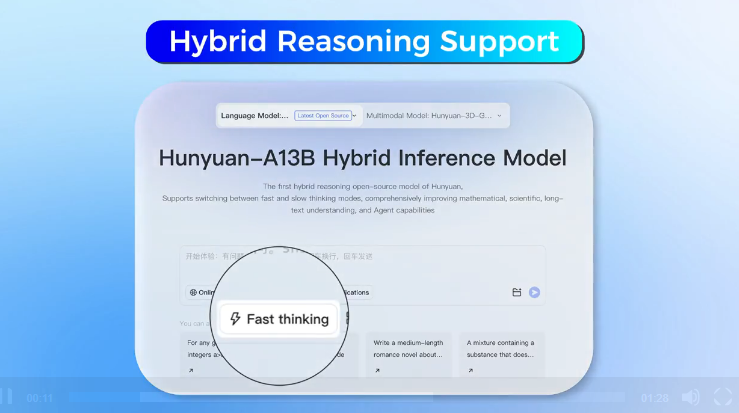

Una investigación de Apple presenta MAD-Bench, un nuevo estándar para evaluar la vulnerabilidad de los modelos de lenguaje multimodal grandes (MLLM) a la información engañosa. Este estudio incluye 850 pares de indicaciones de imágenes, evaluando la capacidad de los MLLM para manejar la coherencia entre texto e imagen.

El estudio encontró que GPT-4V mostró un mejor rendimiento en la comprensión de escenas y la confusión visual, ofreciendo indicaciones importantes para el diseño de modelos de IA. Gracias a MAD-Bench, la robustez de los modelos de IA se mejorará, haciendo que las investigaciones futuras sean más fiables.