Willkommen bei der Rubrik „KI-Tagesbericht“! Hier finden Sie Ihren täglichen Leitfaden zur Erkundung der Welt der künstlichen Intelligenz. Täglich präsentieren wir Ihnen die wichtigsten Themen aus dem KI-Bereich, mit Fokus auf Entwickler, um Ihnen zu helfen, Technologietrends zu erkennen und innovative KI-Produktanwendungen kennenzulernen.

Neue KI-Produkte hier entdecken: https://top.aibase.com/

1. Tencent HunYuan präsentiert 5 Open-Source 3D-Modelle: Generierung in 30 Sekunden, kompatibel mit mehreren Plattformen

Tencent HunYuan hat fünf neue Open-Source 3D-Generierungsmodelle auf Basis von Hunyuan3D-2.0 vorgestellt, die eine schnellere Generierungsgeschwindigkeit und detailreichere Ergebnisse bieten. Die Turbo-Modellreihe nutzt das FlashVDM-Framework zur Beschleunigung der Generierung und verkürzt die Zeit auf unter 30 Sekunden. Die verbesserte 3D-KI-Erstellungsumgebung unterstützt die Eingabe mehrerer Ansichten, sodass Benutzer durch das Hochladen weniger Bilder schnell hochwertige 3D-Modelle erstellen und die Produktionskosten senken können. Die neuen Modelle finden breite Anwendung in UGC, der Synthese von Produktmaterialien und der Generierung von Spielressourcen und erfüllen die Standards für 3D-Spielressourcen.

【AiBase Zusammenfassung:】

⚡ Die Turbo-Modellreihe erreicht durch das FlashVDM-Framework eine um das Zehnfache schnellere Generierung, die Zeit verkürzt sich auf 30 Sekunden.

🖼️ Das Hunyuan3D-2-MV-Modell kann Details besser erfassen und 3D-Ressourcen generieren, die den Erwartungen der Benutzer entsprechen.

🛠️ Die verbesserte Engine unterstützt die Eingabe mehrerer Ansichten. Benutzer müssen nur 2-4 Bilder hochladen, um schnell hochwertige 3D-Modelle zu generieren.

2. Anthropic veröffentlicht großes Update des MCP-Übertragungsmechanismus: Ende der Dauerverbindungen, Willkommen für flexibleres Streamable HTTP

Anthropic hat ein wichtiges Update für das Model Context Protocol (MCP) veröffentlicht und die Streamable HTTP-Übertragungsmethode eingeführt, die die herkömmliche HTTP+SSE-Lösung ersetzt. Diese Innovation behebt die wichtigsten Einschränkungen der MCP-Fernübertragung und verbessert Flexibilität und Kompatibilität. Der neue Mechanismus ermöglicht eine effizientere bidirektionale Kommunikation zwischen Client und Server, unterstützt den Betrieb von serverseitigen zustandslosen Servern, vereinfacht den Bereitstellungsprozess und verbessert die Skalierbarkeit des Systems.

【AiBase Zusammenfassung:】

🚀 Der spezielle /sse-Endpunkt wird entfernt, alle Nachrichten werden über den einheitlichen /message-Endpunkt übertragen, was den Kommunikationsprozess vereinfacht.

🔄 Der Server kann HTTP-Anfragen dynamisch auf SSE-Streams upgraden und unterstützt flexible bidirektionale Kommunikation, wodurch die einseitige Einschränkung von SSE behoben wird.

🌐 Die Kompatibilität des neuen Ansatzes wurde deutlich verbessert. Er eignet sich für verschiedene Netzwerkinfrastrukturen, unterstützt den zustandslosen Modus und reduziert den Ressourcenverbrauch.

Detaillierte Informationen: https://github.com/modelcontextprotocol/specification/pull/206

3. Shengshu Technology Vidu wird die erste im Ausland produzierte KI-Original-Science-Fiction-Anime-Serie produzieren

Shengshu Technology Co., Ltd. und Aura Productions haben eine strategische Partnerschaft geschlossen, um die erste im Ausland produzierte KI-Original-Science-Fiction-Anime-Serie herauszubringen. Diese Zusammenarbeit markiert den Einsatz von KI-Technologie in der Anime-Produktion und läutet ein neues Kapitel in der Anime-Branche ein. Beide Seiten werden gemeinsam eine 50-teilige Kurzfilm-Science-Fiction-Anime-Serie produzieren und die fortschrittliche Videogenerierungstechnologie von Vidu nutzen, um die Produktionseffizienz und -qualität zu verbessern. Dies deutet darauf hin, dass die zukünftige Anime-Kreation intelligenter und effizienter werden wird.

【AiBase Zusammenfassung:】

🚀 Zusammenarbeit bei der Produktion einer 50-teiligen Kurzfilm-Science-Fiction-Anime-Serie, die auf den wichtigsten globalen Social-Media-Plattformen veröffentlicht werden soll.

🤖 Die Funktion der Mehrsubjekt-Konsistenz von Vidu stellt die nahtlose Integration von Charakteren und Szenen sicher und ermöglicht eine hochwertige Animationserzählung.

⏱️ Die Version 2.0 von Vidu verbessert die Effizienz der Videogenerierung erheblich und kann innerhalb von 10 Sekunden hochwertige Videos generieren.

4. Google Cloud präsentiert das hochauflösende Sprachmodell Chirp 3 mit Unterstützung für 248 Stimmen

Google Cloud hat in der DeepMind-Zentrale in London das hochauflösende Sprachmodell Chirp 3 vorgestellt, das Entwicklern ein leistungsstarkes Werkzeug für die Sprachsynthese bieten soll. Das Modell unterstützt 248 verschiedene Stimmen und 31 Sprachen und kann Entwicklern bei der Erstellung intelligenter Sprachassistenten, Hörbüchern und der Sprachausgabe von Videos helfen. Um eine verantwortungsvolle Nutzung zu gewährleisten, beschränkt Google den Zugriff auf die Sprachklonfunktion und bekräftigt sein Engagement für den Datenschutz.

【AiBase Zusammenfassung:】

🌟 Google Cloud präsentiert das Chirp 3 Sprachmodell mit Unterstützung für 248 Stimmen und 31 Sprachen, um Entwickler beim Aufbau intelligenter Anwendungen zu unterstützen.

🔒 Google beschränkt den Zugriff auf die Sprachklonfunktion, um ethische KI-Praktiken zu gewährleisten und Missbrauch zu verhindern.

💼 Google startet eine Initiative zur Verbesserung der KI-Kompetenzen in Großbritannien und bietet Start-ups Unterstützung bei der Cloud-Infrastruktur, um Innovationen zu fördern.

Detaillierte Informationen: https://cloud.google.com/text-to-speech/docs/chirp3-hd

5. Musk xAI übernimmt das Videogenerierungs-Startup Hotshot, der Wettbewerb im Bereich KI-Video wird intensiver

Die Übernahme des KI-Videogenerierungs-Startups Hotshot durch Elon Musks Unternehmen xAI markiert eine weitere Expansion im Bereich der multimodalen KI-Technologie. Hotshot konzentriert sich mit seinen einzigartigen technologischen Vorteilen und leistungsstarken Rechenressourcen auf die Verbesserung der Videogenerierung.

【AiBase Zusammenfassung:】

🤖 Hotshot konzentriert sich auf die KI-Videogenerierung und nutzt 6 Millionen Videoclips für das Training, um das Verständnis des Modells für Videoinhalte zu verbessern.

⚙️ Nach der Übernahme wird Hotshot die Entwicklung von Videogeneratoren weiter ausbauen und die leistungsstarken Rechenressourcen des xAI Colossus-Supercomputers nutzen.

💼 Diese Übernahme markiert eine weitere strategische Investition von Musk im Bereich der KI-Technologie und deutet darauf hin, dass die KI-Videogenerierungstechnologie eine neue Phase der Durchbrüche erleben wird.

6. Roblox veröffentlicht Open-Source Cube3D: Das erste Basis-KI-Modell zur Generierung von 3D-Objekten

Roblox hat kürzlich Cube3D veröffentlicht und als Open Source bereitgestellt. Dies ist das erste Basis-KI-Modell des Unternehmens zur Generierung von 3D-Objekten, das darauf abzielt, die Effizienz der 3D-Erstellung zu verbessern. Das Modell nutzt innovative Trainingsmethoden, um 3D-Objekte zu tokenisieren und kann schnell vollständige 3D-Formen generieren. Zukünftig wird Cube3D zu einem multimodalen Modell weiterentwickelt, das verschiedene Eingabearten wie Text, Bilder und Videos unterstützt und die Integration in die bestehenden KI-Erstellungstools von Roblox weiter verbessert.

【AiBase Zusammenfassung:】

🛠️ Cube3D ist das erste Open-Source-KI-Modell von Roblox zur Generierung von 3D-Objekten und zielt darauf ab, die Effizienz der Entwickler zu steigern.

🔍 Das Modell nutzt innovative Trainingsmethoden, um 3D-Objekte zu tokenisieren und die nächste Form vorherzusagen, wodurch schnell vollständige 3D-Objekte erstellt werden können.

🌐 Roblox plant, Cube3D zu einem multimodalen Modell weiterzuentwickeln, das in Zukunft Text-, Bild- und Videoeingaben unterstützt und die Funktionen der Erstellungstools verbessert.

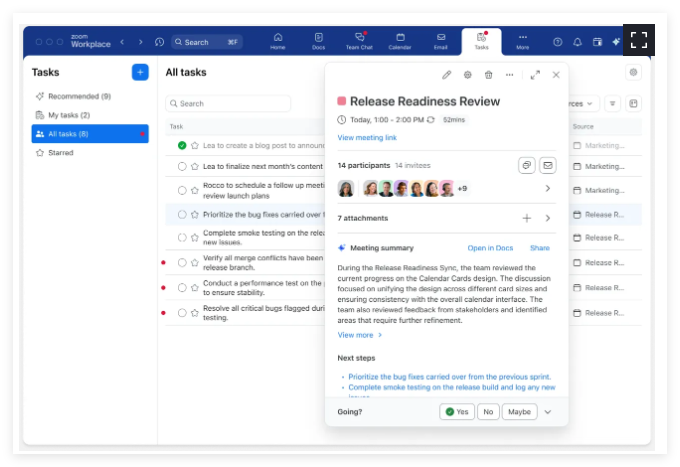

7. Zoom AI Assistent AI Companion erhält Funktions-Upgrade

Zoom hat kürzlich ein neues Funktions-Upgrade für seinen KI-Assistenten Zoom AI Companion angekündigt, das die Weiterentwicklung dieses Tools markiert und darauf abzielt, die Interaktion und die Arbeitseffizienz der Benutzer in Videokonferenzen zu verbessern. Zu den neuen Funktionen gehören Zoom Tasks zur automatischen Erkennung und Erledigung von Aufgaben, ein neuer Sprachrecorder zur Transkription von Offline-Gesprächen und ein anpassbarer KI-Assistent, die voraussichtlich die Produktivität und Zusammenarbeit der Benutzer deutlich verbessern werden.

【AiBase Zusammenfassung:】

🌟 Die Zoom Tasks-Funktion kann Aufgaben in Meetings automatisch erkennen und erledigen.

🗣️ Der neue Sprachrecorder kann Offline-Gespräche transkribieren und bietet Echtzeit-Meeting-Notizen.

📅 Die Funktion des anpassbaren KI-Assistenten wird im April eingeführt. Benutzer können die Funktionen nach Bedarf anpassen.

8. 128K extrem langes Gedächtnis! Mistral präsentiert das neueste Open-Source-Modell Mistral Small 3.1 mit überlegenen Parametern gegenüber GPT-4o Mini

Mistral AI hat das Open-Source-Modell Mistral Small 3.1 mit 24 Milliarden Parametern veröffentlicht, dessen Leistung mit Produkten von Google und OpenAI vergleichbar ist. Das Modell zeigt eine deutliche Verbesserung bei der Textverarbeitung und dem multimodalen Verständnis und unterstützt ein Kontextfenster von 128k Tokens mit einer Verarbeitungsgeschwindigkeit von 150 Tokens pro Sekunde.

【AiBase Zusammenfassung:】

🌟 Mistral Small 3.1 verfügt über 24 Milliarden Parameter und erreicht eine Leistung, die mit ähnlichen Produkten von Google und OpenAI vergleichbar ist, und fördert den Wettbewerb auf dem KI-Markt.

📈 Das Modell unterstützt ein Kontextfenster von 128k Tokens und erreicht eine Verarbeitungsgeschwindigkeit von 150 Tokens pro Sekunde, was es für lange Dokumente und schnelles Antworten geeignet macht.

🌍 Mistral verfolgt eine Open-Source-Strategie und veröffentlicht unter der Apache 2.0-Lizenz, wobei die europäische digitale Souveränität hervorgehoben wird, um globale Entwickler zur Teilnahme an Innovationen zu bewegen.

Detaillierte Informationen: https://top.aibase.com/tool/mistral-small-3-1

9. Wer sagt, dass Videos nur „in einem Take“ gedreht werden können? ByteDance-Innovation LCT lässt KI wie einen Regisseur große Filme drehen!

Das Aufkommen der Technologie zur Anpassung langer Kontexte (LCT) hat die Erzählfähigkeit der KI-Videogenerierung erheblich verbessert und ermöglicht es ihr, wie ein Filmregisseur Szenen frei zu wechseln und zusammenhängendere Handlungsszenen zu erstellen. Durch die Einführung eines vollständigen Aufmerksamkeitsmechanismus, verflochtener 3D-Positions-Einbettungen und einer asynchronen Rauschstrategie löst LCT die Probleme der visuellen Konsistenz und der zeitlichen Dynamik bei der Generierung mehrerer Szenen.

【AiBase Zusammenfassung:】

🎥 Die LCT-Technologie ermöglicht es KI-Videogenerierungsmodellen, mehrszenige Erzählvideos zu erstellen und die Erzählfähigkeit zu verbessern.

🔍 Durch den vollständigen Aufmerksamkeitsmechanismus und verflochtene 3D-Positions-Einbettungen stellt LCT visuelle Konsistenz und zeitliche Dynamik sicher.

🚀 LCT unterstützt die autoregressive Szenenerweiterung, die die Erstellung langer Videos und interaktive Änderungen erleichtert.

Detaillierte Informationen: https://top.aibase.com/tool/zhangshangxiawentiaoyoulct

10. Der „Aufstieg“ eines 32B-Parameter-Modells! OLMo 2 32B erobert den Markt und fordert GPT-3.5 Turbo heraus

OLMo 2 32B ist das neueste große Sprachmodell des Allen Institute for Artificial Intelligence. Mit 32 Milliarden Parametern und vollständig Open-Source-Charakter stellt es viele proprietäre Modelle in Frage. Durch einen präzisen Trainingsprozess übertrifft OLMo 2 32B in mehreren Benchmark-Tests GPT-3.5 Turbo und GPT-4o mini und zeigt eine hervorragende Leistung und höhere Trainingseffizienz.

【AiBase Zusammenfassung:】

🌐 OLMo 2 32B ist ein vollständig Open-Source-Sprachmodell, das alle Daten, Codes und Trainingsprozesse offenlegt und die globale Forschungskooperation fördert.

📈 Das Modell verfügt über 32 Milliarden Parameter und übertrifft in mehreren Benchmark-Tests GPT-3.5 Turbo, was die Leistungsfähigkeit von Open-Source-Modellen beweist.

⚡ OLMo 2 32B zeigt eine hervorragende Trainingseffizienz und verwendet nur ein Drittel der Rechenressourcen, was das Potenzial für eine effiziente KI-Entwicklung aufzeigt.

Detaillierte Informationen: https://github.com/allenai/OLMo-core