En agosto de 2024, iFLYTEK lanzó oficialmente la tecnología de interacción hiperrealista Spark Speed, logrando tres avances clave en velocidad de respuesta, resonancia emocional y expresión vocal controlable mediante modelos de voz de extremo a extremo y entrenamiento de descomposición emocional multidimensional. Esta tecnología puede identificar con precisión las fluctuaciones emocionales en la voz del usuario, responder con el tono adecuado en tiempo real y admitir ajustes dinámicos en velocidad de habla, tono de voz y personaje del rol, marcando un salto cualitativo en la interacción de voz, pasando de "funcionalidad" a "conexión emocional".

Actualmente, la API de interacción hiperrealista ya está disponible en la plataforma de apertura iFLYTEK, permitiendo a los desarrolladores acceder a estas capacidades a bajo costo. En el ámbito de los juegos, los NPCs pueden ajustar estrategias de diálogo según el estado emocional del jugador; en escenarios educativos, los compañeros de práctica oral de IA pueden simular reacciones reales de maestros extranjeros; en la industria turística, han surgido "guías digitales", que interactúan profundamente con los visitantes a través de roles. Un estudio piloto en un sitio turístico mostró que el guía de IA equipado con esta tecnología aumentó en un 40% el tiempo de permanencia de los visitantes y mejoró en un 25% la tasa de consumo repetido.

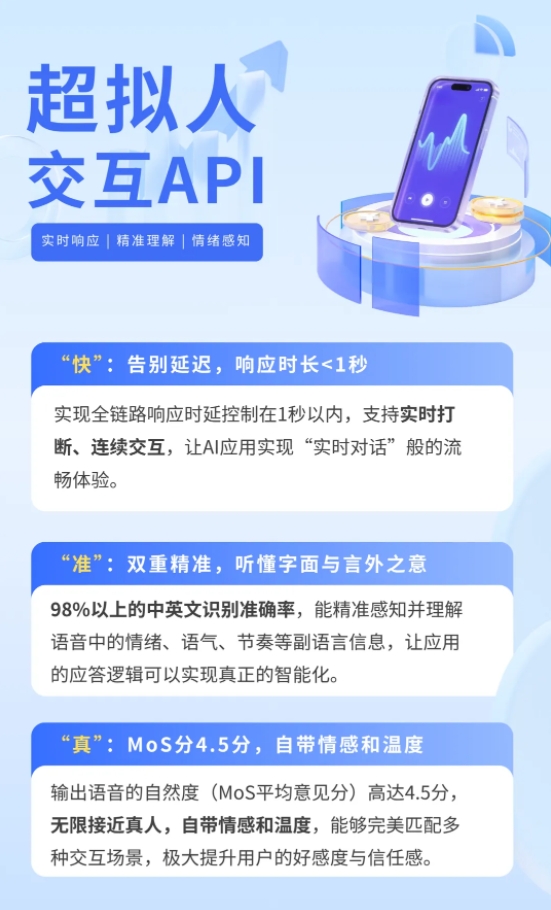

Los sistemas tradicionales de interacción de voz utilizan una arquitectura en serie "reconocimiento de voz - procesamiento por modelo grande - síntesis de voz", lo que hace que el tiempo promedio de respuesta sea superior a 3 segundos y que la transmisión emocional dependa del contenido textual, dificultando capturar información paralingüística como el tono o el ritmo de la voz. La tecnología Spark Speed de iFLYTEK utiliza un marco de red neuronal unificado para modelar de forma end-to-end desde la voz hasta la voz: después de que la señal de voz sea extraída por un codificador de audio y alineada con la representación semántica del texto, un modelo multimodal predice la representación de salida, y finalmente un decodificador de audio genera una voz sintetizada natural en emoción y precisa en ritmo. Esta innovación reduce el retardo de interacción a menos de 0,5 segundos, actualizando el modo de respuesta de "tú preguntas, yo respondo" a "diálogo en tiempo real".

Para lograr una verdadera resonancia emocional, el equipo de tecnología construyó un sistema de representación desacoplada multidimensional de propiedades de voz, separando elementos como contenido, emoción, idioma, tono de voz y ritmo para entrenamiento independiente. A través de aprendizaje comparativo y predicción de máscara, el sistema puede identificar con precisión emociones como alegría, ira o ansiedad en la voz, y ajustar automáticamente la estrategia de respuesta. Por ejemplo, cuando el usuario pregunta rápidamente sobre una ruta con urgencia, la IA planifica el camino con un tono tranquilo; cuando el usuario comparte una anécdota divertida, la IA extiende el tema con un tono ligero. Además, los desarrolladores pueden personalizar el personaje de la IA a través de la API, haciéndola tener valores específicos, estilo de lenguaje, e incluso imitar voces de celebridades para interactuar.