Hace unos días, el sitio oficial de Tencent Cloud lanzó oficialmente el servicio de API del modelo Hunyuan-A13B de Tencent. El precio de entrada se estableció en 0,5 yuanes por millón de Tokens, mientras que el precio de salida es de 2 yuanes por millón de Tokens, lo que generó una reacción calurosa en la comunidad de desarrolladores.

Como el primer modelo de razonamiento híbrido de 13B nivel MoE (Mezcla de Expertos) abierto al público, Hunyuan-A13B destaca con un diseño optimizado que tiene un total de 80B parámetros y solo 13B parámetros activos, logrando un rendimiento comparable a modelos de código abierto líderes con arquitecturas similares, y supera a estos en velocidad de razonamiento, ofreciendo una relación calidad-precio significativamente mejorada. Esta innovación no solo reduce las barreras para que los desarrolladores accedan a capacidades avanzadas de modelos, sino que también establece una base sólida para la difusión generalizada de aplicaciones de IA.

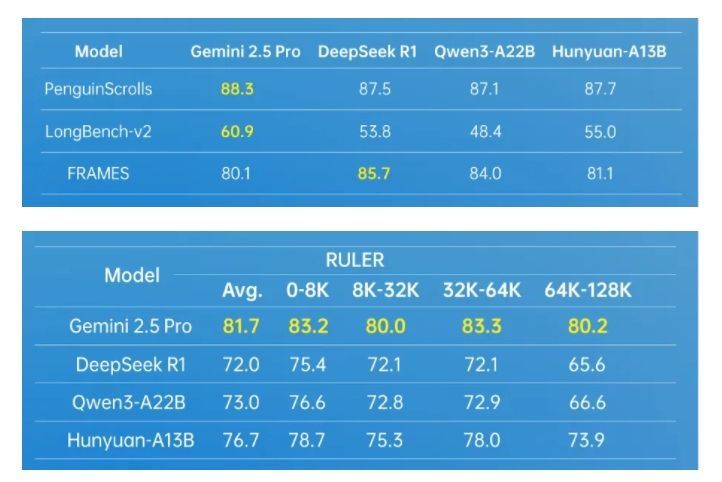

El modelo Hunyuan-A13B muestra una fuerte capacidad general gracias a su avanzada arquitectura. En varios conjuntos de datos de prueba reconocidos en la industria, el modelo obtuvo excelentes resultados, especialmente en la ejecución de herramientas de Agent y el procesamiento de textos largos. Para mejorar aún más las capacidades de los Agent, el equipo de Hunyuan de Tencent construyó un marco de síntesis de datos multi-Agent, integrando entornos diversos como MCP, sandbox y simulación de modelos de lenguaje grande, y utilizando técnicas de aprendizaje por refuerzo para permitir que los Agent exploren y aprendan de forma autónoma en diversos entornos, mejorando así significativamente la utilidad y efectividad del modelo.

En cuanto al procesamiento de textos largos, Hunyuan-A13B admite una ventana de contexto nativa de 256K, manteniendo un excelente desempeño en múltiples conjuntos de datos de textos largos. Además, el modelo introdujo de manera innovadora un modo de razonamiento combinado, permitiendo a los usuarios alternar libremente entre modos de pensamiento rápido y lento según las necesidades de la tarea, garantizando así la eficiencia de la salida y la precisión para tareas específicas, logrando una asignación óptima de recursos computacionales.

Para los desarrolladores individuales, el modelo Hunyuan-A13B también tiene una alta amabilidad. Bajo condiciones estrictas, solo se necesita una tarjeta gráfica de gama media-baja para completar la implementación. Actualmente, el modelo está integrado sin problemas en el ecosistema de marcos de razonamiento principales de código abierto, soporta varios formatos de cuantificación y, en condiciones de entrada y salida similares, su capacidad de tráfico es más del doble que la de modelos de código abierto punteros, demostrando su excelente rendimiento y flexibilidad.

El éxito de Hunyuan-A13B se debe a las tecnologías innovadoras del equipo de Hunyuan de Tencent en las etapas de preentrenamiento y postentrenamiento del modelo. Durante la etapa de preentrenamiento, el equipo entrenó una base de datos de 20T tokens, cubriendo múltiples áreas, lo que mejoró significativamente la capacidad general del modelo. Al mismo tiempo, mediante un análisis sistemático y verificación de modelos, el equipo también construyó una fórmula conjunta de Scaling Law aplicable a la arquitectura MoE, proporcionando una guía ingenieril cuantificable para el diseño de arquitecturas MoE. En la etapa de postentrenamiento, se utilizó un método de entrenamiento en varias etapas, mejorando aún más las capacidades de razonamiento y generalización del modelo.

Como uno de los modelos de lenguaje grandes más utilizados dentro de Tencent, Hunyuan-A13B ya se ha aplicado en más de 400 escenarios comerciales, con más de 130 millones de solicitudes diarias, demostrando plenamente su valor y estabilidad en aplicaciones prácticas.

https://cloud.tencent.com/product/tclm