Dans un championnat international d'échecs très médiatisé, le modèle o3 d'OpenAI a démontré une suprématie écrasante en remportant le titre avec une victoire incontestable. Ce tournoi avait une règle spéciale : les modèles d'intelligence artificielle participants devaient participer sans avoir reçu de formation spécifique aux échecs, et ne pouvaient que s'informer des bases du jeu via Internet avant la compétition.

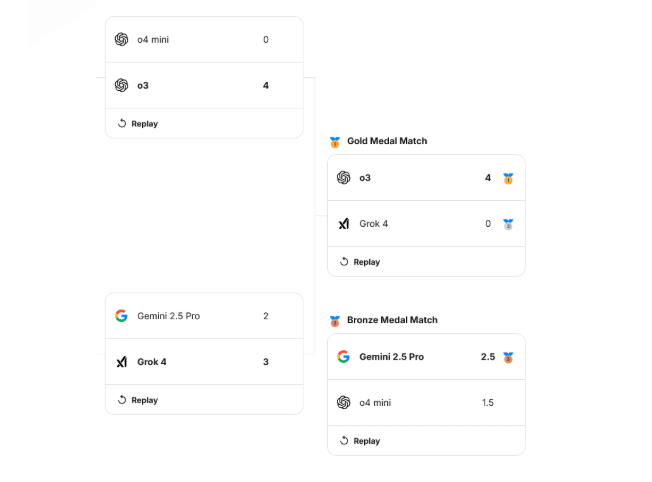

En phase finale, l'o3 a affronté le Grok4 de xAI et a remporté la rencontre avec un score écrasant de 4 à 0. Plus impressionnant encore, l'o3 a maintenu un bilan parfait pendant tout le championnat, gagnant ses trois matchs à 4-0, y compris en battant nettement le modèle o4mini, également développé par OpenAI, en demi-finale.

Grok4 a également montré un excellent niveau sur son chemin vers la finale, en battant successivement deux rivaux puissants de Google — Gemini2.5Flash et Gemini2.5Pro. À ce moment-là, Elon Musk s'était montré confiant en affirmant que l'équipe xAI "n'avait pas vraiment travaillé sur les échecs", suggérant ainsi que le Grok4 possédait une force naturelle.

Cependant, le résultat de la finale a surpris beaucoup d'observateurs. Le rédacteur en chef de Chess.com, Pedro Pinhata, a écrit dans son compte-rendu après la compétition : « Jusqu'à la demi-finale, il semblait que rien ne puisse empêcher le Grok4 de gagner. Mais cette illusion s'est brisée le dernier jour de la compétition. »

Lors d'une diffusion en direct, le maître d'échecs Hiroshi Yuki a clairement souligné : « Le Grok a commis beaucoup d'erreurs pendant le match, mais pas OpenAI. » Cette évaluation concise mettait en lumière la clé de la victoire.

Plus intéressant encore, le commentaire du champion mondial numéro un d'échecs, Magnus Carlsen. Il a déclaré que le niveau des deux modèles d'intelligence artificielle lors de la finale était comparable à celui d'un joueur ordinaire qui vient juste d'apprendre les règles, avec un classement ELO d'environ 800 points. En comparaison, le classement ELO de Carlsen est de 2839 points, tandis que celui de Hiroshi Yuki, deuxième au monde, est de 2807 points. La différence entre eux est considérable.

Carlsen a ensuite analysé plus en détail les limites de ces modèles d'intelligence artificielle générale dans le domaine des échecs. Il a constaté que leur performance était extrêmement instable, avec des performances variables. Bien qu'ils soient capables de calculer efficacement les prises de pièces, ils manquent de compétences pour véritablement mater l'adversaire. « Ils comprennent l'avantage matériel, mais pas comment gagner », a-t-il dit, illustrant cela par une comparaison : « Cela revient à être bon pour collecter des ingrédients, mais pas pour cuisiner. »

Ce résultat contraste fortement avec les IA spécialisées conçues spécifiquement pour les jeux d'échecs. Rappelons que Deep Blue, l'ordinateur superpuissant qui a battu le maître des échecs Garry Kasparov en 1997, et AlphaGo, qui a vaincu le champion de Go Lee Sedol en 2016, étaient tous deux des programmes créés spécifiquement pour ces jeux, disposant d'une connaissance approfondie et d'une formation professionnelle.

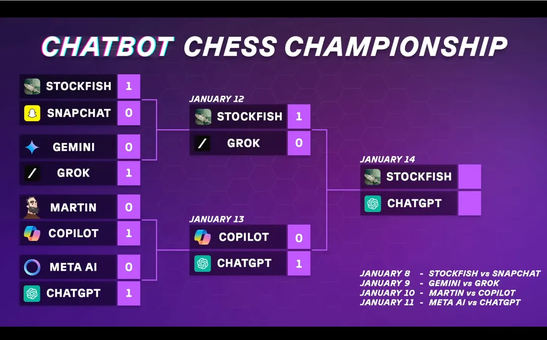

En fait, les limites des modèles d'intelligence artificielle générale dans les domaines professionnels d'échecs ont déjà été observées auparavant. Au début de cette année, lors d'un autre championnat organisé par le maître d'échecs Levy Rozman, à la fois le Grok et le ChatGPT ont perdu face à un système d'intelligence artificielle conçu spécifiquement pour les échecs, Stockfish, confirmant ainsi la distance qui sépare les modèles généraux des systèmes spécialisés.