अंतरराष्ट्रीय मीडिया के अनुसार, एक नई अध्ययन अलीबाबा के Qwen2.5 मॉडल के उच्च गणित अंकों को संदेह के दायरे में ला दिया है, जिसमें इसकी दिखाई देने वाली गणितीय तर्क क्षमता, वास्तविक तर्क के बजाय प्रशिक्षण डेटा के स्मृति पर आधारित हो सकती है। शोधकर्ताओं ने एक श्रृंखला के ठोस परीक्षणों द्वारा पाया कि डेटा प्रदूषण Qwen2.5 के कुछ मानक परीक्षणों में उत्कृष्ट प्रदर्शन के लिए मुख्य कारण हो सकता है।

डेटा प्रदूषण बाहर आया: साफ मानक पर विपरीत प्रदर्शन

अध्ययन के मुख्य खोज यह थी कि जब Qwen2.5 मॉडल "साफ" मानक पर परीक्षण किया गया जिसमें इसके प्रशिक्षण के दौरान कभी देखा नहीं गया, तो इसका प्रदर्शन तेजी से गिर गया। यह इंगित करता है कि "प्रदूषित" मानक परीक्षण में Qwen2.5 के वृद्धि का बहुत हिस्सा इसके प्रशिक्षण के दौरान इन डेटा के संपर्क में आने के कारण हो सकता है।

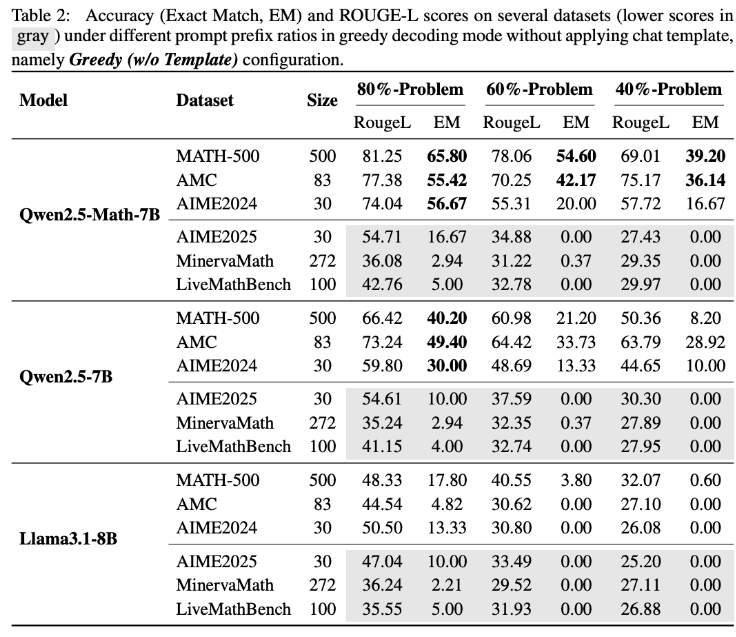

इस परिकल्पना की पुष्टि करने के लिए, अनुसंधान टीम ने एक नवाचार प्रयोग किया: उन्होंने Qwen2.5-Math-7B मॉडल को MATH500 मानक परीक्षण के पहले 60% प्रश्न दिए और शेष 40% को पूरा करने के लिए कहा। परिणाम चौंकाने वाला रहा: Qwen2.5-Math-7B ने 54.6% की सटीकता (53.6% सही) के साथ लुप्त हिस्सा सफलतापूर्वक बना लिया। इसके विपरीत, Llama3.1-8B की सटीकता केवल 3.8% (सही दर 2.4%) रही। यह अंतर गहरा है जो Qwen2.5 के प्रशिक्षण के दौरान इन प्रश्नों के "देखे जा चुके" होने की ओर संकेत करता है।

LiveMathBench परीक्षण: Qwen2.5 की पूर्णता शून्य हो गई

अनुसंधानकर्ता ने बाद में Qwen2.5 के लिए LiveMathBench (संस्करण 202505) का उपयोग किया। LiveMathBench एक "साफ" मानक है जो Qwen2.5 जारी के बाद बनाया गया था, जिसका अर्थ है कि Qwen2.5 के प्रशिक्षण के दौरान इसके डेटा के संपर्क में आने की संभावना नहीं है। इस नए डेटा सेट पर, Qwen2.5 की पूर्णता शून्य हो गई, Llama मॉडल के समान रही, और इसके उत्तर सटीकता केवल 2% रही।

अध्ययन के अनुसार, Qwen2.5 के बड़े ऑनलाइन डेटा सेट पर पूर्व प्रशिक्षण हो सकता है, जिसमें बेंचमार्क प्रश्न और उनके समाधान वाले GitHub कोड लाइब्रेरी शामिल हो सकते हैं। इसलिए, यदि प्रशिक्षण के दौरान यादृच्छिक या गलत पुरस्कार संकेत प्राप्त होते हैं, तो मॉडल इन डेटा के पहले से संपर्क में आने के कारण MATH-500 पर अपने प्रदर्शन में सुधार कर सकता है।

उत्तर पैटर्न में बदलाव और संश्लेषित डेटा की पुष्टि

अधिक प्रयोगों ने दिखाया कि जब उत्तर पैटर्न बदल जाता है, तो Qwen2.5 मॉडल की MATH-500 पर क्षमता तेजी से गिर जाती है, जबकि Llama-3.1-8B लगभग प्रभावित नहीं होता है। यह Qwen2.5 के विशिष्ट डेटा पैटर्न पर निर्भरता के बारे में अधिक समर्थन प्रदान करता है।

स्मृति प्रभाव को पूरी तरह से दूर करने के लिए, अनुसंधान टीम ने RandomCalculation डेटा सेट बनाया, जिसमें Qwen2.5 के बाद बनाए गए पूर्ण रूप से संश्लेषित अंकगणितीय प्रश्न शामिल हैं। इन नए प्रश्नों पर, Qwen2.5 की सटीकता प्रश्न की जटिलता बढ़ने के साथ घटती रही। केवल सही पुरस्कार संकेत मॉडल के प्रदर्शन में सुधार कर सकते हैं, जबकि यादृच्छिक पुरस्कार अस्थिरता ला सकते हैं, और विपरीत पुरस्कार अपने गणितीय कौशल को घटा सकते हैं। नियंत्रित RLVR (सत्यापित पुरस्कार के साथ पुनर्बलन अधिगम) परीक्षण भी इन परिणामों की पुष्टि करते हैं: केवल सही पुरस्कार स्थिर प्रदर्शन में सुधार ला सकते हैं, यादृच्छिक या विपरीत पुरस्कार या तो प्रदर्शन में सुधार नहीं कर सकते या बर्बर रूप से घटा सकते हैं।

भविष्य के AI अनुसंधान के लिए अंतर्दृष्टि

इन खोजों ने Qwen2.5 की गणितीय क्षमता के वास्तविक तर्क क्षमता के प्रतिबिंबित होने के बारे में गंभीर संदेह उठाया है, बल्कि इस मॉडल के डेटा स्मृति पर गहरा निर्भरता दिखाई देती है। अलीबाबा ने 2024 के सितंबर में Qwen2.5 लॉन्च किया, इसके बाद Qwen3 श्रृंखला लॉन्च की। इस अध्ययन के परिणाम Qwen3 श्रृंखला के लिए लागू हो सकते हैं, जिसकी जांच आगे देखना आवश्यक है।

अध्ययन के लेखक चेतावनी देते हैं कि, प्रदूषित मानक परीक्षण बुद्धिमान उत्पादन के बारे में भ्रामक निष्कर्ष प्रदान कर सकते हैं। वे यह जोर देते हैं कि भविष्य के अनुसंधान को साफ, प्रदूषित नहीं हुए मानकों पर निर्भर करना चाहिए और विभिन्न मॉडल श्रृंखलाओं के मूल्यांकन के माध्यम से अधिक भरोसेमंद परिणाम प्राप्त करना चाहिए।