最近、小米社が開発したMiMo-VLマルチモーダルモデルは、MiMo-7Bの後を引き継ぎ、複数の分野で強力なパフォーマンスを発揮しています。このモデルは画像、ビデオ、言語に関する汎用的な質問応答や理解推論などの多くのタスクにおいて、同じサイズの基準となるマルチモーダルモデルQwen2.5-VL-7Bを大きく上回り、GUI接地(Grounding)タスクでのパフォーマンスは専用モデルと互角以上に達しており、エージェント時代の到来に備えています。

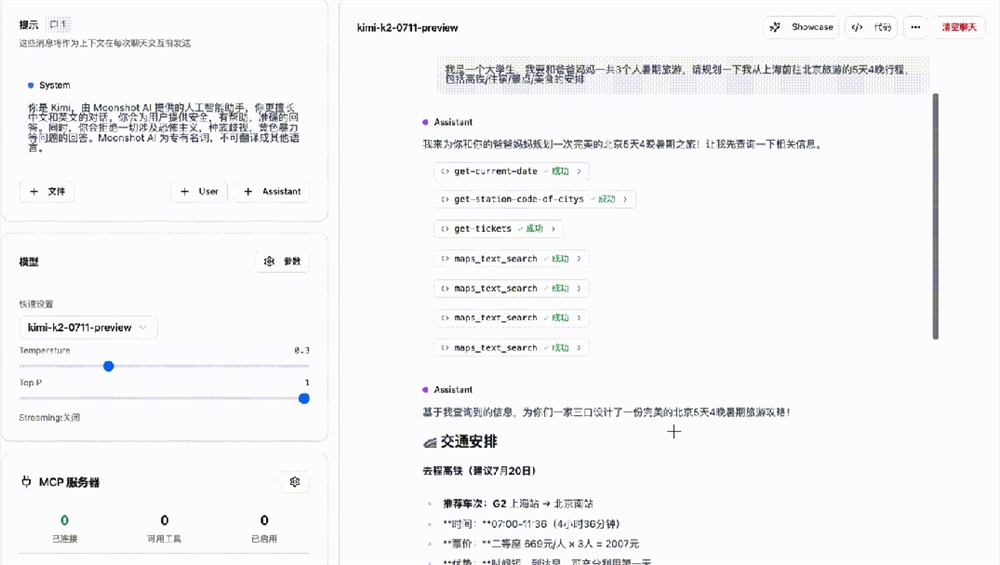

MiMo-VL-7Bはマルチモーダル推論タスクにおいて輝かしい成果を収めていますが、パラメータ規模はわずか7Bながら、オリンピック競技ベンチマーク(OlympiadBench)や数学競技(MathVision、MathVerse)などの複数の競技において、パラメータ規模が10倍大きいアリのQwen-2.5-VL-72BやQVQ-72B-Previewを大きく上回り、クローズドソースモデルのGPT-4oをも超えています。内部の大規模モデル競技場評価では、リアルユーザー体験においてもGPT-4oを上回り、オープンソースモデルの中で特に優れた存在となっています。実際の応用では、複雑な画像推論や質問応答において卓越したパフォーマンスを示し、10以上のステップにわたるGUI操作でも良い結果を示し、ユーザーがXiaomi SU7を心願リストに追加する手助けをすることさえ可能です。

MiMo-VL-7Bの包括的な視覚認識能力は、高品質な事前学習データと革新的なハイブリッドオンライン強化学習アルゴリズム(MORL)のおかげです。多段階の事前学習プロセスでは、小米は画像-テキストペア、ビデオ-テキストペア、GUI操作シーケンスなど、さまざまなデータタイプを含む高品質な事前学習マルチモーダルデータを収集・クリーンアップ・合成し、総計2.4兆トークンに達しました。そして、異なる種類のデータの割合を段階的に調整することで、長距離マルチモーダル推論能力を強化しました。ハイブリッドオンライン強化学習は、テキスト推論、マルチモーダル感覚+推論、RLHFなどのフィードバック信号を統合し、オンライン強化学習アルゴリズムを使用して訓練を安定かつ効率的に加速し、モデルの推論、感覚性能およびユーザーエクスペリエンスを全面提升しました。

関連リンク: https://huggingface.co/XiaomiMiMo