ハニワン-A13B は、テンセントが最新にオープンソースした大規模言語モデルであり、革新的な設計理念を採用し、比較的少ないアクティブパラメータ数で優れた性能を発揮しています。特にリソース制限のある環境においては非常に適しています。

このモデルは細粒度モード(Mixture-of-Experts)アーキテクチャを採用しており、130億のアクティブパラメータを持ちながら、総パラメータ数は800億にも達しています。この設計により、効率性と拡張性を保ちながら、最先端の推論能力と汎用的なアプリケーションのサポートを提供しています。

Hunyuan-A13B の主な機能の特徴は以下の通りです:

高速・低速思考の混合推論モード: この独自の推論メカニズムにより、タスクの要件に応じて思考の深さを柔軟に調整でき、複雑な問題の処理効率を向上させます。

256Kの超長文脈理解能力: この能力により、極めて長いテキスト入力が処理可能となり、大量の背景情報が必要なタスクでも優れた性能を発揮します。

エージェント関連タスクでの優れた性能: Hunyuan-A13B は、さまざまなエージェント(Agent)関連タスクの実行において強力な能力を示しています。

効率的な推論を実現するために、Hunyuan-A13B は Grouped Query Attention(GQA) 技術を採用し、多様な量子化形式をサポートしています。現在、このモデルはプリトレーニング、インストラクション微調整、FP8およびINT4量子化バージョンがオープンソースされており、開発者が使用しやすくなっています。

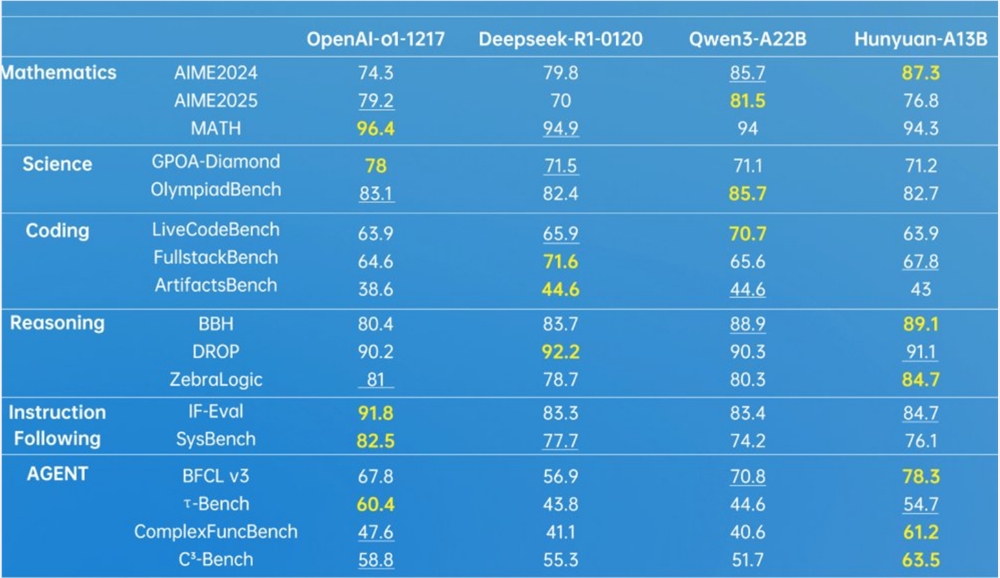

多くのベンチマークテストにおいて、Hunyuan-A13B は強力な競争力を示しており、特に数学、科学、コード作成、推論、エージェント分野で顕著です。

テンセントは開発者に対して包括的なサポートを提供しており、Hugging Face Transformers を使用して対話やモデルトレーニングを行うための詳細なガイドが用意されています。また、モデルのデプロイには、TensorRT-LLM、vLLM、SGLang のサポートも提供されており、事前に構築されたDockerイメージと量子化モデルのデプロイ方案によって、デプロイプロセスが大幅に簡略化されています。

Hunyuan-A13B のオープンソースは、リソース制限がある環境における大規模モデルの応用の新たな可能性を開拓し、AIコミュニティにも新たな革新の動力となっています。

オープンソースの場所: https://huggingface.co/tencent/Hunyuan-A13B-Instruct

github: https://github.com/Tencent-Hunyuan/Hunyuan-A13B?tab=readme-ov-file