アリババの自然言語処理チームは、WebWatcherを発表しました。これは、現存する閉鎖型システムやオープンソースエージェントが多モーダル深層研究分野で抱えている限界を突破することを目的としたオープンソースの多モーダルなディープ研究インテリジェントエージェントです。WebWatcherは、ウェブブラウジング、画像検索、コードインタプリター、内部OCRなどの多様なツールを統合しており、人間の研究者のように複雑な多モーダルタスクを処理でき、強力な視覚理解、論理的推論、知識の呼び出し、ツールのスケジューリング、自己検証能力を備えています。

WebWatcherを開発したチームは、現時点で存在する閉鎖型システムであるOpenAIのDeepResearchがテキストの深層研究において優れた性能を示しているものの、多くは純粋なテキスト環境に制限されており、現実世界における複雑な画像、グラフ、混合コンテンツの処理には苦労していると指摘しています。また、既存のオープンソースエージェントにも2つの大きな課題があります。一つはテキスト検索に特化したエージェントで、情報の統合はできますが、画像の処理はできません。もう一つは視覚エージェントで、画像の識別はできるものの、跨モーダル推論や多ツール協働能力に欠けています。WebWatcherはこれらの課題を解決するために設計されました。

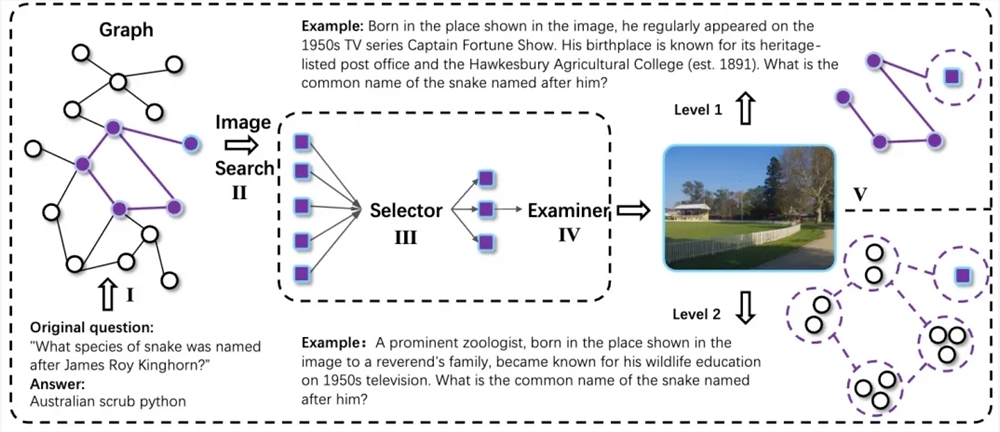

WebWatcherの技術的解決策は、データ構築からトレーニング最適化に至るまで一貫したプロセスをカバーしています。その核心的な目的は、高難度の多モーダル深層研究タスクにおいて、多モーダルエージェントが柔軟な推論と多ツール協働能力を持つことにあるのです。そのため、研究チームは自動で多モーダルデータ生成を行うプロセスを設計し、ランダムウォークにより跨モーダル知識チェーンを収集し、情報の曖昧化技術を導入して、タスクの不確実性と複雑性を向上させました。すべての複雑な問題のサンプルはQA-to-VQA変換モジュールを通じて多モーダルバージョンに拡張され、モデルの跨モーダル理解能力がさらに強化されました。

高品質な推論トラッキング構築と後期訓練に関して、WebWatcherはAction-Observation駆動型のトラッキング生成方法を採用しています。リアルな多ツール相互作用のトラッキングを収集し、监督微調整(SFT)によってトレーニング初期段階で多モーダルReAct形式の推論およびツール呼び出しの基本的なパターンを迅速に習得させます。その後、モデルは強化学習の段階に入り、GRPOを用いて多モーダルエージェントの複雑な環境下での意思決定能力をさらに向上させます。

WebWatcherの能力を全面的に検証するために、研究チームはBrowseComp-VLを提案しました。これは、BrowseCompを視覚・言語タスクに拡張したバージョンであり、人間の専門家レベルの跨モーダル研究タスクの難易度に近づけることを目的としています。複数ラウンドの厳格な評価において、WebWatcherは複雑な推論、情報検索、知識統合、および集約型情報最適化などのタスクにおいて、現在主流のオープンソースおよび閉鎖型多モーダル大規模モデルを全面的に上回っています。

具体的には、人間の最終試験(Humanity’s Last Exam、HLE-VL)という複数ステップの複雑な推論ベンチマークでは、WebWatcherは13.6%のPass@1スコアで首位を獲得し、GPT-4o(9.8%)、Gemini2.5-flash(9.2%)、Qwen2.5-VL-72B(8.6%)などの代表的なモデルを大幅に上回りました。より現実的な多モーダル検索に近いMMSearchの評価では、WebWatcherのPass@1スコアは55.3%に達し、Gemini2.5-flash(43.9%)やGPT-4o(24.1%)よりも大きく優れています。LiveVQAの評価では、WebWatcherのPass@1スコアは58.7%で、他の主要なモデルを上回りました。最も総合的な挑戦的なBrowseComp-VLベンチマークでは、WebWatcherは平均スコア(Pass@1)で27.0%を記録し、他社モデルを遥かに凌駕し、成績が倍以上向上しました。

リポジトリ: https://github.com/Alibaba-NLP/WebAgent