Um novo plataforma aberta chamada SciArena está agora disponível, visando avaliar o desempenho de modelos de linguagem grandes (LLM) em tarefas relacionadas a literatura científica por meio de preferências humanas. Os resultados iniciais já revelaram diferenças significativas no desempenho entre os diferentes modelos.

O SciArena foi desenvolvido conjuntamente por pesquisadores da Universidade de Yale, da Universidade de Nova York e do Instituto Allen de Inteligência Artificial, com o objetivo de avaliar sistematicamente a eficácia de LLMs proprietários e de código aberto no processamento de tarefas de literatura científica, preenchendo assim uma lacuna na avaliação sistemática nessa área.

Diferente dos benchmarks tradicionais, o SciArena se inspira no método do Chatbot Arena, contando com pesquisadores reais para a avaliação. Após os usuários submeterem perguntas científicas, recebem duas respostas longas geradas pelos modelos e com citações, e em seguida decidem qual resposta é melhor. As referências são obtidas por meio de um processo personalizado de recuperação ScholarQA.

A plataforma já coletou mais de 13.000 avaliações de 102 pesquisadores das áreas de ciências naturais, engenharia, ciências da vida e ciências sociais. As perguntas abrangem diversos aspectos, como explicações conceituais e recuperação de literatura.

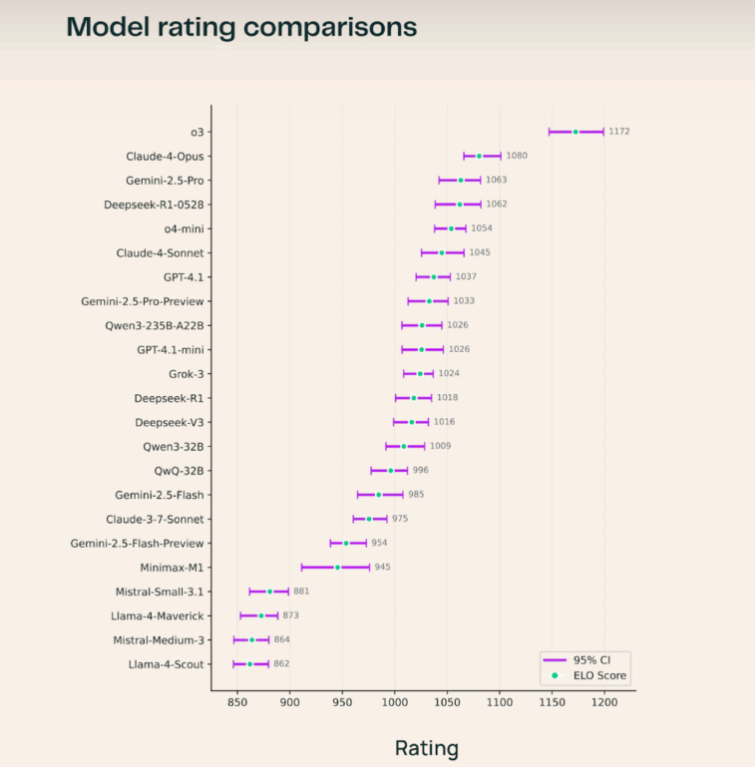

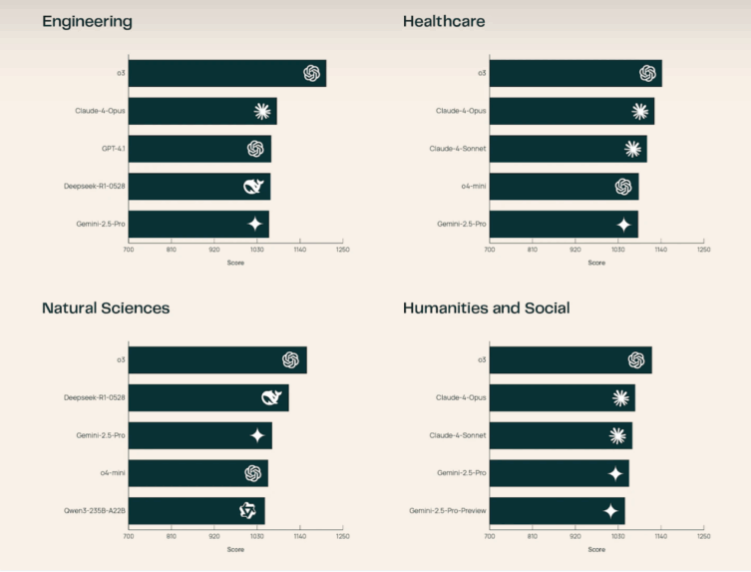

No ranking atual, o modelo o3 da OpenAI ocupa o primeiro lugar, liderando sobre Claude-4-Opus e Gemini-2.5-Pro. Entre os modelos de código aberto, o Deepseek-R1-0528 se destacou, com desempenho que superou até mesmo vários sistemas proprietários. O grupo de pesquisa observou que o o3 se saiu particularmente bem nas áreas de ciências naturais e engenharia. Os pesquisadores também descobriram que os usuários valorizam mais a correspondência correta das citações com as afirmações, em vez de apenas a quantidade de citações. Fatores como o comprimento das respostas têm menos impacto no SciArena do que em plataformas como o Chatbot Arena ou Search Arena.

Apesar desses avanços, a avaliação automatizada ainda representa um desafio. A equipe também lançou um novo benchmark chamado SciArena-Eval, para testar a capacidade dos modelos de linguagem de julgar as respostas de outros modelos. No entanto, mesmo os melhores modelos concordam com as preferências humanas cerca de 65% do tempo, destacando as limitações atuais dos sistemas LLM-as-a-Judge na área científica.

O SciArena está disponível ao público, com seu código, dados e o benchmark SciArena-Eval fornecidos sob licença aberta. O objetivo da plataforma é apoiar o desenvolvimento de modelos mais alinhados às necessidades humanas nas tarefas de informação científica. No futuro, o SciArena planeja adicionar funcionalidades para avaliar sistemas de pesquisa baseados em agentes.