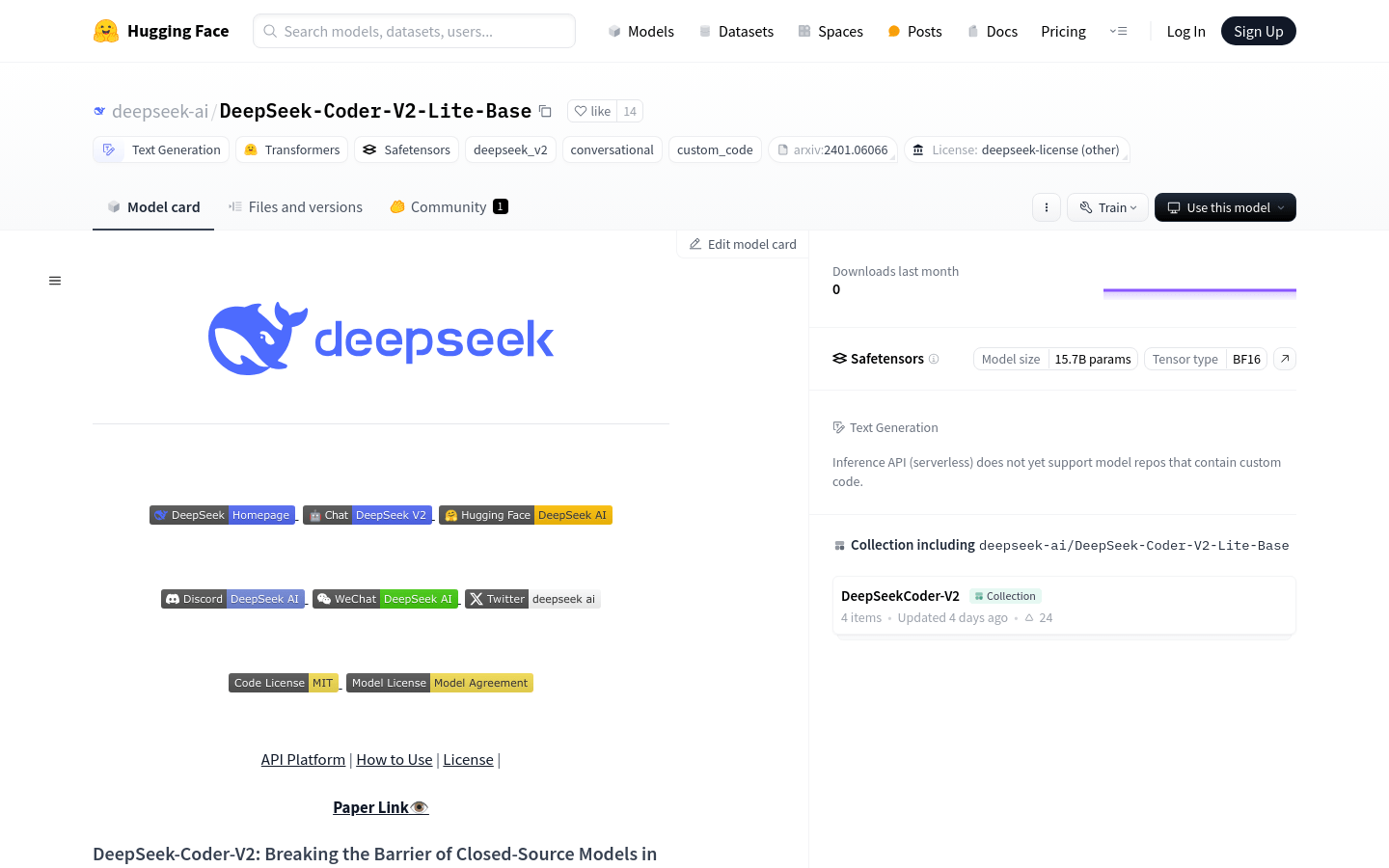

DeepSeek-Coder-V2-Lite-Base

Modelo de lenguaje de código abierto que mejora la capacidad de programación y razonamiento matemático.

DeepSeek-Coder-V2-Lite-Base Situación del tráfico más reciente

Total de visitas mensuales

25633376

Tasa de rebote

44.05%

Páginas promedio por visita

5.8

Duración promedio de la visita

00:04:53