Le modèle d'IA open source Reflection70B, récemment lancé, a fait l'objet de nombreuses critiques de la part du secteur.

Ce modèle, publié par la start-up new-yorkaise HyperWrite, se présente comme une variante du Llama3.1 de Meta et avait suscité l'intérêt grâce à ses excellentes performances lors de tests tiers. Cependant, la réputation de Reflection70B a commencé à être remise en question suite à la publication de certains résultats de tests.

Tout a commencé le 6 septembre lorsque Matt Shumer, co-fondateur et PDG d'HyperWrite, a annoncé Reflection70B sur le réseau social X, le qualifiant avec assurance de « modèle open source le plus puissant au monde ».

Shumer a également présenté la technique d'« optimisation par réflexion » du modèle, affirmant que cette méthode permettait au modèle de s'auto-contrôler avant de générer du contenu, améliorant ainsi sa précision.

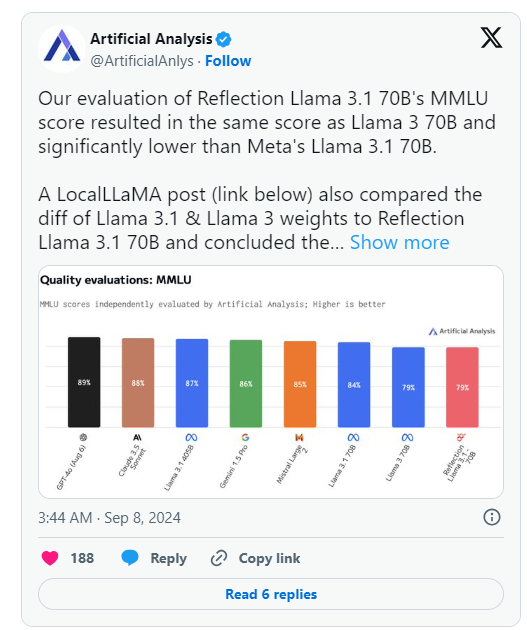

Cependant, le lendemain de l'annonce d'HyperWrite, l'organisation Artificial Analysis, spécialisée dans « l'analyse indépendante des modèles d'IA et des fournisseurs d'hébergement », a publié sa propre analyse sur X, indiquant que le score MMLU (Massive Multitask Language Understanding) du Reflection Llama3.1 70B qu'ils ont évalué était identique à celui du Llama3 70B, mais nettement inférieur à celui du Llama3.1 70B de Meta. Ceci représente une différence significative par rapport aux résultats initialement publiés par HyperWrite/Shumer.

Shumer a ensuite déclaré que les poids de Reflection70B (ou les paramètres du modèle open source) avaient rencontré des problèmes lors du téléchargement sur Hugging Face (un référentiel et une entreprise d'hébergement de code IA tiers), ce qui a probablement entraîné des performances inférieures à la version « API interne » d'HyperWrite.

Dans une déclaration ultérieure, Artificial Analysis a indiqué avoir eu accès à l'API privée et constaté des performances impressionnantes, mais sans atteindre le niveau initialement annoncé. Comme ce test a été effectué sur une API privée, ils n'ont pas pu vérifier indépendamment le contenu testé.

L'organisation a soulevé deux questions clés qui remettent sérieusement en question les déclarations de performance initiales d'HyperWrite et de Shumer :

- Pourquoi la version publiée n'est-elle pas celle testée via l'API privée Reflection ?

- Pourquoi les poids du modèle de la version testée n'ont-ils pas encore été publiés ?

Parallèlement, de nombreux utilisateurs des communautés d'apprentissage automatique et d'IA sur Reddit ont également remis en question les performances déclarées et l'origine de Reflection70B. Certains ont souligné que, selon les comparaisons de modèles publiées sur Github par des tiers, Reflection70B semble être une variante de Llama3, et non de Llama-3.1, ce qui suscite de nouveaux doutes sur les déclarations initiales de Shumer et d'HyperWrite.

Ceci a conduit au moins un utilisateur X, Shin Megami Boson, à accuser publiquement Shumer de « fraude » au sein de la communauté de recherche sur l'IA le 8 septembre à 20h07, heure de l'Est, en publiant une longue série de captures d'écran et d'autres preuves.

D'autres ont accusé le modèle d'être en réalité un « paquetage » ou une application construite sur Claude3 d'Anthropic, un concurrent propriétaire/à code source fermé.

Cependant, d'autres utilisateurs de X ont pris la défense de Shumer et de Reflection70B, certains publiant également des résultats impressionnants obtenus avec le modèle de leur côté.

Actuellement, la communauté de recherche sur l'IA attend la réponse de Shumer aux accusations de fraude et la mise à jour des poids du modèle sur Hugging Face.

🚀 Le modèle Reflection70B, après sa sortie, a vu ses performances remises en question, les résultats des tests n'ayant pas reproduit les performances initialement annoncées.

⚙️ Le fondateur d'HyperWrite explique que des problèmes de téléchargement du modèle ont entraîné une baisse des performances et appelle à se concentrer sur la version mise à jour.

👥 Les discussions sur ce modèle sont animées sur les réseaux sociaux, entre accusations et défenses, la situation est complexe.