Dans le domaine de l'intelligence artificielle, une technologie révolutionnaire est en train d'émerger. Inception Labs a récemment annoncé le lancement de Mercury, une série de grands modèles linguistiques de diffusion (dLLM), une nouvelle génération de modèles linguistiques conçus pour générer du texte de haute qualité de manière rapide et efficace. Comparés aux grands modèles linguistiques autorégressifs traditionnels, les modèles Mercury sont jusqu'à 10 fois plus rapides, atteignant une vitesse de plus de 1000 jetons par seconde sur une carte graphique NVIDIA H100, une vitesse auparavant uniquement réalisable avec des puces personnalisées.

Le premier produit de la série Mercury, Mercury Coder, a déjà fait son apparition lors de tests publics. Ce modèle, spécialisé dans la génération de code, a démontré des performances exceptionnelles, surpassant de nombreux modèles d'optimisation de vitesse existants dans plusieurs tests de référence, tels que GPT-4o Mini et Claude3.5Haiku, tout en étant près de 10 fois plus rapide. Selon les retours des développeurs, les résultats de complétion de code de Mercury sont plus appréciés. Dans les tests de Copilot Arena, Mercury Coder Mini s'est classé parmi les meilleurs et s'est avéré être l'un des modèles les plus rapides.

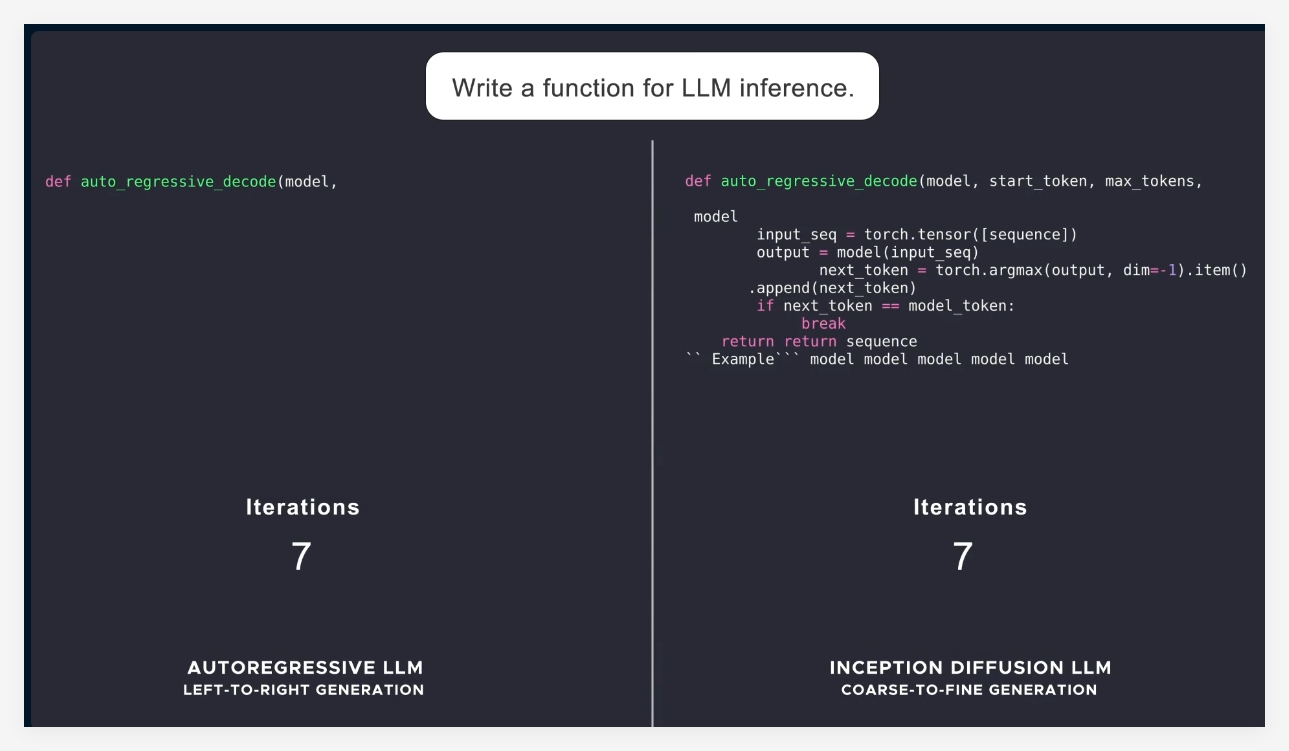

La plupart des modèles linguistiques actuels utilisent une approche autorégressive, générant les jetons un par un de gauche à droite, ce qui rend le processus de génération inévitablement séquentiel, avec des coûts de calcul et de latence élevés. Mercury, quant à lui, adopte une approche de génération « du grossier au fin », partant d'un bruit pur et affinant progressivement la sortie par plusieurs étapes de « dénormalisation ». Cela permet aux modèles Mercury de traiter plusieurs jetons en parallèle pendant la génération, améliorant ainsi les capacités d'inférence et de réponse structurée.

Avec le lancement de la série Mercury, Inception Labs démontre l'énorme potentiel des modèles de diffusion dans les domaines de la génération de texte et de code. L'entreprise prévoit ensuite de lancer des modèles linguistiques adaptés aux applications de chat, élargissant ainsi le champ d'application des modèles linguistiques de diffusion. Ces nouveaux modèles offriront des capacités d'agents intelligents plus puissantes, capables de réaliser des planifications complexes et des générations de longue durée. De plus, leur efficacité leur permet de fonctionner correctement même sur des appareils aux ressources limitées, tels que les smartphones et les ordinateurs portables.

En résumé, le lancement de Mercury marque une avancée importante dans la technologie de l'intelligence artificielle, non seulement en termes d'augmentation significative de la vitesse et de l'efficacité, mais aussi en fournissant à l'industrie des solutions de meilleure qualité.

Présentation officielle : https://www.inceptionlabs.ai/news

Essai en ligne : https://chat.inceptionlabs.ai/

Points clés :

🌟 Lancement de la série de grands modèles linguistiques de diffusion Mercury (dLLM), avec une vitesse de génération augmentée à 1000 jetons par seconde.

🚀 Mercury Coder, spécialisé dans la génération de code, excelle dans les tests de référence et surpasse de nombreux modèles existants.

💡 L'approche innovante des modèles de diffusion rend la génération de texte plus efficace et précise, ouvrant de nouvelles possibilités pour les applications d'agents intelligents.