Hunyuan-A13B est un nouveau modèle de langage à grande échelle ouvert par Tencent, qui se distingue par une conception innovante. Il offre des performances puissantes malgré une taille relativement petite de paramètres actifs, et est particulièrement adapté aux environnements à ressources limitées.

Ce modèle utilise une architecture MoE (Mélange d'Experts) à granularité fine, avec 13 milliards de paramètres actifs, mais un nombre total de paramètres atteignant 800 milliards. Cette conception lui permet de maintenir une efficacité et une évolutivité élevées tout en offrant des capacités de raisonnement avancées et un soutien pour les applications générales.

Les points forts principaux du Hunyuan-A13B incluent :

Mode de raisonnement hybride supportant la pensée rapide et lente : Ce mécanisme de raisonnement unique permet au modèle d'ajuster flexiblement le degré de réflexion selon les besoins de la tâche, améliorant ainsi l'efficacité de traitement des problèmes complexes.

Capacité native d'analyse de contexte extrêmement long (256K) : Cela signifie que le modèle peut traiter des textes très longs, ce qui le rend performant dans les tâches nécessitant beaucoup d'informations contextuelles.

Excellentes performances sur les tâches d'intelligence artificielle (Agent) : Le Hunyuan-A13B montre une capacité remarquable lors de l'exécution de diverses tâches liées aux agents (Agent).

Pour réaliser un raisonnement efficace, le Hunyuan-A13B utilise la technologie Grouped Query Attention (GQA) et prend en charge plusieurs formats de quantification. Actuellement, ce modèle dispose de versions pré-entraînées, ajustées par instruction, en FP8 et en INT4, facilitant ainsi l'utilisation par les développeurs.

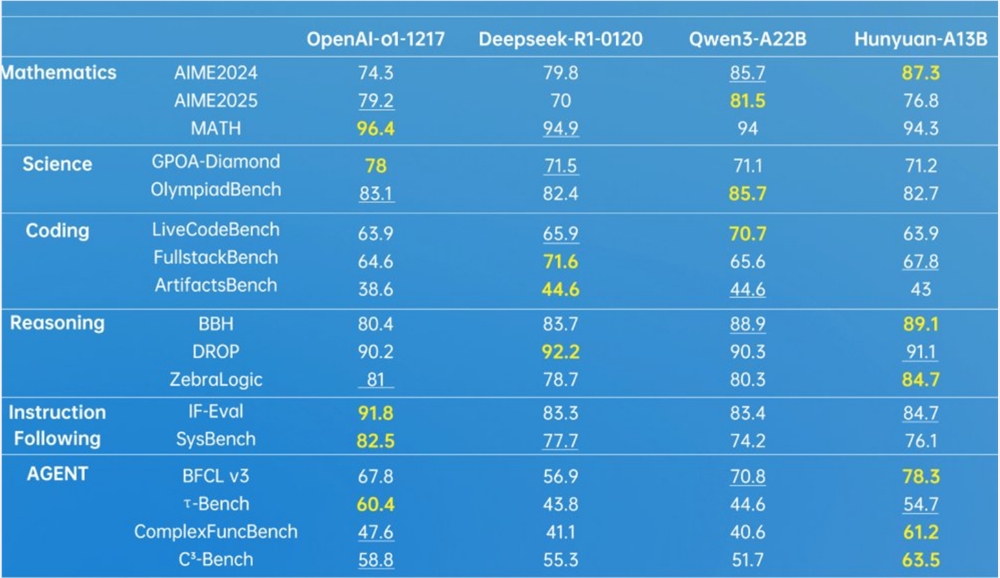

Dans plusieurs tests de référence, le Hunyuan-A13B a démontré une forte compétitivité, notamment dans les domaines des mathématiques, des sciences, de la programmation, du raisonnement et des agents.

Tencent propose un soutien complet aux développeurs, y compris des guides détaillés pour interagir et entraîner le modèle via Hugging Face Transformers. En outre, pour le déploiement du modèle, le Hunyuan-A13B prend en charge TensorRT-LLM, vLLM et SGLang, et fournit également des images Docker prêtes à l'emploi et des solutions de déploiement de modèles quantifiés, simplifiant ainsi grandement le processus de déploiement.

L'ouverture du Hunyuan-A13B représente clairement de nouvelles possibilités pour l'utilisation des grands modèles dans des environnements à ressources limitées, tout en apportant une nouvelle impulsion à l'innovation dans la communauté AI.

Adresse de l'open source : https://huggingface.co/tencent/Hunyuan-A13B-Instruct

github : https://github.com/Tencent-Hunyuan/Hunyuan-A13B?tab=readme-ov-file