Tencent a récemment annoncé le lancement en open source de son nouveau modèle linguistique «**Hunyuan-A13B**», qui intègre une méthode innovante d'inférence dynamique, lui permettant de basculer intelligemment entre une pensée rapide et approfondie selon la complexité de la tâche.

Points forts principaux : inférence dynamique et architecture MoE

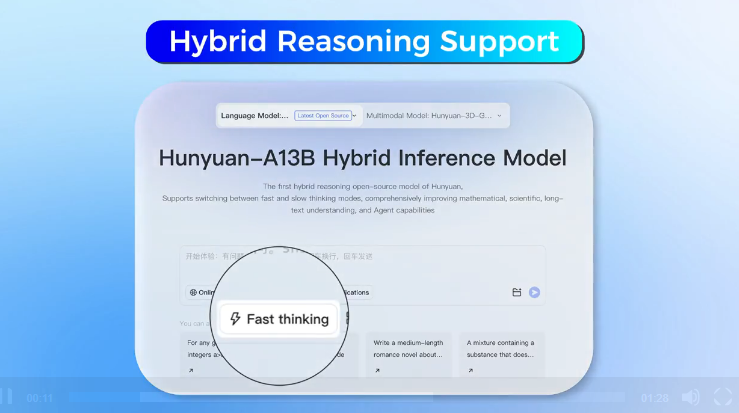

Le principal avantage de «Hunyuan-A13B» réside dans sa capacité à ajuster en temps réel la profondeur de l'inférence. Pour les requêtes simples, le modèle active le **mode rapide**, répondant rapidement avec un minimum d'étapes d'inférence ; tandis que pour les problèmes plus complexes, il peut activer un processus d'inférence approfondie nécessitant plusieurs étapes de réflexion. Les utilisateurs peuvent également contrôler manuellement ce comportement en utilisant des commandes spécifiques, comme «**/think**» pour activer le mode approfondi ou «**/no_think**» pour désactiver le mode approfondi.

Le modèle utilise une architecture **Mixture of Experts (MoE)**, avec un nombre total de paramètres atteignant **80 milliards**, mais seulement **13 milliards de paramètres** sont actifs pendant l'inférence réelle, ce qui améliore l'efficacité du fonctionnement. De plus, «Hunyuan-A13B» prend en charge une fenêtre contextuelle pouvant aller jusqu'à **256 000 balises**, ce qui améliore considérablement sa capacité à traiter des textes longs.

Données d'entraînement et performances

Selon le rapport technique publié par Tencent, «Hunyuan-A13B» a été entraîné sur **20 billions de tokens** et optimisé pour les tâches d'inférence ainsi que pour un éventail plus large d'applications. Pour améliorer la fiabilité du modèle dans les tâches scientifiques, Tencent a collecté spécifiquement **250 milliards de tokens** provenant du domaine STEM (Sciences, Technologies, Ingénierie, Mathématiques) pour l'entraînement. Ces données comprennent des manuels scolaires, des examens, du code open source sur GitHub, des énigmes logiques et des textes scientifiques allant jusqu'au niveau universitaire.

Tencent affirme que sa version «**Hunyuan-A13B-Instruct**» est comparable aux modèles leaders tels qu'OpenAI, Deepseek et Alibaba Qwen. Le rapport indique que, lors du concours américain de mathématiques AIME en 2024, le taux de précision de «Hunyuan-A13B» a atteint **87,3 %**, surpassant le 74,3 % d'OpenAI o1.