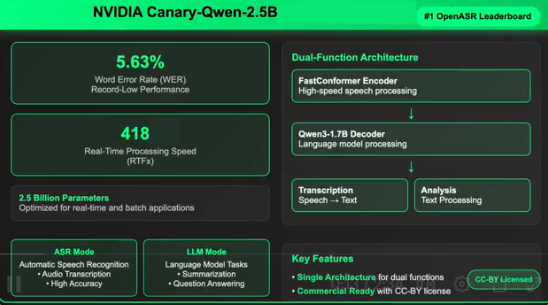

NVIDIA vient de lancer Canary-Qwen-2.5B, un modèle hybride révolutionnaire d'identification automatique de la parole (ASR) et de modèle de langage (LLM), qui se classe en tête du classement Hugging Face OpenASR avec un taux d'erreur de mot (WER) record de 5,63 %. Ce modèle est publié sous licence CC-BY, offrant une licence commerciale et des caractéristiques open source, ce qui élimine les obstacles à l'essor de l'intelligence artificielle vocale pour les entreprises.

Avancées technologiques : Une compréhension unifiée de la parole et du traitement du langage

Cette publication marque un important jalon technologique, puisque Canary-Qwen-2.5B intègre la transcription et la compréhension du langage dans une seule architecture de modèle, permettant d'exécuter directement des tâches comme la synthèse ou les questions-réponses à partir d'un audio. Cette architecture innovante change radicalement le processus traditionnel d'ASR, intégrant la transcription et le post-traitement en un seul workflow.

Indicateurs de performance clés

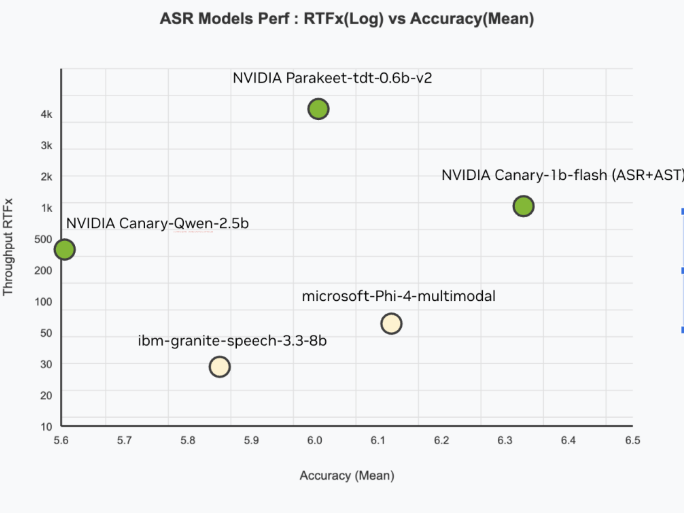

Ce modèle bat des records sur plusieurs dimensions :

- Précision : 5,63 % de WER, le plus bas du classement Hugging Face OpenASR

- Vitesse : RTFx de 418, traitant l'audio 418 fois plus vite qu'en temps réel

- Efficacité : Seulement 2,5 milliards de paramètres, plus compact que les grands modèles performants

- Taille de formation : Basé sur un ensemble de données audio anglais diversifié de 234 000 heures

Conception innovante d'une architecture hybride

L'innovation centrale de Canary-Qwen-2.5B réside dans son architecture hybride, comprenant deux composants clés :

Le encodeur FastConformer est spécialement conçu pour une transcription à faible latence et haute précision, tandis que le décodeur LLM Qwen3-1.7B est un grand modèle de langage préentraîné sans modification, recevant les balises de transcription audio via un adaptateur.

Cette conception d'adaptateur assure une modularité, permettant à l'encodeur Canary de s'extraire et à Qwen3-1.7B d'être exécuté comme un LLM indépendant pour les tâches basées sur le texte. Un déploiement unique permet de traiter les tâches linguistiques descendantes pour les entrées orales et écrites, améliorant ainsi la flexibilité multimodale.

Valeur d'application pour les entreprises

Avec une licence non commerciale contraignante, contrairement à de nombreux modèles de recherche, Canary-Qwen-2.5B est publié sous licence CC-BY, ouvrant ainsi des scénarios commerciaux larges :

- Services de transcription d'entreprise

- Extraction de connaissances à partir d'audio

- Résumés en temps réel de réunions

- Agents IA contrôlés par la voix

- Traitement de documents conformes aux réglementations (santé, droit, finance)

La fonction de décodage sensible au LLM de ce modèle améliore également la ponctuation, les majuscules et la précision contextuelle, souvent des points faibles des sorties ASR traditionnelles.

Compatibilité matérielle et flexibilité de déploiement

Canary-Qwen-2.5B est optimisé pour diverses cartes graphiques NVIDIA, supportant des matériels allant des A100 et H100 des centres de données, aux RTX PRO6000 des stations de travail, jusqu'aux GeForce RTX5090 de niveau consommateur. Cette extensibilité à travers les catégories matérielles le rend adapté aux charges de travail cloud et aux bords internes.

Open source et avancement de l'industrie

Avec l'ouverture de ce modèle et de ses schémas d'entraînement, l'équipe de recherche NVIDIA vise à promouvoir l'avancement de l'IA vocale pilotée par la communauté. Les développeurs peuvent combiner d'autres encodeurs compatibles NeMo et LLM pour créer des modèles hybrides spécifiques à certaines tâches ou langues.

Cette version ouvre également la voie à un ASR centré sur le LLM, où le LLM n'est plus un post-traitement, mais devient un agent central intégré au processus de conversion vocal-texte. Cette approche reflète une tendance plus large vers des modèles agents capables de comprendre et de prendre des décisions globales à partir d'entrées multimodales du monde réel.

Le Canary-Qwen-2.5B de NVIDIA n'est pas seulement un modèle ASR, mais aussi un plan d'action pour intégrer la compréhension de la parole avec un modèle de langage général. Grâce à sa performance de pointe, sa disponibilité commerciale et son itinéraire d'innovation ouvert, cette version devrait devenir un outil fondamental pour les entreprises, les développeurs et les chercheurs qui veulent déverrouiller les applications d'IA prioritaire vocale de prochaine génération.