Récemment, Nvidia a lancé un nouveau petit modèle linguistique Nemotron-Nano-9B-v2, qui s'est distingué dans plusieurs tests de référence et permet aux utilisateurs de contrôler facilement l'activation ou la désactivation de sa fonction de raisonnement. Le nombre de paramètres du Nemotron-Nano-9B-v2 est de 9 milliards, ce qui représente une réduction significative par rapport aux 12 milliards de paramètres de son prédécesseur, afin d'adapter le déploiement à une seule carte graphique Nvidia A10.

Oleksii Kuchiaev, directeur des modèles d'IA de Nvidia, a déclaré que ce modèle avait été spécifiquement optimisé pour la carte graphique A10, offrant une vitesse de traitement pouvant atteindre 6 fois plus rapide, et convient à divers scénarios d'application. Le Nemotron-Nano-9B-v2 prend en charge plusieurs langues, notamment l'anglais, l'allemand, l'espagnol, le français, l'italien, le japonais, ainsi que le coréen, le portugais, le russe et le chinois, et est adapté aux tâches de suivi d'instructions et de génération de code.

Ce modèle repose sur la série Nemotron-H, combinant les architectures Mamba et Transformer, permettant de réduire la consommation de mémoire et de calcul lors du traitement des séquences longues. Contrairement aux modèles traditionnels Transformer, les modèles Nemotron-H utilisent un modèle d'espace d'état à sélection (SSM), qui permet de traiter efficacement des séquences d'informations plus longues tout en maintenant une précision élevée.

Pour la fonction de raisonnement, le Nemotron-Nano-9B-v2 génère par défaut un journal de suivi du processus de raisonnement, et les utilisateurs peuvent activer ou désactiver cette fonction avec des instructions simples comme /think ou /no_think. De plus, le modèle intègre une gestion du « budget de pensée » pendant l'exécution, permettant aux développeurs de définir le nombre maximum de tokens utilisés pour le raisonnement, afin d'atteindre un équilibre entre précision et vitesse de réponse.

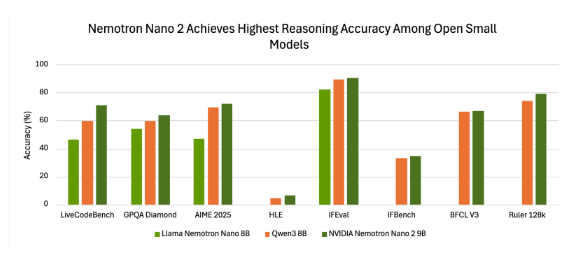

Dans les tests de benchmark, le Nemotron-Nano-9B-v2 a montré une bonne précision. Par exemple, en mode « Raisonnement activé » du package NeMo-Skills, le modèle a performé excellentement dans plusieurs tests, démontrant un avantage par rapport à d'autres modèles open source de petite taille.

Nvidia a publié le Nemotron-Nano-9B-v2 sous une licence de modèle open source, autorisant son utilisation commerciale, et les développeurs peuvent librement créer et distribuer des modèles dérivés. Il convient de noter que Nvidia ne revendique pas le droit d'auteur sur les sorties générées par le modèle, et les utilisateurs ont un contrôle complet sur son utilisation.

La publication de ce modèle vise à fournir aux développeurs des outils permettant d'équilibrer les capacités de raisonnement et l'efficacité de déploiement dans des environnements à petite échelle, marquant ainsi les efforts continus de Nvidia pour améliorer l'efficacité et les capacités de raisonnement contrôlable des modèles linguistiques.

huggingface:https://huggingface.co/nvidia/NVIDIA-Nemotron-Nano-9B-v2

Points clés :

🌟 Nvidia a lancé un nouveau petit modèle linguistique Nemotron-Nano-9B-v2, qui permet aux utilisateurs de contrôler facilement la fonction de raisonnement.

⚙️ Ce modèle repose sur une architecture hybride avancée, capable de traiter efficacement des informations longues, et convient aux tâches multilingues.

📊 Le Nemotron-Nano-9B-v2 est publié sous licence open source, permettant aux développeurs d'utiliser le modèle à des fins commerciales et de créer et de distribuer librement des modèles dérivés.