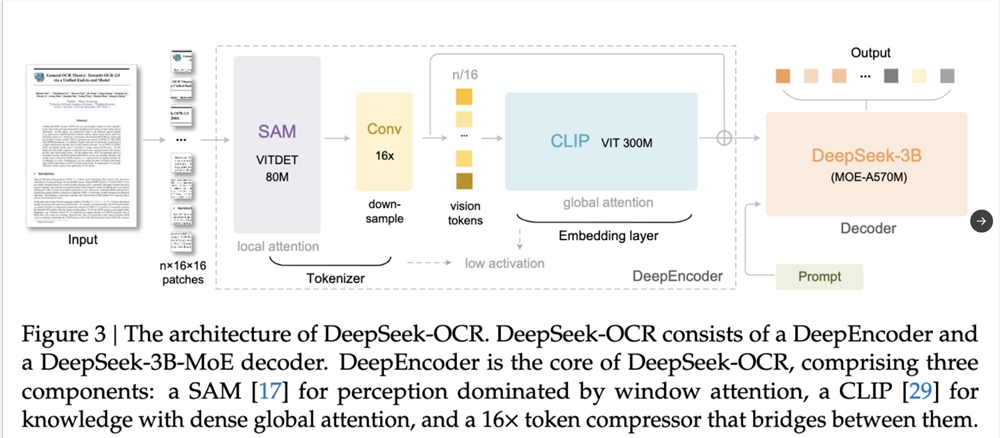

Récemment, DeepSeek a lancé un nouveau modèle de compréhension des documents OCR : DeepSeek-OCR. Ce modèle obtient des performances de premier ordre dans l'analyse des documents images, et introduit un concept audacieux et innovant : la mécanisme de compression de mémoire visuelle, qui vise à résoudre de manière révolutionnaire le problème de croissance exponentielle des ressources informatiques des modèles de langage à grande échelle (LLM) lors du traitement de très longs contextes.

Avancée principale : permettre à l'IA « lire des images » avec une compression efficace

L'innovation centrale de DeepSeek-OCR consiste à imiter le mécanisme de mémoire visuelle humaine, en compressant les informations textuelles longues dans un espace d'image, permettant ainsi une réduction significative des « tokens » consommés par le modèle de langage.

Explication simplifiée du fonctionnement :

Ce mécanisme fonctionne en « dessinant du texte en image » : tout d'abord, le texte long est compressé en une seule image ; ensuite, un modèle visuel compresse cette image en un minimum de « tokens visuels » (Visual Tokens) ; enfin, le modèle de langage décode ces tokens visuels pour retrouver le texte.

Ainsi, cette technologie permet au modèle de « lire par l'intermédiaire d'une image », plutôt que de lire mot par mot, améliorant ainsi considérablement l'efficacité du traitement de l'information.

Performance remarquable : compression 10 fois et potentiel futur

DeepSeek a démontré une performance de compression impressionnante : un article de 1 000 mots, après avoir été compressé en une image, nécessite uniquement 100 tokens visuels (soit une compression de 10 fois) pour être représenté. Lors de la décompression, le modèle peut encore récupérer 97 % du texte original.

Cette avancée majeure n'a pas seulement montré l'efficacité du « mécanisme de compression de mémoire visuelle », mais a également révélé son grand potentiel pour l'avenir du développement de l'intelligence artificielle :

Résoudre les limites de mémoire des LLM : Cette technologie pourrait devenir une solution clé pour contourner les contraintes de mémoire des grands modèles, permettant à l'IA de traiter des contextes extrêmement longs, comme des centaines de pages, avec moins de calculs.

Stockage de mémoire des futurs systèmes d'IA : Les anciennes mémoires pourraient être converties en images pour être stockées, permettant une archive d'informations plus efficace.

Analogie à la « courbe d'oubli » humaine : mémoire à haute fidélité et faible densité

DeepSeek compare ce mécanisme de compression visuelle à la « courbe d'oubli » humaine, reproduisant habilement le processus naturel de mémoire et d'oubli humain :

Mémoire à haute fidélité : Le contexte récent est conservé sous forme d'image à haute résolution, c'est-à-dire des informations à haute fidélité.

Mémoire à faible densité : Le contexte plus ancien est compressé en une image floue, c'est-à-dire des informations à faible densité.