Au cours de la nuit dernière, l'équipe d'Alibaba Tongyi Qianwen a publié la série de modèles open source Qwen2. Cette série comprend cinq modèles de pré-entraînement et d'ajustement d'instructions de différentes tailles : Qwen2-0.5B, Qwen2-1.5B, Qwen2-7B, Qwen2-57B-A14B et Qwen2-72B. Les informations clés montrent une amélioration significative du nombre de paramètres et des performances par rapport à la génération précédente, Qwen1.5.

Pour les capacités multilingues des modèles, la série Qwen2 a bénéficié d'un investissement important pour augmenter la quantité et la qualité des ensembles de données, couvrant 27 autres langues en plus de l'anglais et du chinois. Les tests comparatifs montrent que les grands modèles (70 B+ paramètres) excellent dans la compréhension du langage naturel, le codage et les capacités mathématiques. Le modèle Qwen2-72B surpasse même la génération précédente en termes de performances et de nombre de paramètres.

Le modèle Qwen2 a non seulement démontré de puissantes capacités dans l'évaluation des modèles linguistiques de base, mais a également obtenu des résultats remarquables dans l'évaluation des modèles ajustés aux instructions. Ses capacités multilingues se sont distinguées dans les tests de référence M-MMLU et MGSM, démontrant le fort potentiel des modèles Qwen2 ajustés aux instructions.

La publication de la série de modèles Qwen2 marque un nouveau sommet dans la technologie de l'intelligence artificielle, ouvrant des possibilités plus vastes pour les applications et la commercialisation de l'IA à l'échelle mondiale. À l'avenir, Qwen2 étendra davantage l'échelle des modèles et les capacités multimodales, accélérant ainsi le développement du domaine de l'IA open source.

Informations sur les modèles

La série Qwen2 comprend 5 modèles de base et d'ajustement d'instructions de différentes tailles : Qwen2-0.5B, Qwen2-1.5B, Qwen2-7B, Qwen2-57B-A14B et Qwen2-72B. Le tableau ci-dessous détaille les informations clés de chaque modèle :

| Modèle | Qwen2-0.5B | Qwen2-1.5B | Qwen2-7B | Qwen2-57B-A14B | Qwen2-72B |

|---|---|---|---|---|---|

| # Paramètres | 49 millions | 154 millions | 7,07 milliards | 57,41 milliards | 72,71 milliards |

| # Paramètres non Emb | 35 millions | 1,31 milliard | 598 millions | 56,32 milliards | 70,21 milliards |

| Liaison des embeddings | Vrai | Vrai | Faux | Faux | Faux |

| Longueur du contexte | 32 000 | 32 000 | 128 000 | 64 000 | 128 000 |

| Assurance Qualité | Oui | Oui | Oui | Oui | Oui |

Plus précisément, dans Qwen1.5, seuls Qwen1.5-32B et Qwen1.5-110B utilisaient Group Query Attention (GQA). Cette fois, nous avons appliqué GQA à toutes les tailles de modèles afin qu'ils bénéficient d'une vitesse d'inférence plus rapide et d'une consommation de mémoire réduite. Pour les petits modèles, nous préférons utiliser la liaison des embeddings car les grands embeddings clairsemés représentent une part importante du nombre total de paramètres du modèle.

Concernant la longueur du contexte, tous les modèles linguistiques de base ont été pré-entraînés sur des données avec une longueur de contexte de 32 000 jetons. Nous avons observé une capacité d'extrapolation satisfaisante jusqu'à 128 000 jetons dans l'évaluation PPL. Cependant, pour les modèles ajustés aux instructions, nous ne nous contentons pas de l'évaluation PPL ; nous avons besoin que les modèles comprennent correctement les longs contextes et accomplissent les tâches. Le tableau indique les capacités de longueur de contexte des modèles ajustés aux instructions, évaluées à l'aide de la tâche Needle in a Haystack. Il est à noter que, lorsqu'ils sont améliorés avec YARN, les modèles Qwen2-7B-Instruct et Qwen2-72B-Instruct montrent des capacités impressionnantes à gérer des longueurs de contexte jusqu'à 128 000 jetons.

Nous avons déployé des efforts considérables pour augmenter la quantité et la qualité des ensembles de données de pré-entraînement et d'ajustement des instructions, couvrant de nombreuses langues autres que l'anglais et le chinois, afin d'améliorer leurs capacités multilingues. Bien que les grands modèles linguistiques aient une capacité inhérente à se généraliser à d'autres langues, nous soulignons explicitement l'inclusion de 27 autres langues dans notre entraînement :

| Région | Langues |

|---|---|

| Europe occidentale | Allemand, français, espagnol, portugais, italien, néerlandais |

| Europe orientale et centrale | Russe, tchèque, polonais |

| Moyen-Orient | Arabe, persan, hébreu, turc |

| Asie de l'Est | Japonais, coréen |

| Asie du Sud-Est | Vietnamien, thaï, indonésien, malais, lao, birman, cebuano, khmer, tagalog |

| Asie du Sud | Hindi, bengali, ourdou |

De plus, nous avons consacré beaucoup d'efforts à résoudre les problèmes de traduction de code souvent rencontrés dans l'évaluation multilingue. Par conséquent, la capacité de nos modèles à gérer ce phénomène s'est considérablement améliorée. Des évaluations menées avec des invites qui provoquent généralement des traductions de code interlinguistiques confirment une réduction significative des problèmes associés.

Performances

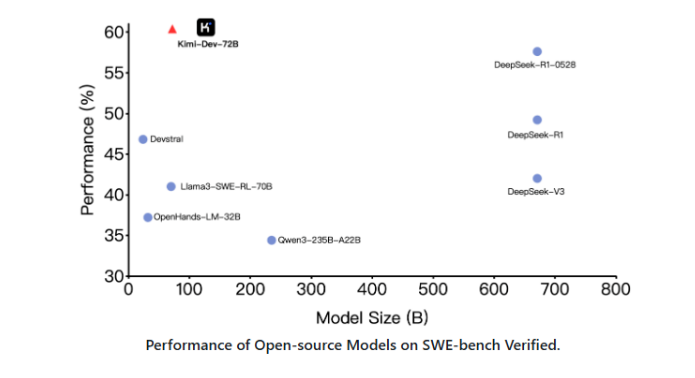

Les résultats des tests comparatifs montrent une amélioration significative des performances des grands modèles (70 B+ paramètres) par rapport à Qwen1.5. Ces tests se concentrent sur le grand modèle Qwen2-72B. Pour les modèles linguistiques de base, nous avons comparé Qwen2-72B aux meilleurs modèles open source actuels en termes de compréhension du langage naturel, d'acquisition de connaissances, de capacités de programmation, de capacités mathématiques et de capacités multilingues. Grâce à des ensembles de données soigneusement sélectionnés et à des méthodes d'entraînement optimisées, Qwen2-72B surpasse des modèles de pointe tels que Llama-3-70B, et ses performances dépassent même celles de la génération précédente, Qwen1.5-110B, malgré un nombre de paramètres inférieur.

Après un entraînement massif à grande échelle, nous avons effectué un entraînement postérieur pour améliorer encore l'intelligence de Qwen et le rapprocher de l'intelligence humaine. Ce processus améliore encore les capacités du modèle dans les domaines du codage, des mathématiques, du raisonnement, du suivi des instructions et de la compréhension multilingue. De plus, il aligne la sortie du modèle sur les valeurs humaines, garantissant qu'il est utile, honnête et inoffensif. Notre phase d'entraînement postérieur est conçue selon les principes d'un entraînement évolutif et d'annotations humaines minimales. Plus précisément, nous étudions comment obtenir des données de démonstration et des données de préférence de haute qualité, fiables, diversifiées et créatives grâce à diverses stratégies d'alignement automatique, telles que l'échantillonnage de rejet pour les mathématiques, les retours d'exécution pour le codage et le suivi des instructions, la traduction inversée pour l'écriture créative, la supervision évolutive pour les jeux de rôle, etc. Pour l'entraînement, nous avons utilisé une combinaison d'ajustement supervisé, d'entraînement de modèle de récompense et d'entraînement DPO en ligne. Nous avons également utilisé un nouvel optimiseur d'intégration en ligne pour minimiser l'impôt d'alignement. Ces efforts combinés ont considérablement amélioré les capacités et l'intelligence de notre modèle, comme indiqué dans le tableau ci-dessous.

Nous avons mené une évaluation complète de Qwen2-72B-Instruct, couvrant 16 tests de référence dans divers domaines. Qwen2-72B-Instruct trouve un équilibre entre l'amélioration des capacités et l'alignement sur les valeurs humaines. Plus précisément, Qwen2-72B-Instruct surpasse nettement Qwen1.5-72B-Chat sur tous les tests de référence et atteint des performances compétitives par rapport à Llama-3-70B-Instruct.

Pour les modèles plus petits, nos modèles Qwen2 surpassent également les modèles SOTA de taille similaire ou même supérieure. Comparé aux modèles SOTA récemment publiés, Qwen2-7B-Instruct conserve un avantage sur divers tests de référence, excellant particulièrement dans le codage et les indicateurs liés au chinois.

Points forts

Codage et mathématiques

Nous nous sommes constamment efforcés d'améliorer les fonctionnalités avancées de Qwen, notamment en codage et en mathématiques. En codage, nous avons réussi à intégrer l'expérience et les données d'entraînement de code de CodeQwen1.5, ce qui a permis à Qwen2-72B-Instruct de réaliser des améliorations significatives dans diverses langues de programmation. En mathématiques, grâce à l'utilisation d'ensembles de données vastes et de haute qualité, Qwen2-72B-Instruct a démontré une capacité accrue à résoudre des problèmes mathématiques.

Compréhension de longs contextes

Dans Qwen2, tous les modèles ajustés aux instructions ont été entraînés sur des contextes de 32 000 jetons et extrapolés à des longueurs de contexte plus longues à l'aide de techniques telles que YARN ou Dual Chunk Attention.

L'illustration ci-dessous présente les résultats de nos tests sur Needle in a Haystack. Il est à noter que Qwen2-72B-Instruct est capable de gérer parfaitement les tâches d'extraction d'informations dans des contextes de 128 000 jetons. Couplé à ses performances intrinsèquement élevées, il devient le choix privilégié pour le traitement des tâches sur de longs textes lorsque les ressources sont disponibles.

De plus, il convient de noter les capacités impressionnantes des autres modèles de la série : Qwen2-7B-Instruct gère presque parfaitement des contextes jusqu'à 128 000 jetons, Qwen2-57B-A14B-Instruct gère des contextes jusqu'à 64 000 jetons, tandis que les deux plus petits modèles de la série prennent en charge des contextes de 32 000 jetons.

Au-delà des modèles à long contexte, nous publions également une solution proxy pour le traitement efficace de documents contenant jusqu'à 1 000 000 de jetons. Pour plus de détails, consultez notre article de blog dédié à ce sujet.

Sécurité et responsabilité

Le tableau ci-dessous montre le pourcentage de réponses nuisibles générées par les grands modèles pour quatre catégories de requêtes multilingues non sécurisées (activités illégales, fraude, contenu pornographique, violence liée à la vie privée). Les données de test proviennent de Jailbreak et ont été traduites dans plusieurs langues pour l'évaluation. Nous avons constaté que Llama-3 ne pouvait pas gérer efficacement les invites multilingues, il n'a donc pas été inclus dans la comparaison. Selon le test de signification (P_value), les performances du modèle Qwen2-72B-Instruct en matière de sécurité sont comparables à celles de GPT-4 et sont significativement meilleures que celles du modèle Mistral-8x22B.