Transformer-Modelle sind zwar leistungsstark, aber ihre Ineffizienz beim Dekodieren war bisher ein großes Problem. Forscher des Korea Advanced Institute of Science and Technology (KAIST), von LG und DeepMind haben jedoch eine erfreuliche Neuigkeit präsentiert: Sie entwickelten eine neue Transformer-Architektur namens Block Transformer, die die Dekodiergeschwindigkeit um das 10- bis 20-fache erhöht!

Wie ist das möglich? Sie haben den Aufmerksamkeitsmechanismus des Transformers „zerlegt“. Dadurch wird die ineffiziente Methode des ursprünglichen Transformers, bei der für jedes erzeugte Token einmal auf den globalen KV-Cache zugegriffen werden muss, vollständig umgangen.

Die Forscher analysierten die Schwächen des ursprünglichen Transformers: Die GPU-Auslastung lag bei unter 1%, die restlichen 99% wurden für den Speicherzugriff verwendet. Dies ist offensichtlich ineffizient. Daher entwickelten sie den Block Transformer. Diese neue Architektur erzielt durch die Zerlegung in blockbasierte Aufmerksamkeit und innerhalb der Blöcke eine enorme Steigerung des Inferenz-Durchsatzes.

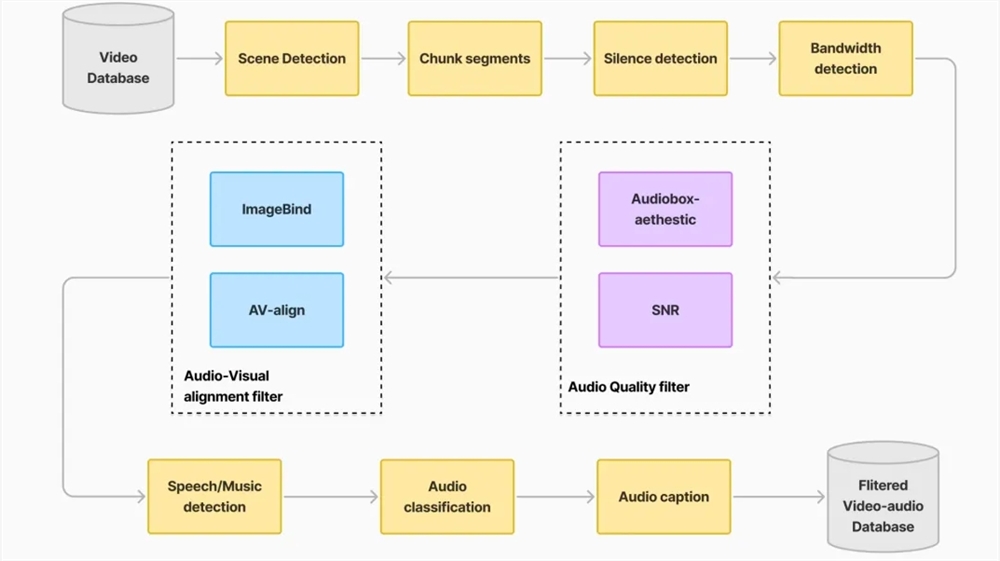

Konkret funktioniert der Block Transformer wie folgt: Zuerst wird die Sequenz in Blöcke unterteilt, dann wandelt der Embedder jeden Block in einen Einbettungsvektor um. Der Block-Decoder verarbeitet die Block-Einbettungsvektoren und erfasst die globalen Abhängigkeiten zwischen den Blöcken; der Token-Decoder verarbeitet die lokalen Abhängigkeiten zwischen den Tokens und generiert die Token-Sequenz.

Diese Methode erhöht nicht nur die Inferenzgeschwindigkeit, sondern reduziert auch den Speicherbedarf erheblich. Einige Nutzer berichteten von ähnlichen Ansätzen, bei denen die Modellleistung jedoch unzureichend war. Die neue Methode scheint den KV-Cache effektiv zu reduzieren.

Darüber hinaus ist die Genauigkeit des Block Transformers bei mehreren Zero-Shot-Aufgaben vergleichbar oder sogar etwas höher als die eines gleich großen ursprünglichen Transformers. Dies beweist, dass die Effizienzsteigerung nicht auf Kosten der Qualität geht.

Die Bedeutung dieser Forschung geht jedoch darüber hinaus. Sie senkt auch die Trainingskosten: Der quadratische Speicheraufwand für den globalen Aufmerksamkeitszugriff wurde um das 16-fache reduziert, und die GPU-Auslastung stieg von 1% auf 44%.