Con el rápido desarrollo de los modelos de lenguaje grandes (MLM), los agentes inteligentes individuales han revelado muchas limitaciones al enfrentarse a tareas reales complejas. Para resolver este problema, la Universidad de Hong Kong y varias instituciones, como camel-ai, han lanzado un nuevo marco de múltiples agentes llamado Workforce, junto con un método de entrenamiento denominado OWL (Aprendizaje del Personal Optimizado). Recientemente, este logro innovador obtuvo una precisión del 69.70% en las pruebas de referencia autorizadas GAIA, no solo estableciendo un récord para sistemas de código abierto, sino también superando varios sistemas comerciales como el de OpenAI Deep Research.

Todos los códigos de este logro se han publicado de manera abierta en GitHub, recibiendo actualmente más de 17,000 "Me gusta", lo que indica el reconocimiento de la comunidad hacia esta innovación.

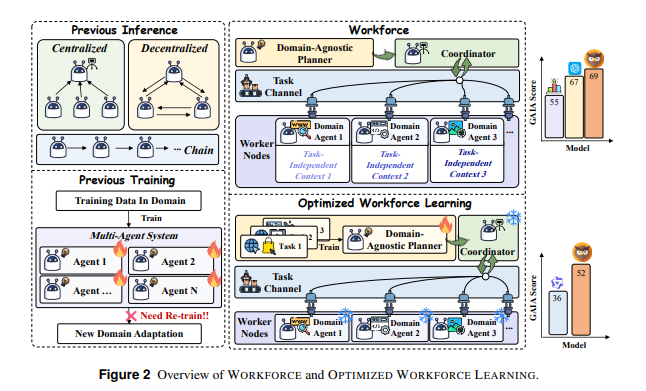

¿Cómo supera el marco Workforce las limitaciones de los sistemas de múltiples agentes? Su núcleo radica en el diseño "descoplado". El sistema se divide en tres componentes clave: planificador independiente del dominio (Agente Planner), coordinador inteligente (Agente Coordinator) y nodos de trabajo especializados (Worker Nodes). Este diseño no solo mejora la flexibilidad del sistema, sino que también reduce significativamente la complejidad de la migración entre dominios. En particular, cuando es necesario adaptarse a nuevos dominios, los usuarios solo necesitan reemplazar o agregar nodos de trabajo, sin tener que modificar completamente el sistema principal.

El método de entrenamiento OWL es otro punto destacado de este marco. Este método adopta una estrategia de entrenamiento en dos etapas: en la primera fase, se realiza un ajuste fino supervisado utilizando datos de demostración de expertos para entrenar inicialmente al planificador; en la segunda fase, se optimiza mediante aprendizaje por refuerzo, mejorando aún más la capacidad de toma de decisiones con el algoritmo DPO (Optimización basada en Preferencias Directas). Esta serie de optimizaciones asegura que el planificador pueda manejar tareas diversificadas del mundo real.

En las pruebas de referencia GAIA, el marco Workforce mostró sus ventajas significativas, especialmente en la inferencia de múltiples agentes, alcanzando una precisión del 69.70%, superando claramente los sistemas de código abierto anteriores. Al mismo tiempo, el método de entrenamiento OWL también logró resultados destacados en las pruebas, mejorando el rendimiento del modelo Qwen2.5-32B-Instruct. Este avance permite que los sistemas de múltiples agentes procesen tareas complejas sin estar limitados por los diseños tradicionales, mostrando una gran capacidad de autocorrección y evolución.

El lanzamiento del marco Workforce no solo ha mejorado el rendimiento general de los sistemas de múltiples agentes, sino que también ha marcado el camino para el futuro desarrollo de asistentes inteligentes.