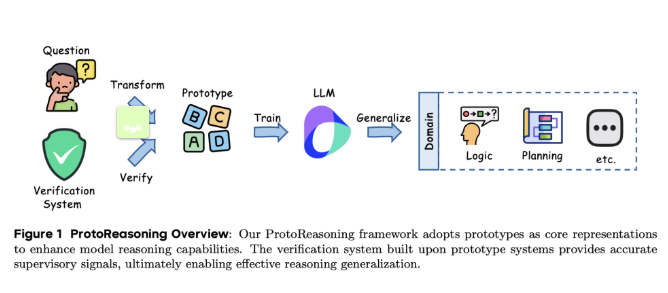

最近、ビットテックの研究チームと上海交通大学のチームは、論理的なプロトタイプを使用して大規模言語モデル(LLMs)の推論能力を強化することを目的とした新しいフレームワーク「ProtoReasoning」を発表しました。このフレームワークは、PrologやPDDLなどの構造化されたプロトタイプ表現を利用して、跨分野の推論の進展を促進しています。

近年、大規模言語モデルは跨分野の推論において顕著な進歩を遂げており、特に長鎖推論技術の応用によります。研究では、これらのモデルが数学やプログラミングなどのタスク処理において、論理的な難題や創造的ライティングなど関係ない分野での優れた能力を示していることが判明しました。しかし、このような柔軟性の背後にある理由はまだ完全には明らかになっていません。一つの可能性として、これらのモデルがコアな推論パターン、つまり跨分野の抽象的な推論プロトタイプを学習したという説があります。これらのプロトタイプは、モデルが異なる形式の問題にうまく対応するのを支援します。

ProtoReasoningフレームワークは、構造化されたプロトタイプ表現を使用してモデルの推論能力を向上させています。これには、主に2つのモジュールがあります:プロトタイプビルダーと検証システムです。プロトタイプビルダーは自然言語の質問を形式化された表現に変換し、検証システムは解答の正しさを確認します。Prologの応用では、研究者たちは4段階のパイプラインを設計し、多様な論理的な問題を生成し、SWI-Prologで検証を行いました。計画タスクの場合、研究チームはPDDLを使用して計画生成、完了、再配置タスクを構築し、VAL検証器で正しさを確認しました。

ProtoReasoningフレームワークの評価では、1500億パラメータを持つエキスパートモデル(そのうち150億はアクティブパラメータ)を使用し、選別された高品質なPrologおよびPDDLサンプルに基づいて訓練されました。結果は、論理推論、計画および多数のベンチマークテストにおいてモデルが大幅に向上していることを示しました。特に、自然言語バージョンとの比較実験では、Prologに基づくトレーニングが論理推論において自然言語バージョンに近い性能を示し、構造化されたプロトタイプトレーニングの有効性をさらに裏付けています。

ProtoReasoningフレームワークは、大規模言語モデルにおける跨分野知識転送を促進するための抽象的な推論プロトタイプの重要な役割を示しています。実験結果は前向きですが、推論プロトタイプの具体的な性質についてはさらなる理論的探求が必要です。今後の研究は、これらの概念を数学的に形式化し、オープンソースモデルとデータセットを使用して検証することを目指します。

論文:https://arxiv.org/abs/2506.15211

ポイント:

🌟 ProtoReasoningフレームワークは、PrologとPDDLを使用して大規模言語モデルの論理的推論能力を向上させます。

🧠 構造化されたプロトタイプ表現により、モデルは論理的推論、計画、および一般的な問題解決タスクで顕著な向上を遂げます。

🔍 今後の研究は、推論プロトタイプの理論的基礎を探り、実験結果の有効性を検証する予定です。