2025年7月4日、昆仑万維は勢いに乗って、第二世代の報酬モデル「Skywork-Reward-V2」シリーズを継続してオープンソース化しました。このシリーズは、異なるベースモデルを基盤とし、パラメータ数が6億から80億に至る8つの報酬モデルで構成されています。リリース後すぐに7つの主要な報酬モデル評価ランキングですべての首位を獲得し、オープンソース報酬モデル分野の注目を集めました。

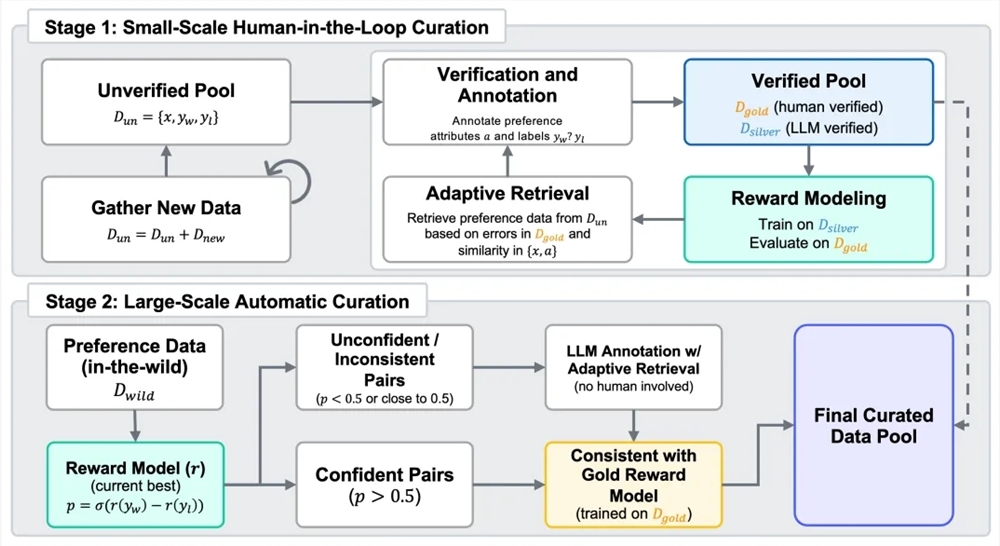

報酬モデルは、人間からのフィードバックを用いた強化学習(RLHF)プロセスにおいて重要な役割を果たします。次世代の報酬モデルを開発するために、昆仑万維は4,000万対の好みの比較データを含む混合データセット「Skywork-SynPref-40M」を構築しました。データ処理においては、人工と機械の協働による二段階のプロセスが採用され、高品質な人間のラベリングとモデルの規模化処理能力が組み合わされました。第一段階では、検証されていない初期の好みプールを構築し、大規模言語モデルを用いて補助的な属性を生成した後、人間のラベラーが厳密なプロトコルおよび外部ツールや大規模言語モデルを用いて一部のデータを詳細に審査し、小規模ながら高品質な「金標準」データセットを作成しました。その後、この金標準データの好みラベルをもとに、大規模言語モデルを活用して高品質な「銀標準」データを大規模に生成し、複数回の反復最適化を行いました。第二段階では、自動化された大規模なデータ拡張に焦点を当て、トレーニング済みの報酬モデルを用いて一貫性フィルタリングを行い、人間のラベリング作業の負担を減らしながら、好みデータの規模と品質のバランスを実現しました。

優れた混合好みデータに基づいて開発された「Skywork-Reward-V2」シリーズは、広範な適用性と優れた能力を示しています。これは、人間の好みの一般的な一致、客観的な正しさ、安全性、スタイルバイアスへの抵抗能力、およびBest-of-N拡張能力などの多様な側面をカバーしています。Reward Bench v1/v2、PPE Preference & Correctness、RMB、RM-Bench、JudgeBenchなど、7つの主要な報酬モデル評価ベンチマークで現在の最高(SOTA)水準に達しています。最小規模のモデルである「Skywork-Reward-V2-Qwen3-0.6B」でも、全体的な性能は前世代の最も強力なモデルの平均レベルにほぼ匹敵し、「Skywork-Reward-V2-Qwen3-1.7B」は現在のオープンソース報酬モデルのSOTAを上回っています。最大規模の「Skywork-Reward-V2-Llama-3.1-8B」は、すべての主要なベンチマークテストで全面的に優位を保ち、現在の最も優れたオープンソース報酬モデルとなっています。

このシリーズモデルは、多様な人間の好みを広くカバーする能力も備えています。汎用的な好み評価ベンチマークでは、より多くのパラメータを持つモデルや最新の生成型報酬モデルよりも優れています。客観的な正しさの評価においては、知識を要するタスクでの表現が特に優れています。また、Best-of-Nタスク、バイアス抵抗能力テスト、複雑な指示理解、そして真実性判断などの高度な能力評価においても、優れた成績を収め、非常に優れた一般化能力と実用性を示しています。

さらに、データ選定プロセスの高い拡張性により、報酬モデルの性能が顕著に向上しました。精緻に選別とフィルタリングされた好みデータは、複数ラウンドの反復トレーニングを通じてモデル全体の性能を継続的に向上させ、特に第二段階の完全自動データ拡張においてその効果が顕著です。初期バージョンの実験結果によると、わずか1.8%の高品質なデータで8B規模のモデルをトレーニングした場合でも、現在の70B級SOTA報酬モデルを上回ることが確認され、Skywork-SynPrefデータセットが規模と品質の両方で優れていることを証明しています。

HuggingFaceアドレス:

https://huggingface.co/collections/Skywork/skywork-reward-v2-685cc86ce5d9c9e4be500c84

GitHubアドレス:

https://github.com/SkyworkAI/Skywork-Reward-V2