ExllamaV2:一个用于在现代消费GPU上运行本地LLM的推理库

站长之家

本文来自AIbase日报

欢迎来到【AI日报】栏目!这里是你每天探索人工智能世界的指南,每天我们为你呈现AI领域的热点内容,聚焦开发者,助你洞悉技术趋势、了解创新AI产品应用。

欢迎来到【AI日报】栏目!这里是你每天探索人工智能世界的指南,每天我们为你呈现AI领域的热点内容,聚焦开发者,助你洞悉技术趋势、了解创新AI产品应用。

在全球人工智能行业迅速发展的浪潮中,美国 AI 创业公司 Anthropic 于6月24日正式宣布,将于今秋在东京开设其首个亚太地区办事处。这一消息无疑为日本以及整个亚太地区的人工智能生态注入了新的活力。Anthropic 成立于2020年,致力于开发以人类为中心的 AI 技术,其理念是通过构建安全和可控的人工智能系统,推动科技更好地服务于社会。公司在这一领域的努力备受瞩目,曾获得多轮融资,并与全球各大科技巨头合作,探索 AI 的更多可能性。东京作为全球科技创新的重要城市,拥有丰富的

科大讯飞正式推出了星火医疗大 V2.5国际版,标志着医疗人工智能领域的一次重要突破。这款模型是业界唯一基于全国产算力训练的医疗大模型,显示出中国在这一领域的领先地位。根据权威评测平台 MedBench 的最新排名,星火医疗大模型以98.4分的优异成绩位列综合能力榜首,显示出其卓越的性能。此次发布的星火医疗大模型 V2.5国际版,不仅提升了全科诊疗能力,还扩展了各专科的诊断推理能力。这一进展得益于大模型深度融合的快思考与循证长思维链慢思考能力,使其能够在心血管内科

近日,VectorSpaceLab在Hugging Face平台正式开源全能多模态模型OmniGen2,以创新性双组件架构和强大的视觉处理能力,为研究者和开发者提供了高效的可控生成式AI基础工具。这款模型由30亿参数的视觉语言模型(VLM)Qwen-VL-2.5与40亿参数的扩散模型组合而成,通过冻结的VLM解析视觉信号和用户指令,结合扩散模型实现高质量图像生成,在视觉理解、文本生成图像、指令引导图像编辑和上下文生成四大核心场景中展现出领先性能。 作为开源项目,OmniGen2的视觉理解能力继承自Qwen-VL-2.5的强大基础,

近日,DeepSite V2迎来重大更新,正式支持最新的 DeepSeek-R1-0528模型,为用户带来更强大的代码生成能力和实时预览体验。AIbase编辑部整理了最新动态,深入剖析这一工具如何通过自然语言生成复杂网页代码,助力开发者与非专业用户实现创意落地。体验地址:https://deepsite.hf.co/projects/newDeepSite V2:AI驱动的网页生成利器DeepSite 是一款基于 DeepSeek 系列大模型的开源 AI 前端开发工具,由 Hugging Face 社区开发并托管。最新发布的 DeepSite V2集成了性能更强的 DeepSeek-R1-0528模型,利用其卓越的推理与代码

赚钱思路利用AI工具生成独特的解压视频,如将水果变成玻璃形态切开等,吸引观众获取流量,进而通过平台广告分成、品牌合作等方式变现。适合人群对视频创作有兴趣,熟悉短视频平台规则,想通过创意内容获取收益的人群,包括但不限于自媒体创作者、兼职视频制作人等。上手难度中等。需要掌握一定的AI工具使用方法以及视频平台操作技巧,但工具使用门槛相对不高。操作流程方法根据AI生成工具豆包或者即梦,输入想要生成的图片提示词,例如:摄影大师杰作,超写实,晶莹剔透

据媒体报道,韩联社援引韩国科技部向总统国政规划委员会报告的计划称,韩国政府将在未来 5 年内在人工智能领域投入16. 1 万亿韩元。保障 5 万颗GPU安全供应,打造AI数据中心。支持人工智能模型的开发,使其对所有公民开放。

近日,OpenAI宣布与美国国防部达成了一项重磅合作,获得了一份价值2亿美元的为期一年的合同。这项合同旨在为国防部开发先进的人工智能工具,帮助应对一系列国家安全挑战。五角大楼在声明中指出,这项工作将主要在华盛顿及其周边地区进行,预计将于2026年7月完成。这是OpenAI首次与美国国防部签署合同,标志着其在国家安全领域的深入布局。随着全球安全形势的不断变化,人工智能技术在军事和安全领域的应用愈发重要。五角大楼表示,OpenAI 将致力于开发前沿的 AI 原型,以应对作

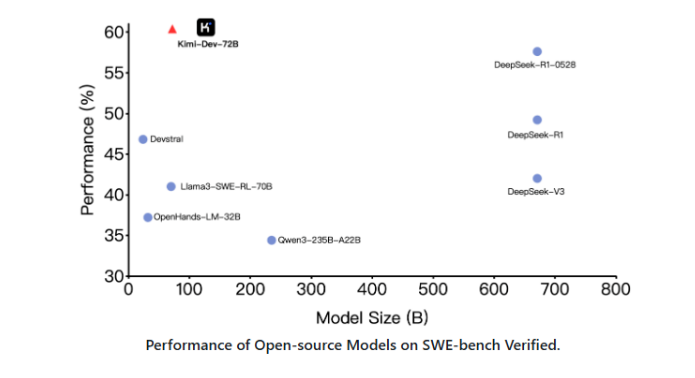

一款名为 Kimi-Dev-72B 的开源代码大型语言模型(LLM)现已推出,旨在革新软件工程领域的问题解决方式。该模型在 SWE-bench Verified 基准测试中展现出最先进的性能,尤其擅长自主修复 Docker 环境中的真实代码仓库。Kimi-Dev-72B 的核心优势在于其通过大规模强化学习进行优化。它能够独立识别并修复代码缺陷,并在整个测试套件通过时获得奖励,从而确保所提供的解决方案不仅正确,而且鲁棒。该项目已在 Hugging Face 和 GitHub 上开源,开发者可以自由下载和部署。Kimi-Dev-72B 提供了一个简化的两阶

美国国防部(DoD)与人工智能公司 OpenAI 达成了一项高达2亿美元的试点项目合同,旨在开发 “前沿人工智能” 能力。不过,目前尚不清楚具体的合作内容。这一消息在周一的国防部新合同公告中披露,合同金额中 OpenAI 将立即获得200万美元的资金,其余款项将在后续支付。图源备注:图片由AI生成,图片授权服务商Midjourney根据国防部的公告,这项合同将用于开发原型前沿人工智能能力,以应对国家安全中的关键挑战,包括战斗和企业领域的需求。OpenAI 在一篇博客中提到,该合作将探索如

近日,字节跳动推出了一款革命性的AI视频生成模型Seaweed APT2,其在实时视频流生成、互动相机控制及虚拟人类生成方面的突破引发了业界热议。这款模型以其高效的性能和创新的交互特性,被誉为“通往虚拟全息甲板(HoloDeck)的重要一步”。Seaweed APT2:实时视频生成新标杆Seaweed APT2是字节跳动Seed团队开发的一款8亿参数的生成式AI模型,专为实时交互视频生成设计。相较于传统视频生成模型,Seaweed APT2采用自回归对抗后训练(AAPT)技术,通过单次网络前向评估(1NFE)生成包含4帧视频的潜空