Im August 2024 hat iFLYTEK offiziell die „Spark Ultra-Human-Interaktions-Technologie“ vorgestellt. Durch eine End-zu-End-Sprachmodellierung und eine mehrdimensionale Emotionsdekompositionstraining erreicht diese Technologie drei Kernfortschritte: Reaktionsgeschwindigkeit, emotionale Resonanz und kontrollierbare Sprachausgabe. Die Technologie kann präzise die Emotionswellen in der Benutzerstimme erkennen und mit passendem Tonfall in Echtzeit antworten. Zudem unterstützt sie dynamische Anpassungen von Sprechgeschwindigkeit, Stimmtönung und Charakterdarstellung und markiert damit eine sprunghafte Verbesserung der Sprachinteraktion von „Funktionalität“ zu „emotionalem Kontakt“.

Bisher ist die API für ultra-menschliche Interaktion auf der iFLYTEK-Entwicklerplattform offiziell gestartet, wodurch Entwickler die Technologie kostengünstig nutzen können. In der Spielbranche können NPCs ihre Dialogstrategien entsprechend der Spielerstimmung anpassen; im Bildungsbereich kann der AI-Sprachpartner realistische Reaktionen eines Fremdsprachlehrers simulieren; in der Tourismusbranche entstanden „digitale Reisebegleiter“, die tiefgründige Interaktionen durch Rollenspiel mit Touristen ermöglichen. Ein Pilotprojekt eines Parks zeigte, dass der Touristen-AI mit dieser Technologie die Verweildauer um 40 % erhöhte und die Wiederkaufsrate um 25 % steigerte.

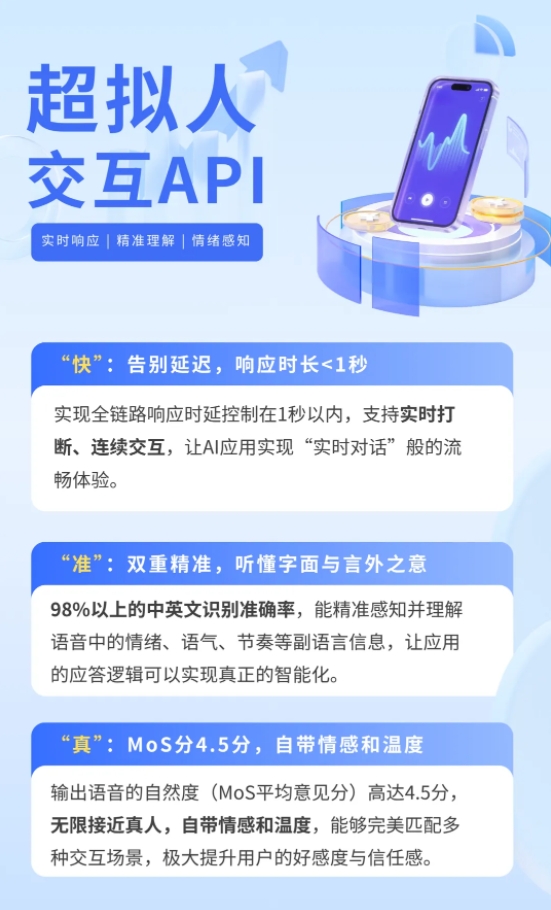

Konventionelle Sprachinteraktionsysteme verwenden eine „Spracherkennung - großes Modellverarbeitung - Sprachsynthese“-Kette, was zu einer durchschnittlichen Reaktionszeit von über 3 Sekunden führt. Die Emotionstransfer wird über Textinhalte abgebildet und es ist schwierig, Nebensprachelemente wie Tonfall oder Rhythmus in der Sprache zu erfassen. Die Spark Ultra-Human-Interaktions-Technologie verwendet einen einheitlichen neuronalen Netzwerkrahmen, um direkt eine End-zu-End-Sprachmodellierung von Sprache zu Sprache zu erreichen: Nachdem das Sprachsignal durch einen Audio-Encoder Merkmale extrahiert hat, wird es mit der Textsemantik abgeglichen und dann vom multimodalen großen Modell zur Vorhersage der Ausgabemerkmale genutzt. Schließlich generiert der Audio-Decodierer eine synthetische Sprache mit natürlicher Emotion und präzisem Rhythmus. Diese Innovation reduziert die Interaktionsverzögerung auf weniger als 0,5 Sekunden und verändert den Reaktionsmodus von „Sie fragen, ich antworte“ zu „Echtzeit-Dialog“.

Um echte emotionale Resonanz zu erreichen, hat das Technikteam ein System zur Dekomposition der vielfältigen Sprachmerkmale entwickelt, bei dem Inhalte, Emotionen, Sprache, Stimmtönung und Rhythmus getrennt trainiert werden. Durch Vergleichslernen und Masken-Vorhersage kann das System die Emotionen wie Freude, Wut oder Angst in der Sprache genau erkennen und die Antwortstrategie automatisch anpassen. Zum Beispiel wird, wenn ein Nutzer eilig nach einem Weg fragt, der AI mit ruhiger Stimme schnell einen Weg planen; wenn ein Nutzer eine lustige Geschichte teilt, wird der AI mit lockeren Tonfall das Thema erweitern. Darüber hinaus können Entwickler über die API die Charakterdarstellung des AI selbst anpassen, sodass es bestimmte Werte, Sprachstil oder sogar künstliche Stimmen berühmter Persönlichkeiten simulieren kann.