Hace poco, el equipo de inteligencia artificial de voz de Alibaba anunció el lanzamiento como código abierto del primer modelo de generación de audio en el mundo que admite razonamiento en cadena, ThinkSound. Este modelo, al introducir la tecnología de cadena de pensamiento (Chain-of-Thought), supera las limitaciones de las tecnologías tradicionales de conversión de video a audio que dependen de la captura dinámica de imágenes, logrando así una generación de audio espacial de alta fidelidad y fuerte sincronización. Este avance marca un salto cualitativo en la tecnología de audio de IA, pasando de "sincronizar sonido con imágenes" a "entender estructuralmente las imágenes".

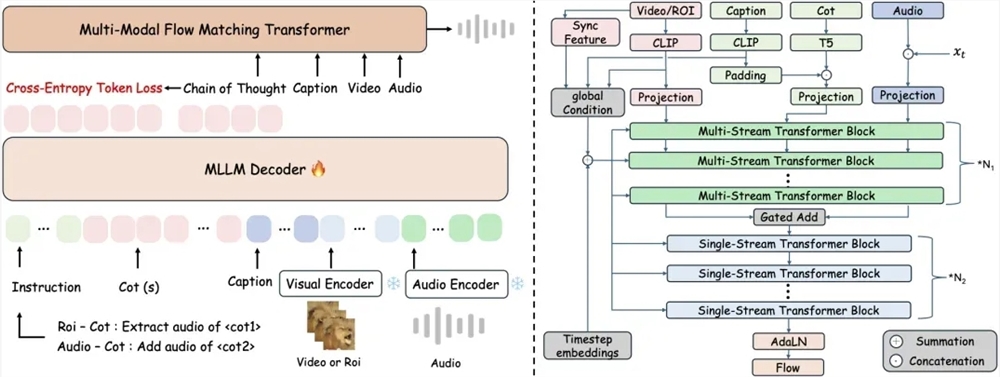

Las tecnologías tradicionales de conversión de video a audio en un solo paso suelen ignorar las relaciones espaciales y temporales entre los detalles visuales y los sonidos, lo que lleva a que los sonidos generados no coincidan con los eventos visuales. ThinkSound es el primero en combinar modelos de lenguaje multimodal con una arquitectura unificada para la generación de audio, logrando una síntesis precisa de sonidos mediante un mecanismo de razonamiento en tres etapas: primero, el sistema analiza el movimiento general de la imagen y el significado del escenario, generando una cadena de razonamiento estructurada; luego, se enfoca en las áreas específicas de las fuentes de sonido, combinando descripciones semánticas para definir características de sonido; finalmente, permite a los usuarios editar en tiempo real mediante instrucciones en lenguaje natural, como "añadir el sonido de hojas susurrantes después del canto de los pájaros" o "eliminar el ruido de fondo".

Para respaldar la capacidad de razonamiento estructurado del modelo, el equipo de investigación creó el conjunto de datos multimodal AudioCoT, que contiene 2531,8 horas de muestras de alta calidad, integrando sonidos reales de escenas como los cantos de animales y el funcionamiento de maquinaria provenientes de fuentes como VGGSound y AudioSet. El conjunto de datos garantiza la calidad mediante filtrado automático en varias etapas y verificación manual de muestras, y especialmente diseñó muestras a nivel de objeto y a nivel de instrucción, permitiendo al modelo manejar instrucciones complejas como "extraer el canto de un búho evitando la interferencia del viento".

Los datos experimentales muestran que ThinkSound mejora más del 15% en los indicadores principales del conjunto de prueba VGGSound en comparación con los métodos principales, y su rendimiento es significativamente superior al de los modelos similares de Meta en el conjunto de pruebas MovieGen Audio Bench. Actualmente, el código y los pesos preentrenados del modelo están disponibles en GitHub, HuggingFace y la comunidad ModelScope, y los desarrolladores pueden obtenerlos gratuitamente.

El equipo de inteligencia artificial de voz de Alibaba reveló que, en el futuro, se centrará en mejorar la comprensión del modelo ante entornos acústicos complejos y expandirlo a escenarios inmersivos como el desarrollo de juegos y la realidad virtual. Esta tecnología no solo proporciona nuevas herramientas para la producción de efectos de sonido en cine y la postproducción de audio, sino que podría redefinir los límites de la experiencia auditiva en la interacción humano-máquina. Expertos de la industria señalan que el código abierto de ThinkSound acelerará la difusión tecnológica en el campo de la generación de audio, impulsando la economía creativa hacia una dirección más inteligente.

Dirección del código abierto:

https://github.com/FunAudioLLM/ThinkSound

https://huggingface.co/spaces/FunAudioLLM/ThinkSound

https://www.modelscope.cn/studios/iic/ThinkSound