Hace unos días, el equipo Seed de ByteDance colaboró con la Universidad de Hong Kong y la Universidad Fudan para lanzar un nuevo método innovador de entrenamiento de aprendizaje por refuerzo llamado POLARIS. Este método logró mejorar significativamente las capacidades de razonamiento matemático de los modelos pequeños mediante una estrategia de escalado de aprendizaje por refuerzo cuidadosamente diseñada, ofreciendo así una nueva ruta para la optimización de modelos pequeños en el campo de la inteligencia artificial.

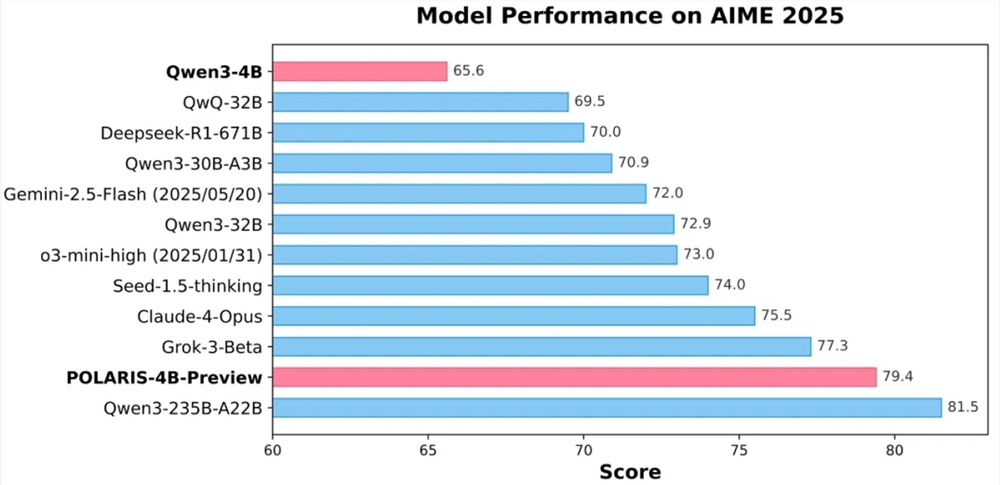

Los resultados experimentales muestran que el modelo de código abierto Qwen3-4B de 4 mil millones de parámetros entrenado con POLARIS obtuvo tasas de precisión altas del 79,4% y 81,2% en las pruebas matemáticas AIME25 y AIME24 respectivamente, superando a algunos modelos cerrados más grandes. Destaca especialmente el diseño ligero del modelo POLARIS-4B, lo que le permite desplegarse fácilmente en tarjetas gráficas de nivel de consumo, reduciendo significativamente la barrera de aplicación.

La innovación central de POLARIS radica en su estrategia de entrenamiento. El equipo de investigación descubrió que al personalizar los datos de entrenamiento y los hiperparámetros del modelo en desarrollo, se puede mejorar significativamente la capacidad de razonamiento matemático del modelo pequeño. En la práctica, el equipo ajustó dinámicamente la distribución de dificultad de los datos de entrenamiento, creando un conjunto de datos ligeramente sesgado hacia problemas difíciles, evitando así que la dificultad de las muestras esté demasiado concentrada. Además, se introdujo una estrategia de actualización dinámica de los datos, eliminando en tiempo real las muestras demasiado fáciles según el rendimiento del modelo durante el entrenamiento, asegurando así la eficacia del entrenamiento.

En cuanto al control de muestreo, POLARIS equilibra el rendimiento del modelo y la diversidad de las rutas de generación regulando finamente la temperatura de muestreo. Se descubrió que la temperatura de muestreo tiene un impacto significativo en el rendimiento del modelo y la diversidad de las rutas. Una temperatura demasiado alta o baja no es favorable para el entrenamiento del modelo. Por lo tanto, el equipo propuso un método de inicialización de temperatura que controla la región de exploración y ajustó dinámicamente la temperatura de muestreo durante el entrenamiento para mantener la diversidad del contenido generado.

Para abordar los desafíos del entrenamiento con contextos largos, POLARIS introdujo una tecnología de extrapolación de longitud, ajustando el codificador de posición RoPE para que el modelo pueda procesar secuencias más largas que las vistas durante el entrenamiento. Esta estrategia innovadora compensó efectivamente las deficiencias en el entrenamiento de textos largos, mejorando el rendimiento del modelo en tareas de generación de texto largo.

Además, POLARIS utilizó un método de entrenamiento de RL en varias etapas, entrenando inicialmente con ventanas de contexto cortas y aumentando gradualmente la longitud de la ventana de contexto una vez que el modelo muestra un buen rendimiento. Esta estrategia ayuda al modelo a adaptarse gradualmente a tareas de razonamiento más complejas, mejorando la estabilidad y el efecto del entrenamiento.

Actualmente, el método de entrenamiento detallado de POLARIS, los datos de entrenamiento, el código de entrenamiento y los modelos experimentales están completamente disponibles como código abierto. El equipo de investigación validó la eficacia de POLARIS en varios conjuntos de evaluación principales de razonamiento, y los resultados muestran que el rendimiento de los modelos de diferentes tamaños y familias de modelos mejora significativamente al aplicar el método de entrenamiento POLARIS.

Página de inicio de GitHub:

https://github.com/ChenxinAn-fdu/POLARIS

Página de inicio de Hugging Face:

https://huggingface.co/POLARIS-Project