L'entraînement de grands modèles d'IA (tels que les Transformers et les modèles linguistiques) est devenu une étape essentielle dans le domaine de l'IA, mais il est confronté à des coûts de calcul, une consommation de mémoire et des besoins énergétiques élevés. Par exemple, GPT-3 d'OpenAI, avec ses 175 milliards de paramètres, nécessite plusieurs semaines d'entraînement sur GPU. Cette énorme demande de ressources limite l'utilisation de cette technologie aux organisations disposant de ressources informatiques massives, et suscite des inquiétudes quant à l'efficacité énergétique et à l'impact environnemental. Résoudre ces défis est crucial pour assurer une accessibilité et une durabilité plus larges du développement de l'IA.

Les méthodes d'entraînement traditionnelles sont inefficaces et des solutions innovantes sont nécessaires.

L'inefficacité de l'entraînement des grands modèles est principalement due à leur dépendance aux matrices denses, qui nécessitent une grande quantité de mémoire et de puissance de calcul. La prise en charge limitée des opérations de faible précision ou de faible rang optimisées sur les GPU modernes aggrave encore ces besoins. Bien que des méthodes telles que la décomposition matricielle et la réduction de rang heuristique aient été proposées pour atténuer ces problèmes, elles restent limitées dans les applications pratiques. Par exemple, GaLore peut effectuer l'entraînement en mode lot unique, mais présente des coûts d'exécution irréalistes. De même, LTE, utilisant des adaptateurs de faible rang, pose des problèmes de convergence sur les tâches de grande envergure. Il manque actuellement une méthode capable de réduire simultanément l'utilisation de la mémoire, les coûts de calcul et le temps d'entraînement sans compromettre les performances, ce qui rend la demande de solutions innovantes urgente.

Le framework CoMERA : un entraînement efficace grâce à l'optimisation des tenseurs adaptatifs

Des chercheurs de l'Université d'Albany (Université d'État de New York), de l'Université de Californie à Santa Barbara, d'Amazon Alexa AI et de Meta ont présenté un nouveau framework appelé CoMERA (Computing-and Memory-Efficient training method via Rank-Adaptive tensor optimization). Ce framework combine efficacité mémoire et vitesse de calcul grâce à une technique de compression de tenseurs de rang adaptatif. Contrairement aux méthodes traditionnelles qui se concentrent uniquement sur la compression, CoMERA utilise une méthode d'optimisation multi-objectifs pour équilibrer le taux de compression et la précision du modèle. Il exploite les plongements tensoriels et la contraction avancée des réseaux tensoriels pour optimiser l'utilisation du GPU, réduisant ainsi les coûts d'exécution tout en maintenant des performances élevées. Le framework introduit également des graphes CUDA pour minimiser les latences de lancement de noyaux pendant les opérations GPU, un goulot d'étranglement majeur des méthodes de compression tensorielle traditionnelles.

CoMERA repose sur une représentation tensorielle adaptative, qui permet aux couches du modèle d'ajuster dynamiquement leur rang en fonction des contraintes de ressources. En modifiant le rang tensoriel, le framework permet la compression sans compromettre l'intégrité des opérations du réseau neuronal. Cette optimisation dynamique est réalisée grâce à un processus d'entraînement en deux phases :

Phase préliminaire : axée sur une convergence stable.

Phase finale : ajustement fin du rang pour atteindre un objectif de compression spécifique.

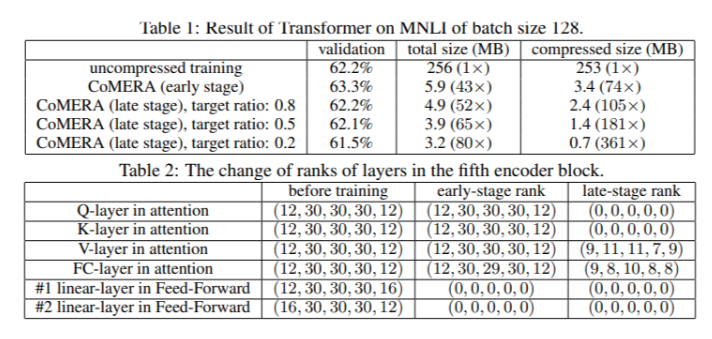

Dans un modèle Transformer à six encodeurs, CoMERA a atteint un taux de compression allant jusqu'à 43 fois lors de sa phase préliminaire, et jusqu'à 361 fois lors de sa phase d'optimisation finale. De plus, par rapport à GaLore, il a réduit la consommation de mémoire de 9 fois et a accéléré la vitesse d'entraînement par itération de 2 à 3 fois.

De multiples résultats de tests montrent l'excellence des performances de CoMERA

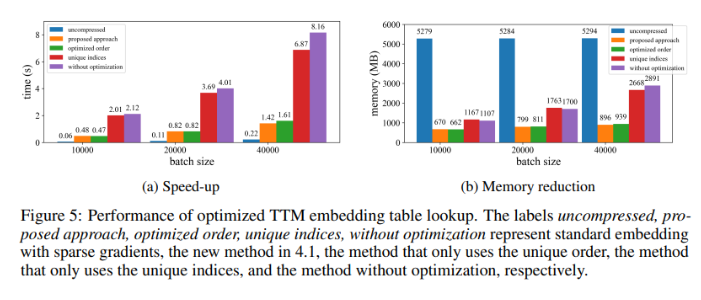

Lorsqu'il est appliqué à un modèle Transformer entraîné sur l'ensemble de données MNLI, CoMERA a réduit la taille du modèle de 256 Mo à seulement 3,2 Mo, tout en maintenant la précision. Dans les systèmes de recommandation à grande échelle tels que DLRM, CoMERA a compressé le modèle de 99 fois et a réduit la consommation de mémoire maximale de 7 fois. Le framework a également excellé dans le pré-entraînement de CodeBERT (un grand modèle linguistique spécifique à un domaine), obtenant un taux de compression global de 4,23 fois et une accélération de 2 fois lors de certaines phases d'entraînement. Ces résultats soulignent sa capacité à gérer diverses tâches et architectures, étendant son applicabilité à divers domaines.

Résumé des principaux avantages du framework CoMERA

Les principales conclusions de cette étude sont les suivantes :

CoMERA a permis d'atteindre un taux de compression allant jusqu'à 361 fois pour des couches spécifiques et jusqu'à 99 fois pour le modèle entier, réduisant considérablement les besoins de stockage et de mémoire.

Le framework a réduit le temps d'entraînement par itération des modèles Transformer et des systèmes de recommandation de 2 à 3 fois, économisant ainsi des ressources de calcul et du temps.

Grâce à l'utilisation de représentations tensorielles et de graphes CUDA, CoMERA a réduit la consommation de mémoire maximale de 7 fois, permettant l'entraînement sur des GPU plus petits.

La méthode CoMERA prend en charge plusieurs architectures, notamment les Transformers et les grands modèles linguistiques, tout en maintenant ou en améliorant la précision.

En réduisant l'énergie et les ressources nécessaires à l'entraînement, CoMERA contribue à des pratiques d'IA plus durables et permet à un public plus large d'utiliser des modèles de pointe.