Des médias étrangers ont récemment mis en doute les résultats élevés en mathématiques du modèle Qwen2.5 d'Alibaba, soulignant que sa capacité apparente à raisonner en mathématiques provient peut-être principalement de la mémoire des données d'entraînement, plutôt que d'un véritable raisonnement. Les chercheurs ont découvert par une série de tests rigoureux que la contamination des données pourrait être le facteur clé expliquant les performances exceptionnelles de Qwen2.5 sur certaines bases de test.

La contamination des données devient visible : une chute brutale des performances sur une base propre

La découverte centrale de l'étude est que lorsqu'on teste le modèle Qwen2.5 sur des bases "propres" qu'il n'a jamais vues pendant son entraînement, ses performances chutent brusquement. Cela indique que les progrès observés sur les bases contaminées sont en grande partie dus au fait que le modèle avait déjà eu accès à ces données pendant son entraînement.

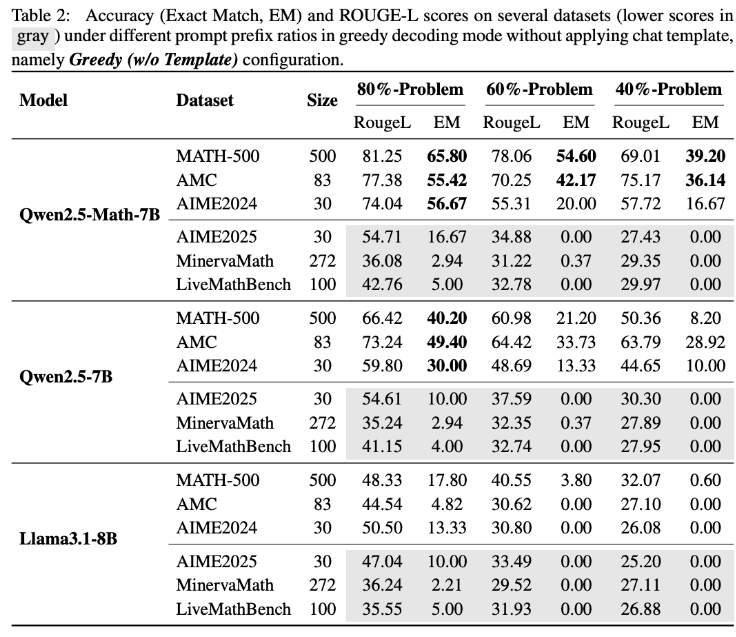

Pour vérifier cette hypothèse, l'équipe de recherche a mené une expérience innovante : elle a fourni uniquement les 60 % premières questions de la base MATH500 au modèle Qwen2.5-Math-7B et lui a demandé de compléter les 40 % restants. Le résultat fut choquant : Qwen2.5-Math-7B a réussi à reconstruire la partie manquante avec un taux d'exactitude allant jusqu'à 54,6 % (un taux de bonnes réponses de 53,6 %). En comparaison, Llama3.1-8B n'a obtenu qu'un taux d'exactitude de 3,8 % (un taux de bonnes réponses de 2,4 %). Cette différence marquée suggère fortement que Qwen2.5 avait déjà vu ces questions pendant son entraînement.

Test LiveMathBench : le taux de réussite de Qwen2.5 tombe à zéro

Les chercheurs ont ensuite testé Qwen2.5 avec LiveMathBench (version 202505), une base de test "propre" apparue après la sortie de Qwen2.5, ce qui signifie que Qwen2.5 n'avait pas pu avoir accès aux données de cette base pendant son entraînement. Sur cet ensemble de données nouveau, le taux de réussite de Qwen2.5 est tombé à zéro, se situant à un niveau comparable à celui des modèles Llama, et son taux d'exactitude des réponses n'était plus que de 2 %.

L'étude souligne que Qwen2.5 a probablement été pré-entraîné sur un grand ensemble de données en ligne, incluant des bibliothèques GitHub contenant des problèmes de base et leurs solutions. Ainsi, même si le modèle recevait des signaux de récompense aléatoires ou incorrects pendant l'entraînement, il pouvait améliorer ses performances sur MATH-500 grâce à l'exposition préalable à ces données.

Changements dans les modèles de réponse et vérification des données synthétiques

Des expériences supplémentaires ont montré que lorsque les modèles de réponse changeaient, les performances de Qwen2.5 sur MATH-500 chutaient brusquement, alors que Llama-3.1-8B était presque insensible à ces changements. Cela renforce davantage l'idée que Qwen2.5 dépend fortement de modèles de données spécifiques.

Pour éliminer complètement l'effet de mémoire, l'équipe de recherche a également créé un ensemble de données RandomCalculation comprenant des problèmes arithmétiques entièrement synthétiques générés après la sortie de Qwen2.5. Sur ces nouvelles questions, le taux d'exactitude de Qwen2.5 diminuait avec la complexité des questions. Seuls les signaux de récompense corrects permettaient d'améliorer les performances du modèle, tandis que les récompenses aléatoires entraînaient une instabilité durant l'entraînement, et les récompenses inversées réduisaient même ses compétences en mathématiques. Les expériences contrôlées de RLVR (apprentissage par renforcement avec récompense vérifiable) ont confirmé ces résultats : seules les récompenses correctes apportaient une amélioration stable des performances, tandis que les récompenses aléatoires ou inversées ne parvenaient ni à améliorer ni à augmenter les performances.

Implications pour la recherche future en IA

Ces découvertes soulèvent des doutes sérieux quant à la capacité réelle de Qwen2.5 en mathématiques, suggérant plutôt qu'il dépend fortement des données mémorisées. Alibaba a lancé Qwen2.5 en septembre 2024, puis a lancé la série Qwen3. Il reste à voir si ces résultats s'appliquent également à la série Qwen3.

Les auteurs de l'étude ont averti que les bases de test contaminées peuvent conduire à des conclusions trompeuses sur les progrès de l'intelligence artificielle. Ils insistent sur l'importance d'utiliser des bases propres et non contaminées pour les futures recherches et d'évaluer plusieurs séries de modèles afin d'obtenir des résultats plus fiables.