ChatGPTや文心一言といった高度なAIをご存知ですか?それらの基盤技術は「大規模言語モデル」(LLM)です。複雑で理解しにくいと感じますか?ご心配なく、小学2年生レベルの算数力でも、この記事を読めばLLMの動作原理を簡単に理解できます!

ニューラルネットワーク:数字の魔法

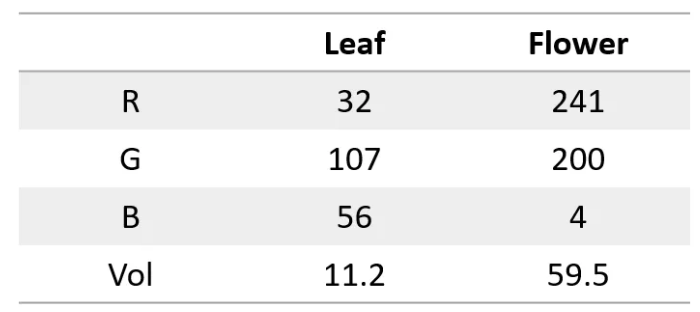

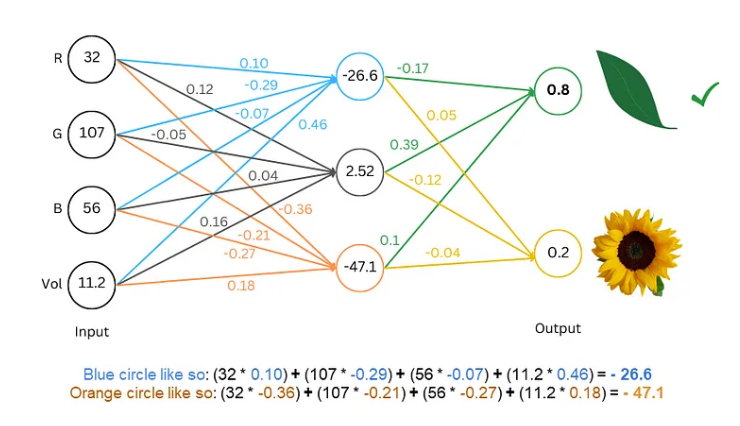

まず、ニューラルネットワークは超強力な計算機のようなもので、数字しか処理できないことを理解しましょう。入力も出力も、数字でなければなりません。では、どのようにして文字を理解させるのでしょうか?

秘訣は、文字を数字に変換することです!例えば、各文字を数字で表すことができます。a=1、b=2、といった具合です。こうすることで、ニューラルネットワークは文字を「理解」できるようになります。

モデルの訓練:ネットワークに言語を「学習」させる

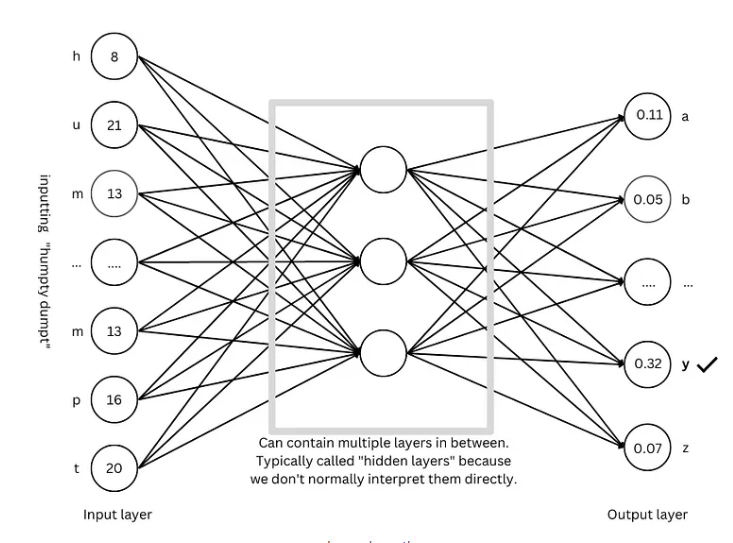

文字を数値化したら、次はモデルを訓練して、ニューラルネットワークに言語のパターンを「学習」させます。

訓練のプロセスは、なぞなぞゲームのようなものです。ネットワークに「Humpty Dumpty」といった文章を見せ、次の文字を予測させます。正しく予測できれば報酬を与え、間違えればペナルティを与えます。この試行錯誤と調整を繰り返すことで、ネットワークは次の文字をますます正確に予測できるようになり、最終的に「Humpty Dumpty sat on a wall」といった完全な文章を生成できるようになります。

高度なテクニック:モデルをより「賢く」する

モデルをより「賢く」するために、研究者たちは多くの高度なテクニックを開発しました。例えば:

単語埋め込み:単純な数字で文字を表すのではなく、各単語を数字の集合(ベクトル)で表すことで、単語の意味をより包括的に記述できます。

サブワードトカナイザ:単語をより小さな単位(サブワード)に分割します。「cats」を「cat」と「s」に分割するなど、これにより語彙数を減らし、効率を向上させることができます。

自己注意機構:モデルは次の単語を予測する際に、文脈内のすべての単語に基づいて予測の重みを調整します。まるで私たちが読書をする際に文脈から単語の意味を理解するようなものです。

残差接続:ネットワークの層数が多すぎると訓練が困難になるため、残差接続を用いてネットワークの学習を容易にします。

マルチヘッド注意機構:複数の注意機構を並列で実行することで、モデルは様々な角度から文脈を理解し、予測の精度を向上させることができます。

位置エンコーディング:モデルに単語の順序を理解させるために、単語埋め込みに位置情報を追加します。まるで私たちが読書をする際に単語の順序に注意を払うようなものです。

GPTアーキテクチャ:大規模言語モデルの「設計図」

GPTアーキテクチャは現在最も普及している大規模言語モデルのアーキテクチャの1つであり、「設計図」のようにモデルの設計と訓練を導きます。GPTアーキテクチャは上記の様々な高度なテクニックを巧みに組み合わせることで、モデルが効率的に言語を学習し生成することを可能にしています。

Transformerアーキテクチャ:言語モデルの「革命」

Transformerアーキテクチャは近年、言語モデル分野における大きなブレークスルーであり、予測精度を向上させるだけでなく、訓練の難易度も低下させ、大規模言語モデルの発展の基礎を築きました。GPTアーキテクチャもTransformerアーキテクチャを基に発展したものです。

参考文献:https://towardsdatascience.com/understanding-llms-from-scratch-using-middle-school-math-e602d27ec876