中国科学院自動化研究所と中科紫東太初チームは共同で、Vision-R1という新しい手法を開発しました。これはR1強化学習技術を用いて、視覚位置特定能力を大幅に向上させるものです。この手法は、物体検出や視覚位置特定などの複雑なタスクにおいて、性能を50%も向上させ、パラメータ規模が10倍以上大きい既存の最先端モデル(SOTA)をも凌駕しました。

現在、画像テキスト大規模モデルは、通常「事前学習+教師あり微調整」の手法に依存して、ユーザー指示への応答能力を高めていますが、この手法は資源消費と訓練効率の点で大きな課題を抱えています。Vision-R1は、高品質な指示整合データと強化学習を組み合わせることで、この状況を一新しました。視覚タスク評価を駆動とした報酬メカニズムを設計することで、モデルの目標位置特定能力を強力にサポートしています。

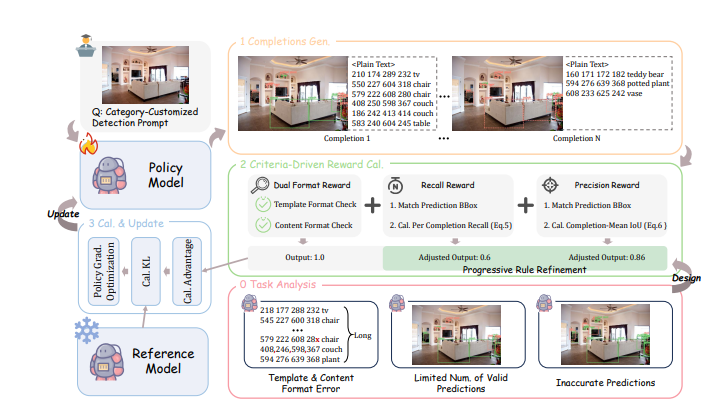

具体的には、Vision-R1の報酬メカニズムは4つの主要部分から構成されています。まず、密集したシーンにおいて予測品質を効果的に評価するために、多目標予測方式を採用しています。次に、長シーケンス予測におけるフォーマットエラー問題を解決するために、二重フォーマット報酬を設計しました。さらに、モデルが可能な限り多くの目標を認識するように、リコール報酬を設けています。最後に、精度報酬によって、モデルが生成する目標ボックスの品質を高めています。これらの設計は相互に作用し、「1+1>2」の最適化効果を生み出し、複雑な視覚タスクにおけるモデルの性能を向上させています。

高品質な目標ボックスを予測するという課題を解決するために、研究チームは漸進的なルール調整戦略も提案しました。報酬計算ルールを動的に調整することで、モデルの性能を継続的に改善させます。訓練プロセスは初級段階と上級段階に分けられ、報酬基準を段階的に引き上げることで、基礎から高精度への移行を実現しています。

一連のテストにおいて、Vision-R1は、古典的な物体検出データセットCOCOと多様なシーンのODINW-13で優れた性能を示しました。基礎性能に関わらず、Vision-R1で訓練されたモデルは性能が大幅に向上し、専門的な位置特定モデルにさらに近づきました。この手法は、画像テキスト大規模モデルの視覚位置特定能力を効果的に向上させるだけでなく、将来のマルチモーダルAIアプリケーションにも新たな方向性を提供します。

プロジェクトアドレス:https://github.com/jefferyZhan/Griffon/tree/master/Vision-R1