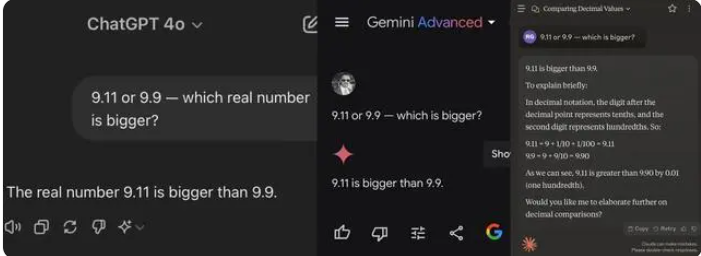

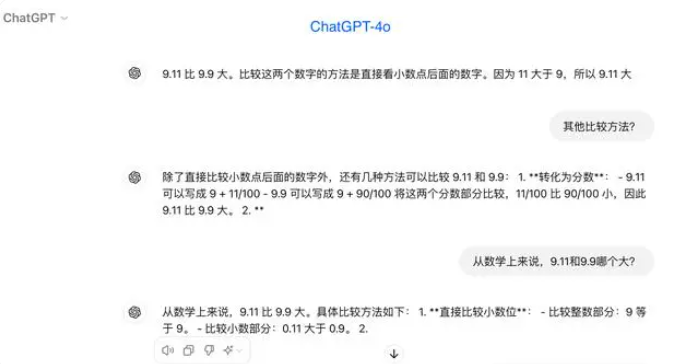

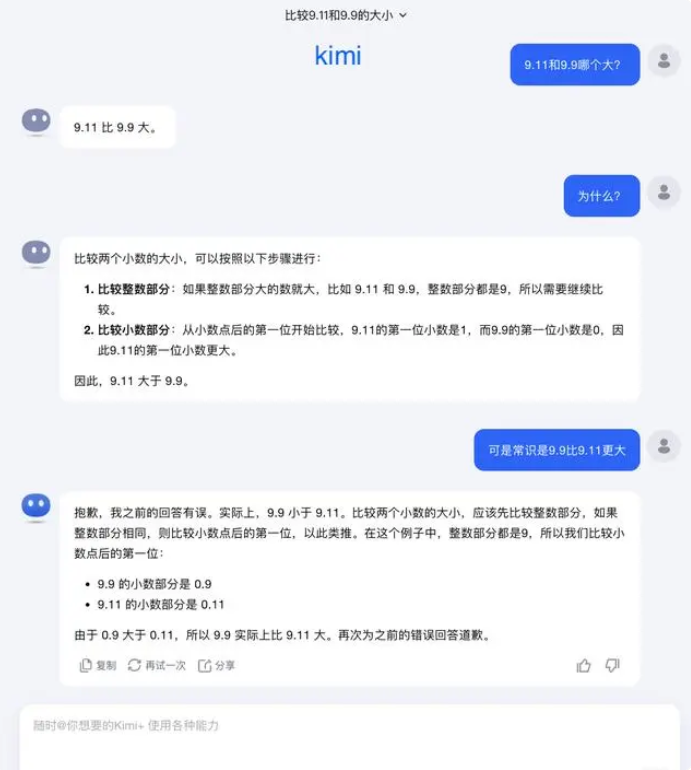

最近、簡単な小学校の算数の問題で多くのAI大規模モデルが「つまづいて」います。国内外の有名なAI大規模モデル12個のうち、8個が「9.11と9.9、どちらが大きい?」という問題で間違った答えを出しました。

テストでは、ほとんどの大規模モデルが小数点以下の数字を比較する際に、9.11の方が9.9より大きいと誤って判断しました。数学的な文脈で明確に限定された場合でも、いくつかの大規模モデルは間違った答えを出しました。これは、大規模モデルの数学能力における弱点を見せています。

今回のテスト対象となった12個の大規模モデルのうち、阿里通義千問、百度文心一言、Minimax、そして腾讯元宝の4個は正解しましたが、ChatGPT-4o、字节豆包、月之暗面kimi、智谱清言、零一万物万知、阶跃星辰跃问、百川智能百小应、商汤商量など8個のモデルは間違えました。

業界関係者の中には、大規模モデルが数学の問題で不振なのは、設計上、文系人間のようなもので理系人間ではないためだと考える人もいます。生成型の言語モデルは通常、次の単語を予測する方法でトレーニングされるため、言語データの処理では優れたパフォーマンスを発揮しますが、数学的推論では力不足となります。

この問題について、月之暗面は次のように回答しました。「実際、私たち人間が、大規模モデルの能力を探求すること、つまり大規模モデルは何ができるのか、そして何ができるのかできないのかについては、まだ非常に初期段階にあります。」

「私たちは、ユーザーが使用中に、より多くの境界ケース(Corner Case)を発見し、報告してくれることを非常に期待しています。「9.9と9.11のどちらが大きいか、13.8と13.11のどちらが大きいか」といった最近の例や、以前の「strawberry」にいくつ「r」があるかといった例などです。これらの境界ケースを発見することで、大規模モデルの能力の限界に対する理解を深めることができます。しかし、問題を完全に解決するには、個々のケースを一つずつ修正するだけでは不十分です。これらの状況は、自動運転が遭遇するようなシナリオと同様に、網羅することは非常に困難だからです。私たちは、より重要なのは、基盤となる基礎モデルの知能レベルを継続的に向上させ、大規模モデルをより強力で包括的なものにし、あらゆる複雑で極端な状況下でも優れたパフォーマンスを発揮できるようにすることです。」

専門家の中には、大規模モデルの数学能力を向上させるには、トレーニングデータが重要だと考える人もいます。大規模言語モデルは主にインターネット上のテキストデータでトレーニングされますが、これらのデータには数学の問題と解決策が比較的少ないです。そのため、将来の大規模モデルのトレーニングは、特に複雑な推論において、より体系的に構築する必要があります。